综合介绍

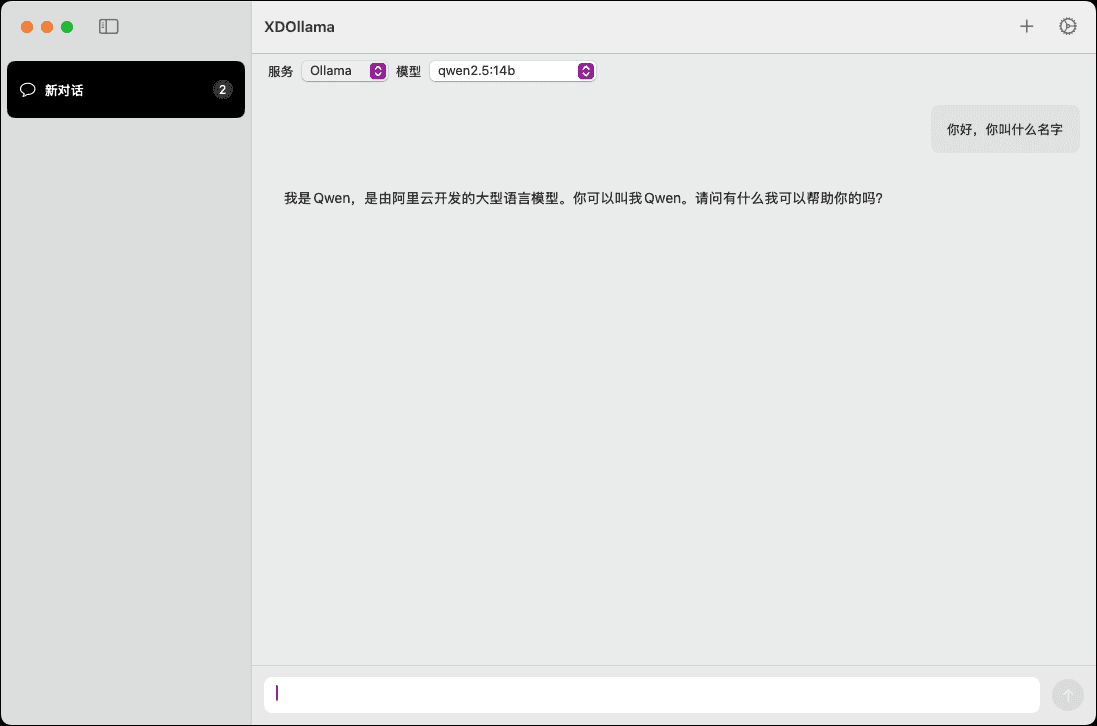

XDOllama 是一款专为 MacOS 用户设计的桌面应用程序,旨在快速调用 Ollama、Dify 和 Xinference 等 AI 模型。该应用程序通过简化的界面和操作流程,使用户能够轻松调用本地或在线的 AI 模型,提升工作效率和使用体验。

功能列表

- 调用本地 Ollama 模型

- 调用在线 Ollama 模型

- 调用本地 Xinference 模型

- 调用在线 Xinference 模型

- 调用本地 Dify 应用

- 调用在线 Dify 应用

- 支持多种 AI 框架

- 简单易用的界面设计

- 高效的模型调用速度

使用帮助

安装流程

- 下载 DMG 文件。

- 双击打开下载的 DMG 文件。

- 将 XDOllama.app 拖入应用程序文件夹。

- 安装完成后,打开应用程序即可使用。

使用指南

- 打开 XDOllama 应用程序。

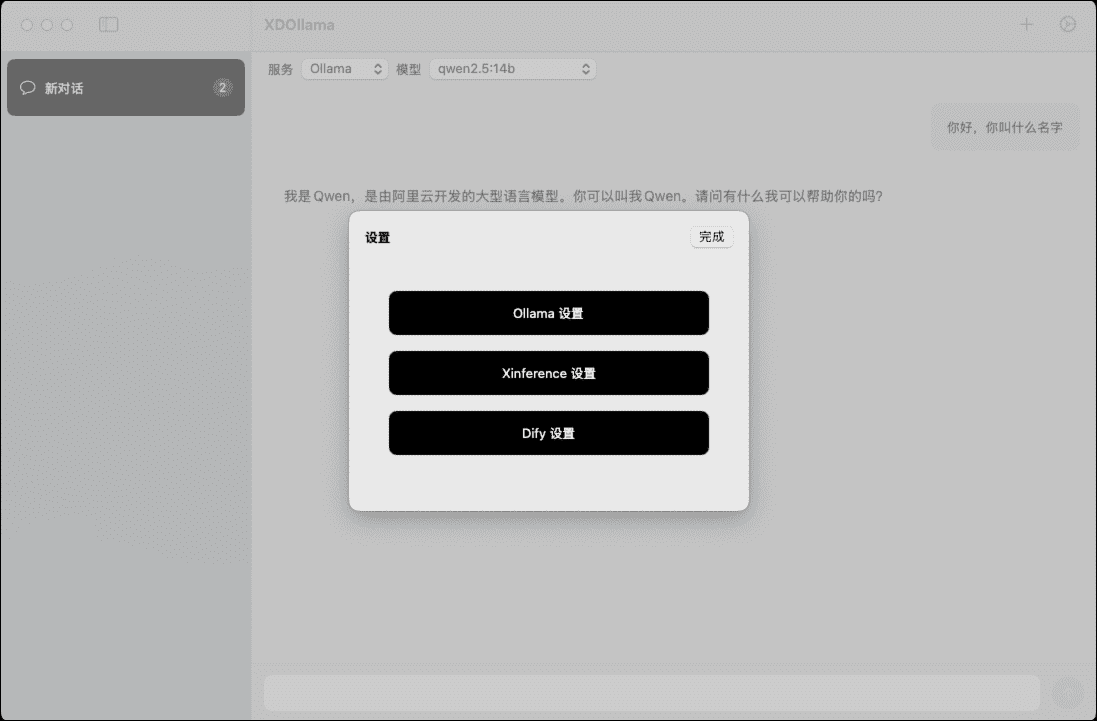

- 选择要调用的 AI 模型(Ollama、Dify 或 Xinference)。

- 选择调用方式(本地或在线)。

- 根据提示输入相关参数和设置。

- 点击“调用”按钮,等待模型加载和运行。

- 查看和使用模型输出结果。

详细功能操作流程

调用本地 Ollama 模型

- 在主界面选择“Ollama”。

- 选择“本地”调用方式。

- 输入模型路径和参数。

- 点击“调用”按钮,等待模型加载。

- 查看模型输出结果。

调用在线 Ollama 模型

- 在主界面选择“Ollama”。

- 选择“在线”调用方式。

- 输入在线模型的 URL 和参数。

- 点击“调用”按钮,等待模型加载。

- 查看模型输出结果。

调用本地 Xinference 模型

- 在主界面选择“Xinference”。

- 选择“本地”调用方式。

- 输入模型路径和参数。

- 点击“调用”按钮,等待模型加载。

- 查看模型输出结果。

调用在线 Xinference 模型

- 在主界面选择“Xinference”。

- 选择“在线”调用方式。

- 输入在线模型的 URL 和参数。

- 点击“调用”按钮,等待模型加载。

- 查看模型输出结果。

调用本地 Dify 应用

- 在主界面选择“Dify”。

- 选择“本地”调用方式。

- 输入应用路径和参数。

- 点击“调用”按钮,等待应用加载。

- 查看应用输出结果。

调用在线 Dify 应用

- 在主界面选择“Dify”。

- 选择“在线”调用方式。

- 输入在线应用的 URL 和参数。

- 点击“调用”按钮,等待应用加载。

- 查看应用输出结果。