综合介绍

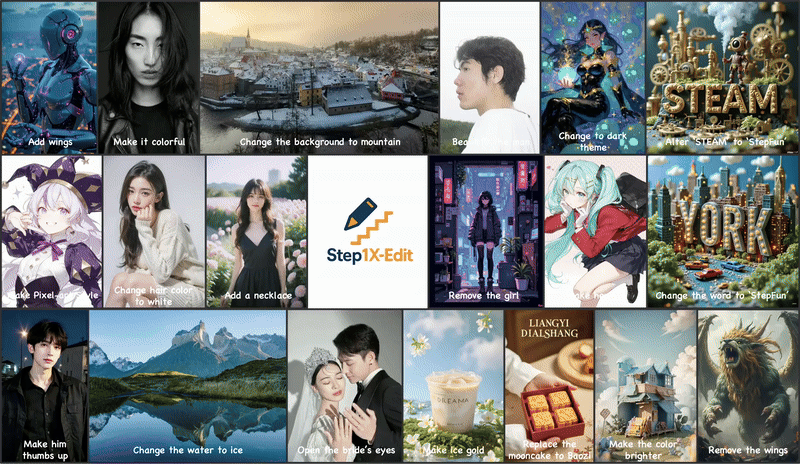

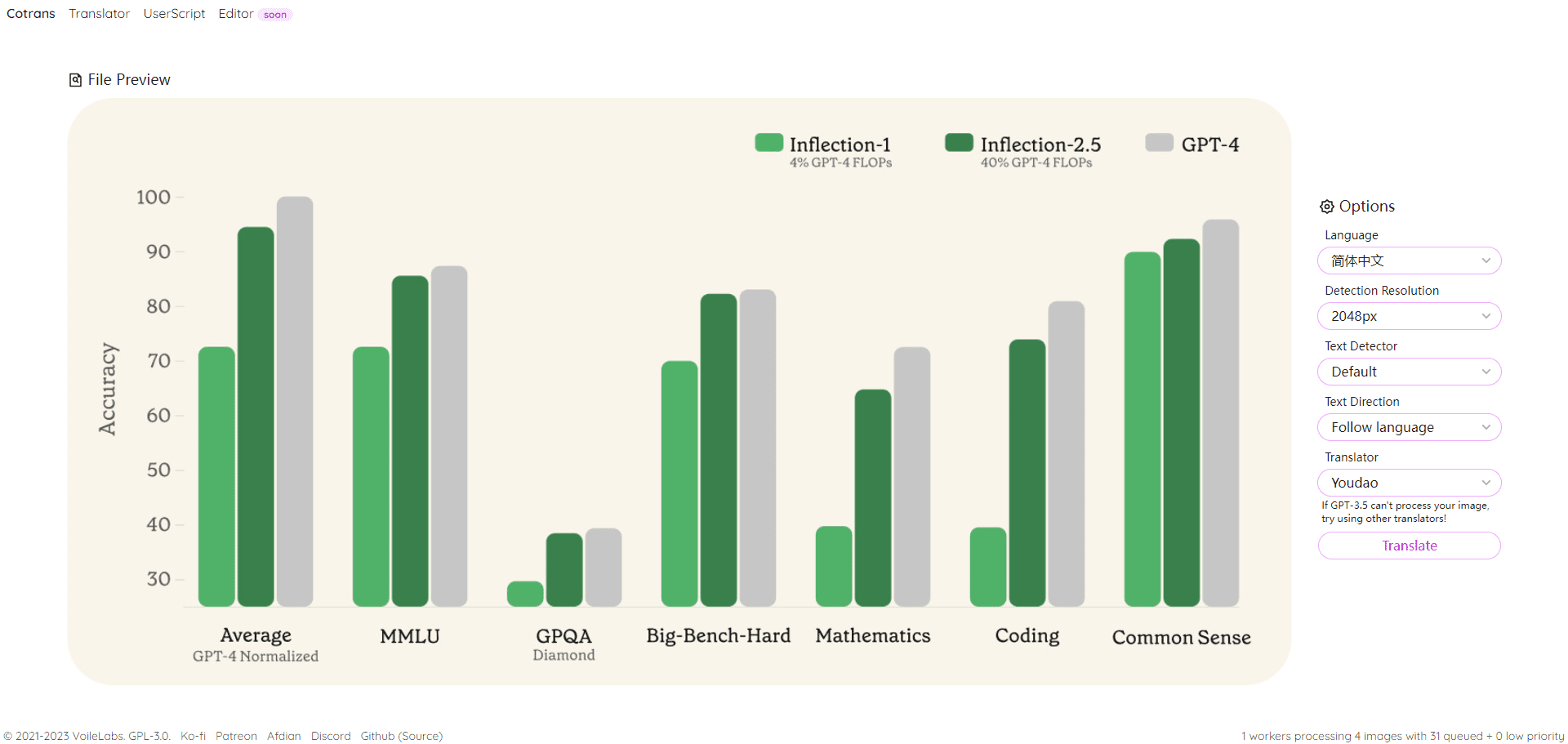

Step1X-Edit 是一个开源图像编辑框架,由 Stepfun AI 团队开发,托管于 GitHub。它结合多模态大语言模型(Qwen-VL)和扩散变换器(DiT),让用户通过简单的自然语言指令编辑图像,例如更改背景、移除物体或转换风格。项目于 2025 年 4 月 25 日发布,性能接近闭源模型如 GPT-4o 和 Gemini 2 Flash。Step1X-Edit 提供模型权重、推理代码和 GEdit-Bench 基准测试,支持广泛的编辑场景。Apache 2.0 许可证允许免费使用和商业开发,吸引了开发者、设计师和研究人员。社区支持活跃,已推出 ComfyUI 插件和 FP8 量化版本,优化硬件需求。

目前可在 阶跃AI 免费体验。但实际图像编辑效果与 GPT-4o 、 Gemini 2 Flash 差距略大。

功能列表

- 支持自然语言指令编辑图像,如“将背景改为海滩”或“移除照片中的人”。

- 使用多模态大语言模型(Qwen-VL)解析图像和文本指令,生成精确编辑。

- 基于扩散变换器(DiT)生成高质量图像,保持原始图像细节。

- 提供 GEdit-Bench 基准测试,评估真实用户指令下的编辑性能。

- 支持 FP8 量化模型,降低硬件需求,适配低内存 GPU。

- 集成 ComfyUI 插件,简化工作流,提升用户体验。

- 提供在线演示,允许用户无需安装即可体验编辑功能。

- 开源模型权重和推理代码,支持二次开发和研究。

使用帮助

安装流程

要使用 Step1X-Edit,需要安装环境并下载模型权重。以下是详细步骤,适合 Linux 系统(推荐 Ubuntu 20.04 或更高版本):

- 准备环境

确保系统安装 Python 3.10 或更高版本,以及 CUDA 工具包(推荐 12.1)。建议使用 GPU(80GB 显存最佳,如 NVIDIA H800),但 FP8 量化版本支持较低显存(16GB 或 24GB)。conda create -n step1x python=3.10 conda activate step1x

- 克隆仓库

从 GitHub 下载 Step1X-Edit 项目代码:git clone https://github.com/stepfun-ai/Step1X-Edit.git cd Step1X-Edit - 安装依赖

安装 PyTorch(推荐 2.3.1 或 2.5.1)和相关库:pip install torch==2.3.1 torchvision --index-url https://download.pytorch.org/whl/cu121 pip install -r requirements.txt安装 Flash Attention(可选,加速推理):

pip install flash-attn --no-build-isolation如果遇到 Flash Attention 安装问题,可参考官方脚本生成适合系统的预编译轮文件:

python scripts/find_flash_attn_wheel.py - 下载模型权重

从 Hugging Face 或 ModelScope 下载模型权重和变分自编码器(VAE):- Step1X-Edit 模型:

step1x-edit-i1258.safetensors(约 24.9GB) - VAE:

vae.safetensors(约 335MB) - Qwen-VL 模型:

Qwen/Qwen2.5-VL-7B-Instruct

使用 Python 脚本自动下载:

from huggingface_hub import snapshot_download import os target_dir = "models/step1x" os.makedirs(target_dir, exist_ok=True) # 下载 Step1X-Edit 模型 snapshot_download(repo_id="stepfun-ai/Step1X-Edit", local_dir=target_dir, allow_patterns=["step1x-edit-i1258.safetensors"]) # 下载 VAE snapshot_download(repo_id="stepfun-ai/Step1X-Edit", local_dir=target_dir, allow_patterns=["vae.safetensors"]) # 下载 Qwen-VL qwen_dir = os.path.join(target_dir, "Qwen2.5-VL-7B-Instruct") snapshot_download(repo_id="Qwen/Qwen2.5-VL-7B-Instruct", local_dir=qwen_dir) - Step1X-Edit 模型:

- 运行推理

使用提供的推理脚本编辑图像。例如,编辑一张图片并更改背景:python scripts/run_inference.py --image_path assets/demo.png --prompt "将背景改为夜空" --output_path output.png参数说明:

--image_path:输入图像路径。--prompt:编辑指令(如“将天空改为日落”)。--output_path:输出图像路径。--size_level:分辨率(默认 512x512,1024x1024 需要更多显存)。--seed:随机种子,控制生成一致性。

使用 ComfyUI 插件

Step1X-Edit 提供 ComfyUI 插件,适合希望集成到工作流的用户。

- 克隆 ComfyUI 插件仓库:

cd path/to/ComfyUI/custom_nodes git clone https://github.com/quank123wip/ComfyUI-Step1X-Edit.git - 将模型权重放置到

ComfyUI/models/Step1x-Edit目录:step1x-edit-i1258.safetensorsvae.safetensors- Qwen-VL 模型文件夹:

Qwen2.5-VL-7B-Instruct

- 启动 ComfyUI,加载 Step1X-Edit 节点。

- 在 ComfyUI 界面,上传图像,输入编辑指令(如“添加翅膀”),运行工作流生成结果。

主要功能操作

- 自然语言编辑

用户上传图像并输入文本指令。例如,要将照片背景改为山景,输入“将背景改为山景”。模型通过 Qwen-VL 解析指令,提取语义,结合 DiT 生成新图像。建议指令清晰具体,如“将天空改为蓝色星空”比“美化天空”效果更好。 - 对象移除或添加

指令如“移除照片中的人”或“添加一棵树”。模型会保留图像其他部分,精准编辑指定区域。复杂场景下,多次调整指令可优化结果。 - 风格转换

支持风格化编辑,如“将图像转为像素艺术风格”或“改成宫崎骏风格”。模型通过扩散过程生成符合风格的图像。 - 在线演示

访问 Hugging Face 空间(https://huggingface.co/spaces/stepfun-ai/Step1X-Edit),上传图像,输入指令,直接体验。每次生成受 GPU 时间限制,免费用户有两次尝试机会。

注意事项

- 硬件需求:512x512 分辨率需要约 42GB 显存,5 秒完成;1024x1024 需要 50GB 显存,约 22 秒。FP8 量化版本可降低至 16GB 显存,适合 3090 Ti 等 GPU。

- 指令优化:复杂编辑需详细指令,如“将背景改为雪山,保持前景人物不变”。

- 社区支持:GitHub 仓库有活跃社区,遇到问题可查看 Issues 或 Discussions。

应用场景

- 内容创作

设计师使用 Step1X-Edit 为广告素材快速更换背景或调整风格。例如,将产品照片背景改为节日主题,提升视觉吸引力。 - 个人照片编辑

普通用户通过在线演示美化照片,如移除背景杂物或将白天照片改为夜景,操作简单无需专业技能。 - 电商产品优化

电商平台用 Step1X-Edit 生成产品在不同场景的展示图,如将衣服置于海滩或城市背景,节省拍摄成本。 - 学术研究

研究人员使用 GEdit-Bench 数据集和模型权重,开发新的图像编辑算法或比较模型性能。

QA

- Step1X-Edit 支持哪些分辨率?

支持 512x512 和 1024x1024 分辨率。512x512 速度快,显存需求低;1024x1024 细节更丰富,需更高显存。 - 如何优化编辑结果?

使用具体指令,避免模糊描述。多次尝试不同措辞可提高效果。如“将天空改为红色日落”比“改变天空”更明确。 - 是否支持中文指令?

是的,模型支持中文指令,效果与英文相当。建议用简洁语言描述需求。 - FP8 量化版本有何不同?

FP8 版本降低显存需求(16GB 可运行),但可能略牺牲细节。适合硬件资源有限的用户。 - 是否需要联网运行?

本地运行无需联网。在线演示需要访问 Hugging Face 空间。