综合介绍

Describe Anything 是由 NVIDIA 和多所大学联合开发的开源项目,核心是 Describe Anything Model(DAM)。这个工具能根据用户在图像或视频中标记的区域(如点、框、涂鸦或掩码),生成详细的描述。它不仅能描述静态图像的细节,还能捕捉视频中区域随时间的变化。

功能列表

- 支持多种区域标注方式:用户可通过点、框、涂鸦或掩码指定图像或视频的描述区域。

- 图像和视频描述:为静态图像生成详细描述,或分析视频中特定区域的动态变化。

- 开源模型与数据集:提供 DAM-3B 和 DAM-3B-Video 模型,支持图像和视频联合处理。

- 交互式界面:通过 Gradio 提供网页界面,允许用户绘制掩码并实时获取描述。

- API 支持:提供 OpenAI 兼容的服务器接口,方便集成到其他应用。

- DLC-Bench 评估:包含专门的基准测试工具,用于评估区域描述的模型性能。

- SAM 集成:可选集成 Segment Anything(SAM)模型,自动生成掩码,提升操作效率。

使用帮助

安装流程

Describe Anything 支持通过 Python 环境安装,推荐使用虚拟环境以避免依赖冲突。以下是详细安装步骤:

- 创建 Python 环境:

使用 Python 3.8 或更高版本,创建一个新的虚拟环境:python -m venv dam_env source dam_env/bin/activate # Linux/Mac dam_env\Scripts\activate # Windows

- 安装 Describe Anything:

有两种安装方式:- 直接通过 pip 安装:

pip install git+https://github.com/NVlabs/describe-anything - 克隆仓库并本地安装:

git clone https://github.com/NVlabs/describe-anything cd describe-anything pip install -v .

- 直接通过 pip 安装:

- 安装 Segment Anything(可选):

如果需要自动生成掩码,需安装 SAM 依赖:cd demo pip install -r requirements.txt - 验证安装:

安装完成后,运行以下命令检查是否成功:python -c "from dam import DescribeAnythingModel; print('Installation successful')"

使用方法

Describe Anything 提供多种使用方式,包括命令行脚本、交互式界面和 API 调用。以下是主要功能的详细操作流程:

1. 交互式 Gradio 界面

Gradio 界面适合初学者,允许用户上传图像并手动绘制掩码以获取描述。

- 启动界面:

运行以下命令启动 Gradio 服务器:python demo_simple.py命令执行后,浏览器会打开一个本地网页(通常是

http://localhost:7860)。 - 操作步骤:

- 上传图像:点击上传按钮,选择本地图像文件。

- 绘制掩码:使用画笔工具在图像上圈选感兴趣的区域。

- 获取描述:点击提交,系统会生成该区域的详细描述,例如“一只红色毛发的狗,戴着银色标签的项圈,正在跑动”。

- 可选 SAM 集成:启用 SAM 后,点击图像上的点,系统会自动生成掩码。

- 注意事项:

- 确保图像为 RGBA 格式,掩码通过 alpha 通道处理。

- 描述的详细程度可通过调整参数(如

max_new_tokens)控制。

2. 命令行脚本

命令行脚本适合批量处理或开发者使用,提供更高的灵活性。

- 图像描述:

运行以下命令为图像生成描述:python examples/dam_with_sam.py --image_path <image_file> --input_points "[[x1,y1],[x2,y2]]"例如:

python examples/dam_with_sam.py --image_path dog.jpg --input_points "[[500,300]]"系统会根据指定点生成掩码并输出描述。

- 视频描述:

使用联合模型处理视频:python examples/query_dam_server_video.py --model describe_anything_model --server_url http://localhost:8000 --video_path <video_file>仅需在一帧上指定区域,系统会自动跟踪并描述区域变化。

- 参数调整:

--temperature:控制描述的创造性,建议值为 0.2。--top_p:控制生成多样性,建议值为 0.9。--max_new_tokens:设置描述的最大长度,默认为 512。

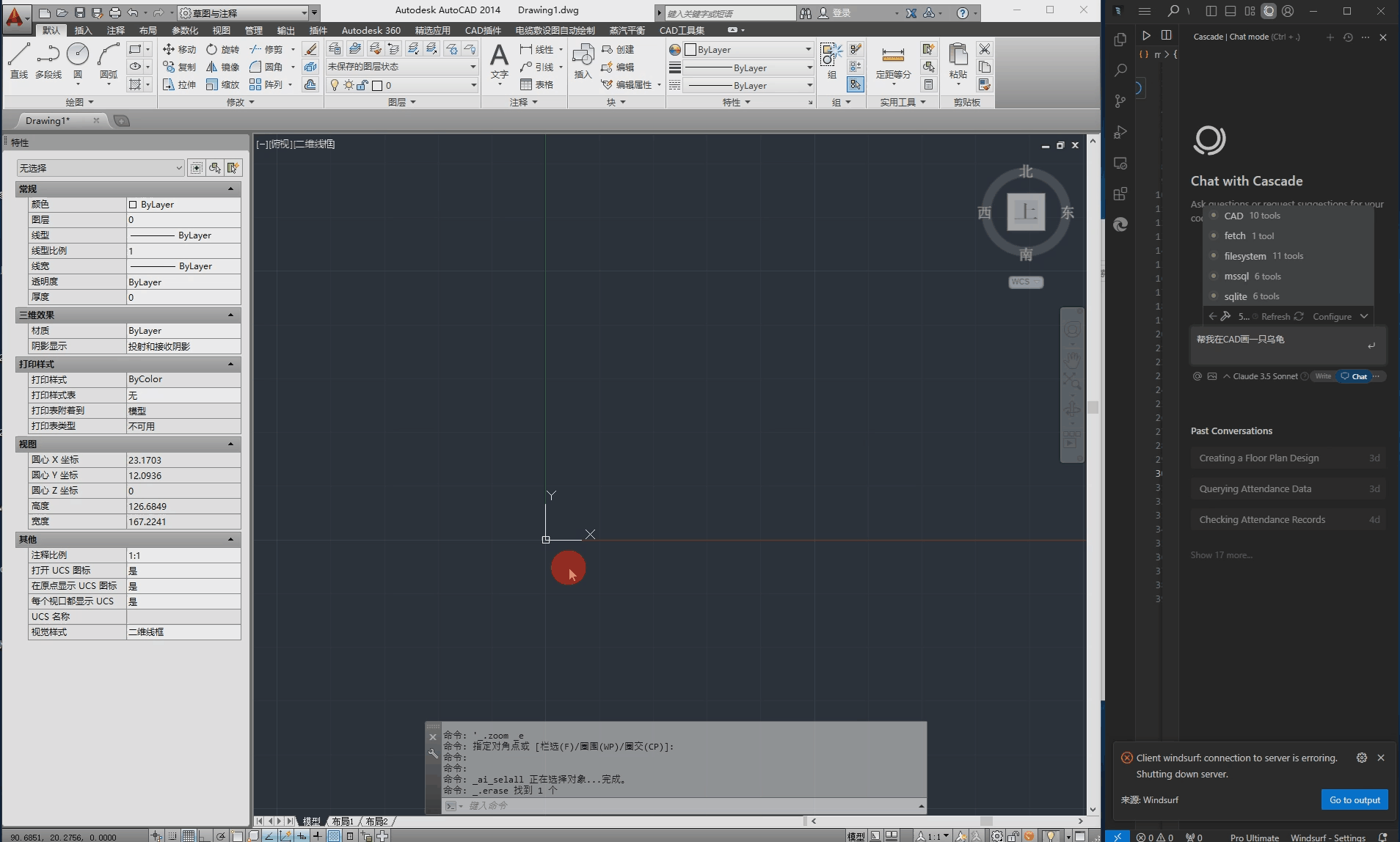

3. API 调用

Describe Anything 提供 OpenAI 兼容的 API,适合集成到其他应用。

- 启动服务器:

运行以下命令启动 DAM 服务器:python dam_server.py --model-path nvidia/DAM-3B --conv-mode v1 --prompt-mode focal_prompt服务器默认运行在

http://localhost:8000。 - 发送请求:

使用 Python 和 OpenAI SDK 发送请求:from openai import OpenAI client = OpenAI(base_url="http://localhost:8000", api_key="not-needed") response = client.chat.completions.create( model="describe_anything_model", messages=[ {"role": "user", "content": [ {"type": "image_url", "image_url": {"url": "data:image/png;base64,<base64_image>"}}, {"type": "text", "text": "Describe the region in the mask"} ]} ] ) print(response.choices[0].message.content)替换

<base64_image>为图像的 Base64 编码。

4. DLC-Bench 评估

DLC-Bench 是用于评估区域描述模型的基准工具。

- 下载数据集:

git lfs install git clone https://huggingface.co/datasets/nvidia/DLC-Bench - 运行评估:

使用以下命令生成模型输出并评估:python get_model_outputs.py --model_type dam --model_path nvidia/DAM-3B结果会缓存到

model_outputs_cache/文件夹。

特色功能操作

- Focal Prompting:DAM 使用 Focal Prompting 技术,结合全局图像上下文和局部区域细节,生成更精准的描述。用户无需手动调整提示,系统会自动优化。

- Gated Cross-Attention:通过门控交叉注意力机制,模型能在复杂场景中聚焦于指定区域,避免无关信息的干扰。

- 视频动态描述:只需在一帧上标注区域,DAM 会自动跟踪并描述该区域在视频中的变化,例如“牛的腿部肌肉随着步伐有力移动”。

应用场景

- 医学影像分析

医生可使用 Describe Anything 标注医学影像(如 CT 或 MRI)中的特定区域,生成详细描述,帮助诊断。例如,标注肺部异常区域,系统可描述“一块不规则的阴影区域,边缘模糊,可能为炎症”。 - 城市规划

规划师可上传航拍视频,标注建筑或道路区域,获取描述如“一条宽阔的四车道公路,周围有密集的商业建筑”。这有助于分析城市布局。 - 内容创作

视频创作者可通过 Describe Anything 为视频片段的特定对象生成描述,如“一只飞翔的鹰,翅膀展开,背景是雪山”。这些描述可用于字幕或脚本创作。 - 数据标注

数据科学家可利用 DAM 自动为图像或视频中的对象生成描述,减少人工标注的工作量。例如,标注数据集中的车辆,生成“红色轿车,前灯开启”。

QA

- Describe Anything 支持哪些输入格式?

支持 PNG、JPEG 等常见图像格式,以及 MP4 等视频格式。图像需为 RGBA 模式,掩码通过 alpha 通道指定。 - 如何提高描述的准确性?

使用更精确的掩码(如通过 SAM 自动生成),并调整temperature和top_p参数以控制描述的创造性和多样性。 - 是否需要 GPU 运行?

推荐使用 NVIDIA GPU(如 RTX 3090)以加速推理,但 CPU 也可运行,速度较慢。 - 如何处理视频中的多帧描述?

只需在一帧上标注区域,DAM 会自动跟踪并描述该区域在后续帧中的变化。