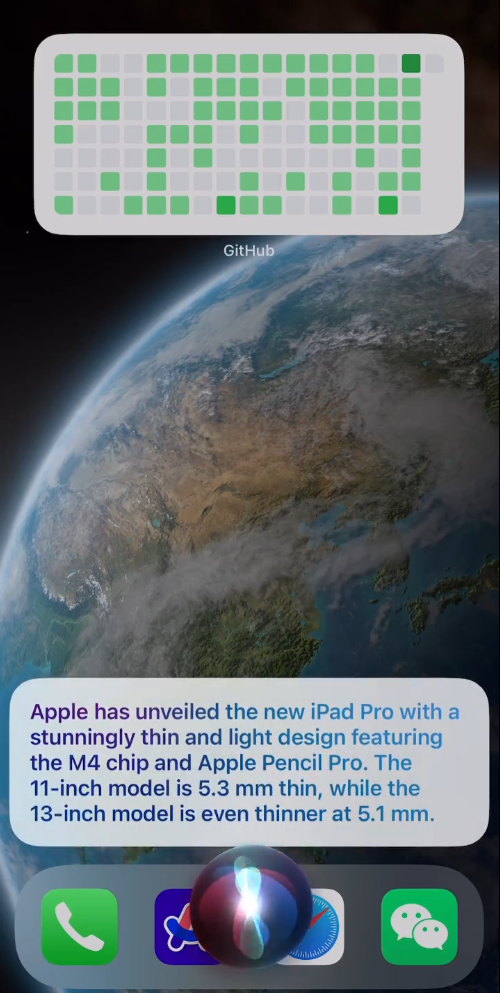

O TokenDagger é uma ferramenta de segmentação de texto de alto desempenho projetada para acelerar as tarefas de processamento de linguagem natural (NLP). É uma alternativa ao TikToken da OpenAI que otimiza a velocidade da divisão de palavras e apresenta um desempenho particularmente bom ao trabalhar com código e texto em grande escala. De código aberto no GitHub pelo desenvolvedor Matthew Wolfe, o projeto fornece uma interface compatível com o TikToken 100% que os desenvolvedores podem usar sem modificar o código existente. O TokenDagger usa o mecanismo PCRE2 para otimizar a correspondência de expressões regulares, simplificando o algoritmo de codificação de pares de bytes (BPE) e melhorando drasticamente o desempenho. Os testes mostraram que ele é 4 vezes mais rápido do que o TikToken em termos de velocidade de segmentação de código e 2 a 3 vezes mais rápido em termos de taxa de transferência ao processar arquivos de texto de 1 GB. O projeto é adequado para desenvolvedores, cientistas de dados e pesquisadores de IA que precisam de processamento de texto eficiente.

Lista de funções

- Segmentação eficiente: com base no mecanismo PCRE2, otimiza a correspondência de expressões regulares e melhora significativamente a velocidade da segmentação de texto.

- Compatível com o TikToken: como substituto direto do TikToken, ele pode ser integrado sem modificar o código existente.

- Algoritmo BPE simplificado: codificação otimizada de pares de bytes, redução de custos especiais token Sobrecarga de desempenho do processamento.

- Suporte de código aberto: o código-fonte completo está disponível, permitindo que os desenvolvedores personalizem ou contribuam com melhorias.

- Suporte multiplataforma: suporte para Linux, macOS e outros sistemas, fácil de implementar em uma variedade de ambientes de desenvolvimento.

- Conjunto de testes: ferramenta de benchmarking integrada para validar o desempenho do particípio e comparar com o TikToken.

Usando a Ajuda

Processo de instalação

O TokenDagger é fácil de instalar para desenvolvedores familiarizados com Python e Git. Aqui estão as etapas detalhadas de instalação, com base nos sistemas Ubuntu/Debian (outros sistemas precisarão ajustar os comandos de instalação de dependência de acordo):

- Repositório de código clone

Use o comando Git para clonar o repositório do TokenDagger localmente:git clone git@github.com:M4THYOU/TokenDagger.git

Isso fará o download do código-fonte mais recente do TokenDagger.

- Instalação da biblioteca de desenvolvimento PCRE2

O TokenDagger usa o PCRE2 para correspondência eficiente de expressões regulares e requer a instalação da biblioteca de desenvolvimento:sudo apt install libpcre2-dev - Atualização de submódulos

O projeto depende de vários componentes externos que precisam ser inicializados e os submódulos atualizados:git submodule update --init --recursive - Instalação do ambiente de desenvolvimento Python

Certifique-se de que seu sistema tenha um ambiente de desenvolvimento Python3:sudo apt update && sudo apt install -y python3-dev - Instalar o TikToken (opcional)

Se precisar executar um conjunto de testes para comparar o desempenho com o TikToken, você precisará instalar o TikToken:pip3 install tiktoken - Compilar e executar

Vá para o diretório do projeto e execute o script Python ou o conjunto de testes:cd TokenDagger python3 setup.py installDepois de instalado, o TokenDagger pode ser importado e usado via Python.

Uso

A função principal do TokenDagger é a divisão eficiente de palavras, adequada para o processamento de códigos, documentos ou textos em grande escala. Veja a seguir o fluxo de operação da função principal:

1. integração em projetos existentes

O TokenDagger é totalmente compatível com a API do TikToken. Os desenvolvedores podem simplesmente substituir a declaração de importação do TikToken pelo TokenDagger, por exemplo:

# 原代码

from tiktoken import encoding_for_model

# 替换为

from tokendagger import encoding_for_model

Sem nenhuma alteração posterior no código, o TokenDagger assume a tarefa de segmentação de palavras, proporcionando um processamento mais rápido.

2. operações de segmentação

O TokenDagger suporta as operações padrão de divisão de palavras. Veja abaixo um exemplo simples:

from tokendagger import encoding_for_model

encoder = encoding_for_model("gpt-3.5-turbo")

text = "Hello, this is a sample text for tokenization."

tokens = encoder.encode(text)

print(tokens)

Esse código converte o texto de entrada em uma lista de tokens, o que é mais rápido do que o TikToken, especialmente ao lidar com textos ou códigos longos.

3. manuseio da divisão de código

O TokenDagger é particularmente bom em desambiguação de código. Suponha que você precise processar o código Python:

code = """

def hello_world():

print("Hello, World!")

"""

tokens = encoder.encode(code)

print(len(tokens)) # 输出 token 数量

Os testes mostraram que o TokenDagger processa códigos semelhantes quatro vezes mais rápido que o TikToken, o que o torna adequado para cenários que exigem análise rápida de códigos.

4. executar testes de benchmark

O TokenDagger oferece um conjunto de testes integrado no qual os desenvolvedores podem verificar o desempenho:

python3 -m tokendagger.benchmark

Os resultados do teste mostrarão a velocidade do TokenDagger em comparação com o TikToken em diferentes conjuntos de dados, como arquivos de texto de 1 GB ou amostras de código.

5. desenvolvimento personalizado

Os desenvolvedores podem modificar o código-fonte do TokenDagger para atender a necessidades específicas. O catálogo de projetos é bem estruturado, e a lógica central de tokenização está localizada no diretório tokendagger/core em. Os desenvolvedores podem adaptar as expressões regulares PCRE2 ou os algoritmos BPE para otimizar casos de uso específicos.

advertência

- Requisitos ambientaisVerifique se o Python 3.6+ e a biblioteca PCRE2 estão instalados em seu sistema.

- Ambiente de teste de desempenhobenchmarks oficiais foram realizados em um processador AMD EPYC 4584PX; o desempenho real pode variar de acordo com o hardware.

- Suporte à comunidadeSe tiver problemas, registre um problema no GitHub ou consulte a documentação.

cenário do aplicativo

- Desenvolvimento de modelos de IA

O TokenDagger é adequado para a fase de pré-processamento de modelos de linguagem em grande escala (LLMs), convertendo rapidamente o texto em tokens para melhorar a eficiência do treinamento. Por exemplo, os desenvolvedores de IA podem usá-lo para processar conjuntos de dados em grande escala e reduzir o tempo de pré-processamento de dados. - Ferramentas de análise de código

Em ferramentas de revisão de código ou de análise estática, o TokenDagger analisa rapidamente o código-fonte e gera sequências de tokens para criar recursos de destaque de sintaxe, autocompletar código ou detecção de erros. - Processamento de texto de Big Data

Os cientistas de dados podem usar o TokenDagger para processar grandes quantidades de texto, como arquivos de registro ou dados de mídia social. Sua alta taxa de transferência reduz significativamente o tempo de processamento. - Educação e pesquisa

Estudantes e pesquisadores podem usar o TokenDagger para aprender algoritmos lexicais ou fazer experiências com NLP, e o projeto é de código aberto e bem documentado para exploração acadêmica.

QA

- Qual é a diferença entre o TokenDagger e o TikToken?

O TokenDagger é uma alternativa de alto desempenho ao TikToken, usando o mecanismo PCRE2 e algoritmos BPE otimizados, que é muito mais rápido, especialmente na segmentação de código por um fator de 4 e na taxa de transferência de processamento de texto por um fator de 2-3. - Preciso alterar meu código para usar o TokenDagger?

Não. O TokenDagger é totalmente compatível com a API do TikToken, portanto, você pode fazer a troca sem problemas, simplesmente substituindo a instrução de importação. - Quais linguagens de programação são compatíveis com o TokenDagger?

Ele foi projetado principalmente para desenvolvedores Python, mas a função participle pode lidar com qualquer texto, inclusive códigos em várias linguagens de programação. - Como posso verificar o desempenho do TokenDagger?

Executar os benchmarks incorporadospython3 -m tokendagger.benchmarkAlém disso, você pode comparar a velocidade do TokenDagger e do TikToken.