A MediaTek Research anunciou recentemente que abriu oficialmente o código-fonte de dois modelos multimodais otimizados para o chinês tradicional: o Llama-Breeze2-3B e o Llama-Breeze2-8B, projetados para diferentes plataformas de computação, como telefones celulares e PCs, e com a capacidade de chamar funções, o que permite o uso flexível de ferramentas externas para expandir os cenários de aplicativos. para expandir os cenários de aplicativos. Além disso, a MediaTek também abriu o código de um aplicativo Android baseado no Llama-Breeze2-3B e no BreezyVoice, um modelo de síntese de fala que pode gerar um sotaque taiwanês natural, demonstrando seu layout abrangente da tecnologia de IA de terminal.

A série Llama-Breeze2 de modelos multimodais para telefones celulares e PCs.

Base de inovação da MediaTek, esse código aberto Modelos de base multimodal chinês tradicional da série Llama-Breeze2O Llama-Breeze2-3B é uma versão leve do Llama-Breeze2 que pode ser executada em dispositivos móveis, e uma versão leve do Llama-Breeze2-8B que oferece um desempenho mais poderoso em PCs. De acordo com a MediaTek, essa série de modelos não é apenas proficiente em chinês tradicional, mas também integra recursos avançados, como multimodalidade e chamadas de função, o que permite compreender informações de imagem e chamar ferramentas externas para realizar tarefas complexas.

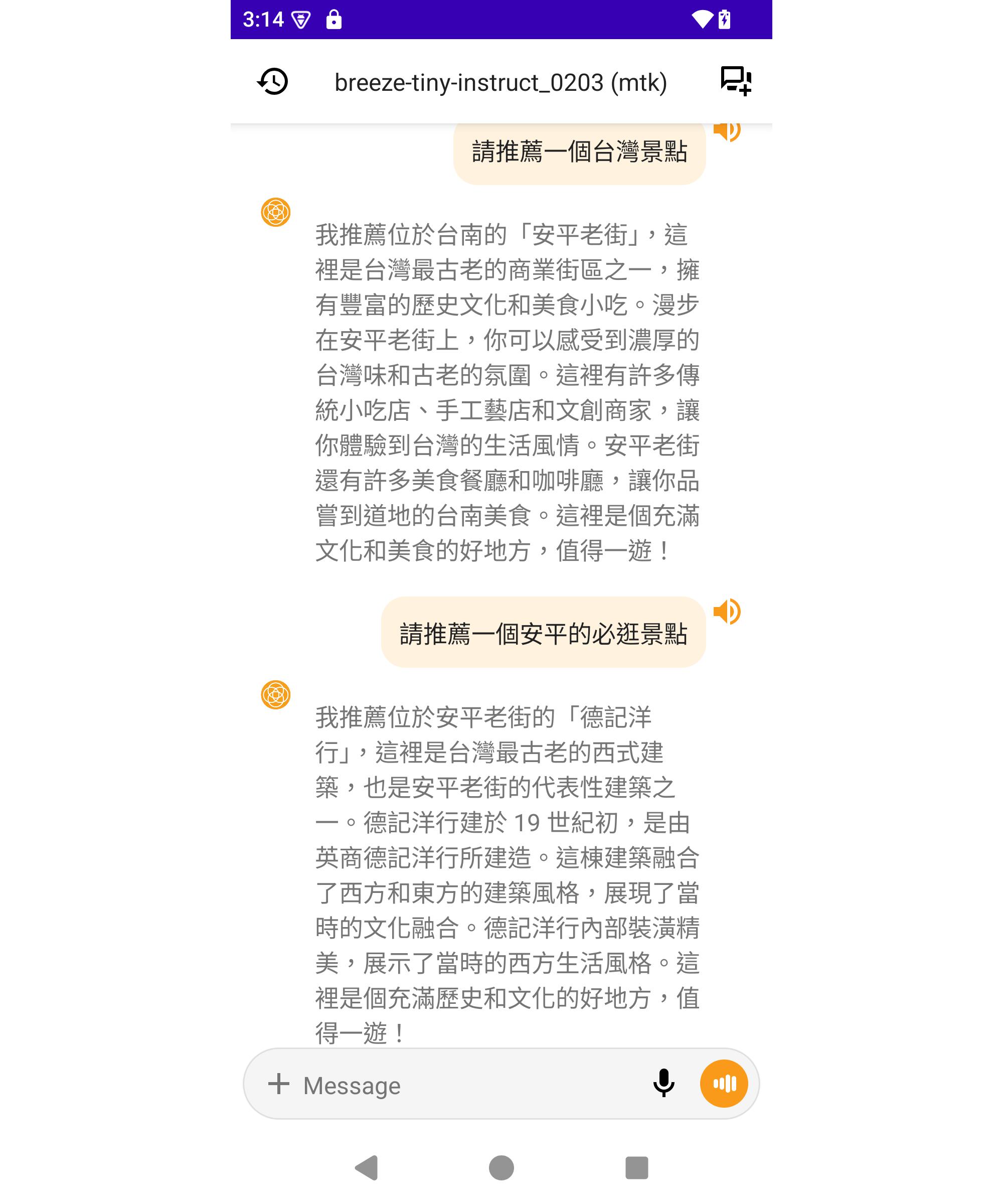

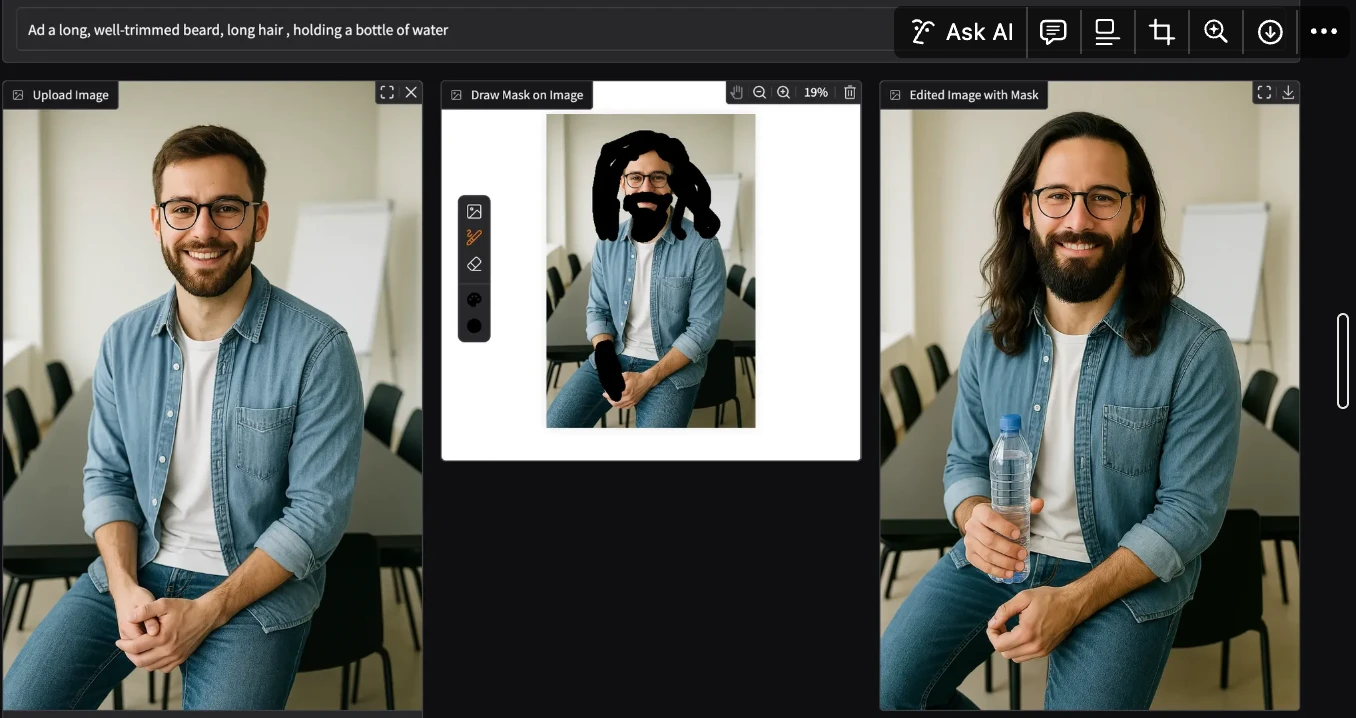

Para promover ainda mais o desenvolvimento de aplicativos móveis de IA, a MediaTek adotou o modelo Llama-Breeze2-3B como núcleo.Desenvolveu e abriu o código-fonte de um aplicativo para AndroidEste aplicativo foi projetado para aprimorar os recursos do assistente de IA do celular, como reconhecimento de conteúdo de imagem e invocação de ferramenta externa. O aplicativo foi projetado para aprimorar os recursos do assistente de IA do telefone, como reconhecimento de conteúdo de imagem, chamadas de ferramentas externas e muito mais. Enquanto isso, a MediaTek também está sincronizando desengajamento BreezyVoice, um modelo de síntese de fala capaz de sintetizar sotaques taiwaneses autênticos. O conteúdo de código aberto dos três modelos e aplicativos acima inclui pesos de modelos e parte do código de execução para que os desenvolvedores possam estudar e aplicar.

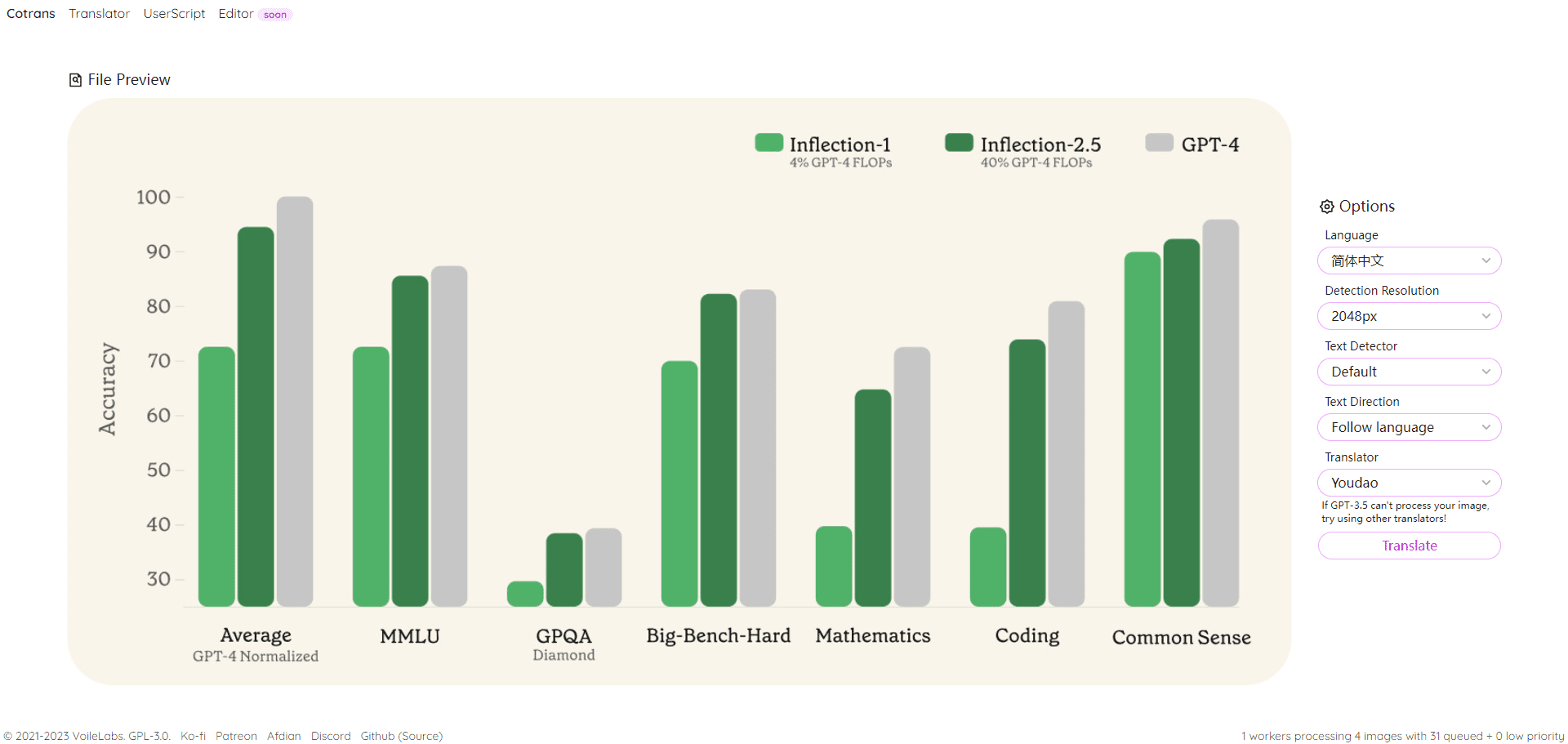

Análise da tecnologia do modelo Llama-Breeze2: otimização baseada no Llama 3, combinando complexidade, visão e recursos de invocação de ferramentas

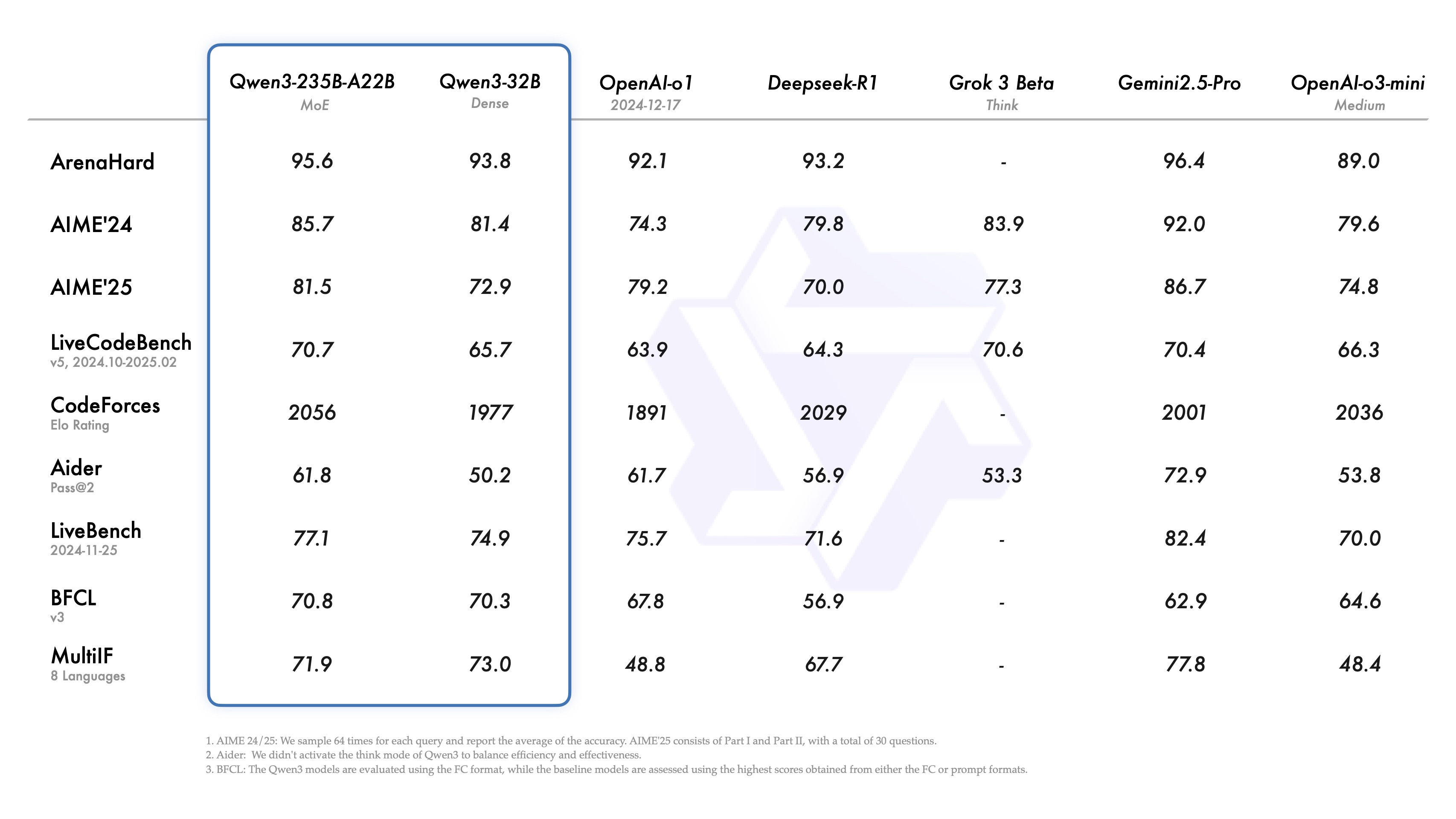

Uma análise aprofundada do modelo Llama-Breeze2, cuja tecnologia principal é otimizada com base no modelo de linguagem Llama 3 de código aberto da Meta. A MediaTek aproveita ainda mais o corpus de chinês tradicional para aprimorar a compreensão do modelo de chinês tradicional e integra o modelo de linguagem visual, bem como as chamadas de função (Chamada de função), dando à série de modelos Llama-Breeze2 três recursos principais: otimização do chinês tradicional, compreensão de imagens e capacidade de chamar ferramentas externas.

existirCapacidade do chinês tradicionalQuanto aos resultados de comparação fornecidos pela MediaTek, em comparação com o modelo Llama 3 3B Instruct com a mesma escala de parâmetros, o Llama-Breeze2-3B conseguiu listar com precisão mercados noturnos conhecidos, como o Shihlin Night Market, o Raohe Night Market e o Luodong Night Market, no texto curto gerado dos mercados noturnos de Taiwan; enquanto o modelo Llama 3 3B Instruct reconheceu corretamente apenas o Shihlin Night Market. mas gera dois mercados noturnos fictícios - Telecom Night Market e World Trade Night Market. Esse resultado destaca a vantagem da família de modelos Llama-Breeze2 na compreensão do chinês tradicional.

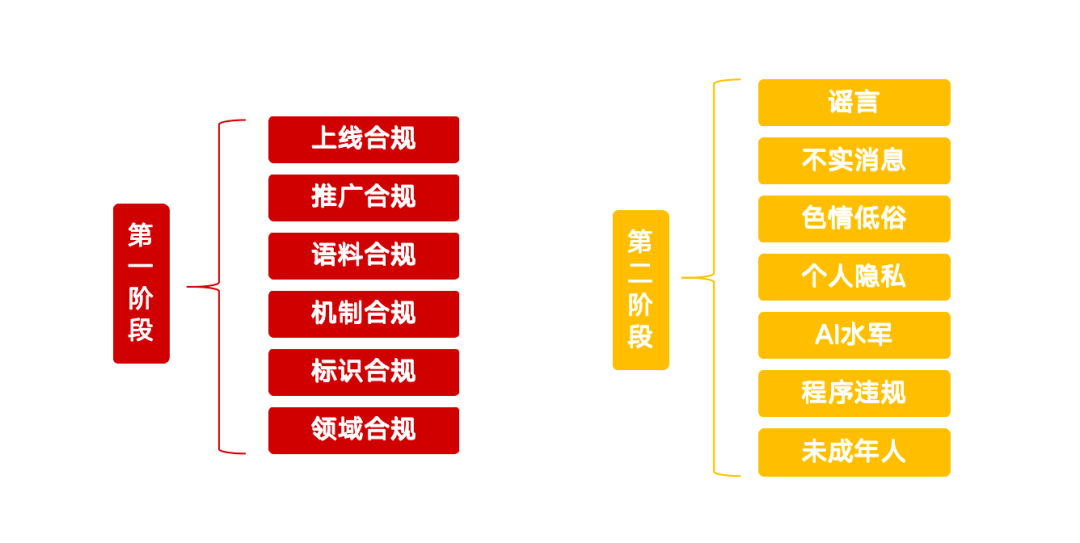

existircapacidade multimodalO Llama-Breeze2-3B não apenas processa informações textuais, mas também analisa com eficácia o conteúdo de imagens, como diagramas, resultados de reconhecimento óptico de caracteres (OCR) ou fotografias de locais de interesse. Os modelos são capazes de entender o significado da imagem e fazer відповідь. Por exemplo, no cenário a seguir:

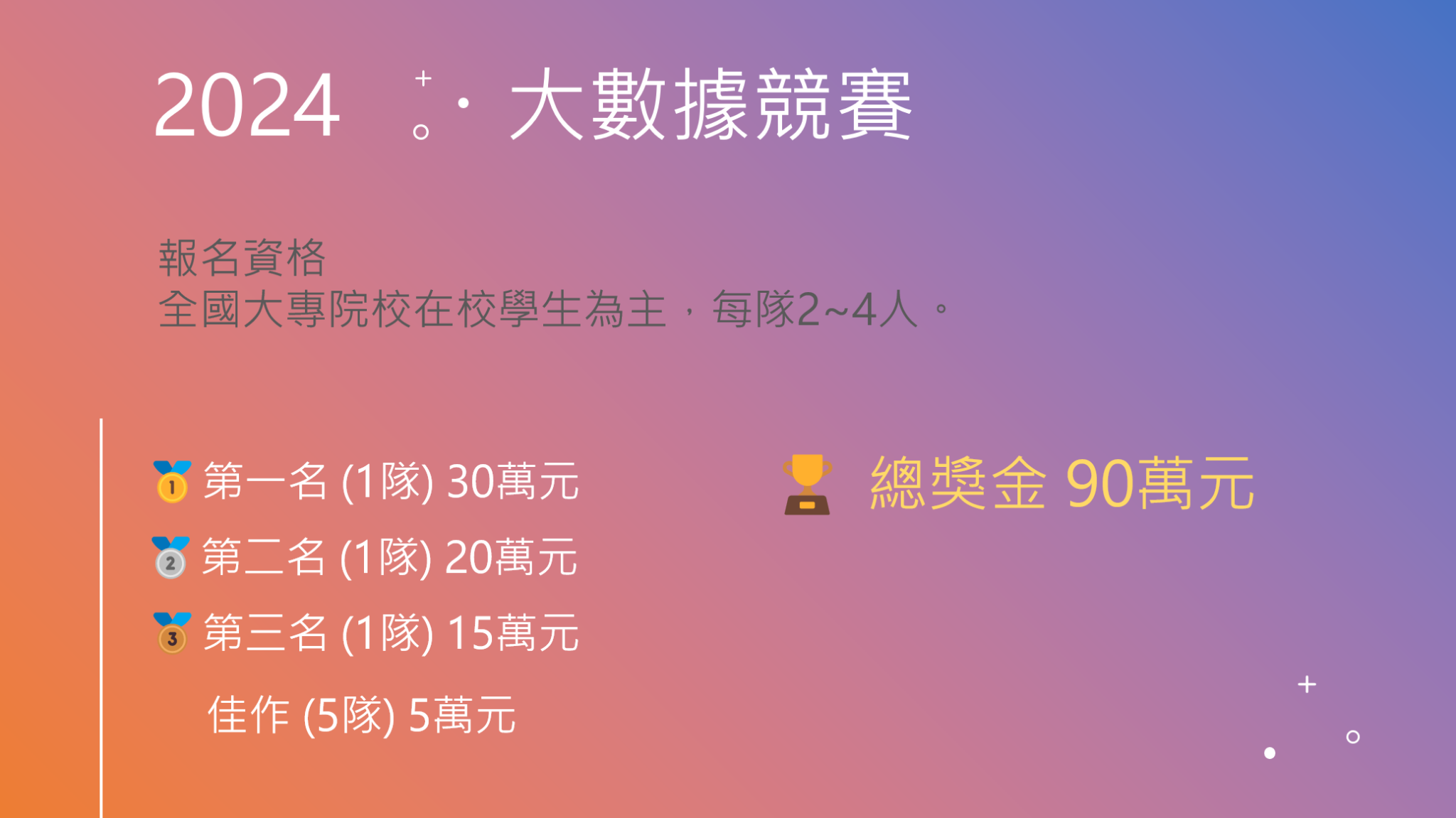

Pergunta do usuário: Qual é o valor total do prêmio em dinheiro disponível para os três primeiros colocados?

Llama-Breeze2-8B respondeu: De acordo com as informações na imagem, o prêmio para o primeiro lugar é de 300.000 RMB, o segundo lugar é de 200.000 RMB e o terceiro lugar é de 150.000 RMB. Quando esses valores são somados, o prêmio total em dinheiro para os três primeiros lugares é de 650.000 RMB.

Além disso, os modelos da série Llama-Breeze2 são equipados com chamadas de função, o que lhes permite chamar ferramentas externas para realizar tarefas mais complexas. Por exemplo, quando um usuário pergunta sobre o clima, o modelo pode chamar a interface API de um aplicativo meteorológico para obter instantaneamente as informações meteorológicas mais recentes e responder ao usuário com os resultados, proporcionando uma experiência mais inteligente e interativa.

Exemplo de aplicativo para Android: Llama-Breeze2-3B: conduzindo aplicativos móveis de IA

Além de abrir o código de dois modelos de linguagem multimodal, a MediaTek Innovation Base também abriu o código de um aplicativo Android que pode ser implantado diretamente em telefones celulares. Com base no modelo Llama-Breeze2-3B, esse aplicativo pode ser usado como um assistente pessoal de IA para ajudar os usuários com tradução em tempo real, recomendações de atrações e muitas outras tarefas, conforme mostrado na figura abaixo. Além disso, o aplicativo também é equipado com uma função de geração de fala, que permite aos usuários inserir texto e o modelo gerará uma resposta de voz natural e suave, que pode ser usada em vários cenários, como a navegação inteligente.

Modelo de síntese de fala BreezyVoice: cinco segundos de amostras de áudio para gerar sotaques taiwaneses autênticos

Como parte do programa de código aberto, a MediaTek Innovation Base também lançou o BreezyVoice, um modelo de síntese de voz especialmente treinado para a fala tradicional chinesa e projetado com uma arquitetura leve que pode gerar rapidamente uma fala altamente realista com apenas 5 segundos de amostra de entrada de áudio. O BreezyVoice pode ser usado como uma solução de saída de voz para assistentes de IA para proporcionar uma experiência mais natural e interativa. O BreezyVoice pode ser usado como uma solução de saída de voz para assistentes de IA para proporcionar uma experiência interativa mais natural. De acordo com a MediaTek, o BreezyVoice agora é executado sem problemas em laptops e pode ser combinado com qualquer sistema de modelagem de linguagem ampla (LLM) ou de fala para texto para oferecer ainda mais possibilidades de aplicação.