DeepSeek-TNG-R1T2-Chimera é um modelo de linguagem grande de código aberto desenvolvido pela TNG Technology Consulting GmbH e hospedado na plataforma Hugging Face. Lançado em 2 de julho de 2025, o modelo é uma versão atualizada do DeepSeek-R1T-Chimera, incorporando os três modelos principais R1, V3-0324 e R1-0528, com construção refinada por meio da metodologia Assembly of Experts (AoE). 20% em comparação com o R1 e mais de duas vezes mais rápido que o R1-0528, ao mesmo tempo em que demonstra maior inteligência em benchmarks como GPQA e AIME-24/25. Ele corrige os problemas de consistência de marcação do modelo anterior e é adequado para cenários que exigem raciocínio eficiente e respostas rápidas. O modelo está disponível sob a licença MIT, com pesos abertos, e é gratuito para uso dos desenvolvedores.

Lista de funções

- Geração eficiente de texto: gere rapidamente textos suaves e precisos para tarefas como diálogo e criação de conteúdo.

- Capacidade de raciocínio avançado: oferece suporte à análise de problemas complexos e ao raciocínio lógico para pesquisas acadêmicas e processamento de documentos técnicos.

- Suporte a vários idiomas: lida com entradas em vários idiomas, adequado para cenários de aplicativos internacionalizados.

- otimização token Eficiência: em comparação com o R1-0528, menos tokens são emitidos, reduzindo o custo de computação.

- Corrigir problemas de marcação: garantir a consistência no processo de inferência e melhorar a confiabilidade do modelo.

- Pesos de modelo de código aberto: com base nas licenças MIT, permitindo que os usuários façam download, modifiquem e implementem livremente.

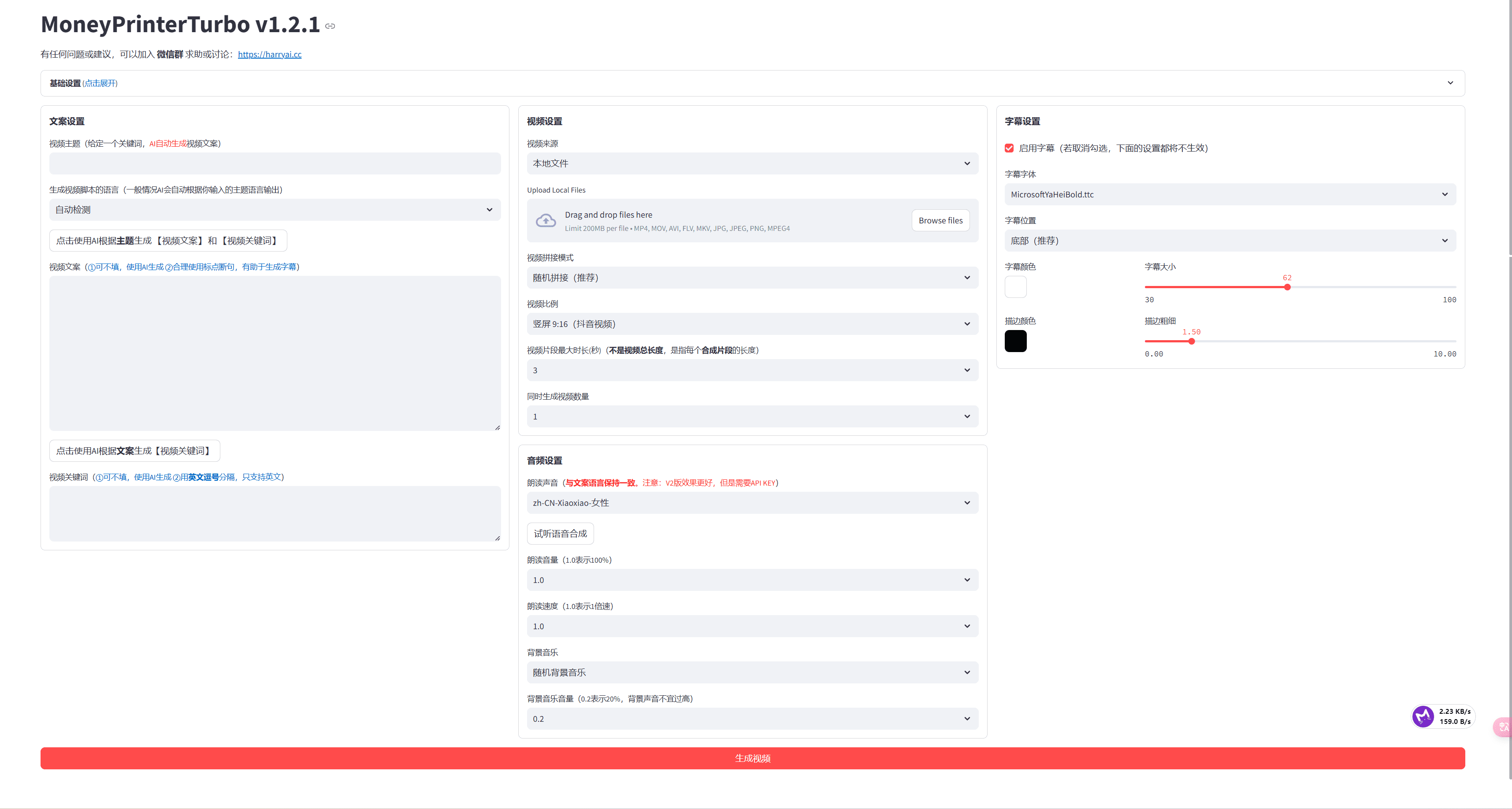

Usando a Ajuda

Processo de instalação

O DeepSeek-TNG-R1T2-Chimera é um modelo hospedado na Hugging Face e deve ser usado em conjunto com a biblioteca Transformers da Hugging Face por meio do ambiente Python. Abaixo estão as etapas detalhadas de instalação e uso:

1. ambiente de instalação

Certifique-se de que o Python 3.8 ou posterior esteja instalado localmente ou na nuvem e que o gerenciador de pacotes pip esteja configurado. Execute o seguinte comando para instalar as dependências necessárias:

pip install transformers torch

transformersé uma biblioteca fornecida pela Hugging Face para carregar e executar modelos.torché a estrutura do PyTorch que garante que a inferência do modelo funcione corretamente.

Se estiver usando a aceleração de GPU, será necessário instalar uma versão do PyTorch compatível com CUDA. Consulte o site do PyTorch para escolher a versão apropriada para sua configuração de hardware, por exemplo:

pip install torch --index-url https://download.pytorch.org/whl/cu118

2. download do modelo

Os pesos do modelo para DeepSeek-TNG-R1T2-Chimera podem ser baixados diretamente do Hugging Face. Use o seguinte código Python para carregar o modelo:

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "tngtech/DeepSeek-TNG-R1T2-Chimera"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name)

- Certifique-se de ter uma conexão estável com a Internet, pois os arquivos do modelo são grandes e podem levar algum tempo para serem baixados.

- Se o armazenamento local for limitado, use o recurso Hugging Face

cache_direspecifica o caminho do cache:

model = AutoModelForCausalLM.from_pretrained(model_name, cache_dir="/path/to/cache")

3. configuração do ambiente operacional

O modelo é compatível com a operação de CPU e GPU. O ambiente de GPU pode melhorar significativamente a velocidade de inferência. Certifique-se de que o driver da GPU e a versão CUDA sejam compatíveis com o PyTorch. Se estiver usando várias GPUs, você pode ativar device_map="auto" Distribuição automática:

model = AutoModelForCausalLM.from_pretrained(model_name, device_map="auto")

4. uso de modelos

Depois de carregar o modelo, a geração ou inferência de texto pode ser realizada com o seguinte código:

input_text = "请解释量子计算的基本原理"

inputs = tokenizer(input_text, return_tensors="pt").to("cuda") # 如果使用 GPU

outputs = model.generate(**inputs, max_length=200)

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(response)

max_lengthO parâmetro controla o comprimento máximo do texto gerado, que pode ser ajustado conforme necessário.- Para obter uma saída de maior qualidade, defina

temperature=0.7responder cantandotop_p=0.9Ajuste para gerar aleatoriedade:

outputs = model.generate(**inputs, max_length=200, temperature=0.7, top_p=0.9)

5. operação das principais funções

- Geração de textoResposta: Insira qualquer solicitação textual e o modelo gerará uma resposta coerente. Por exemplo, digite "Write a short essay on AI ethics" (Escreva um pequeno ensaio sobre a ética da IA) e o modelo gerará um ensaio claramente estruturado.

- inferência lógicaInsira um problema complexo, como "Resolva o seguinte problema de matemática: x^2 + 2x - 8 = 0", e o modelo raciocinará passo a passo e lhe dará a resposta.

- tarefa multilíngueDigite um prompt que não seja em inglês, como "Tell me about Paris in Spanish" (Fale-me sobre Paris em espanhol), e o modelo gerará uma resposta no idioma apropriado.

- Raciocínio otimizado: Ao definir o

max_lengthresponder cantandonum_beams(por exemplonum_beams=4) Habilite a pesquisa de feixe para melhorar a qualidade da geração:

outputs = model.generate(**inputs, max_length=200, num_beams=4)

6. implantação no ambiente de produção

Para implantar o modelo em um servidor, é recomendável usar a API de inferência da Hugging Face ou um serviço de inferência de terceiros, como o vLLM. Para a implantação local, certifique-se de que o servidor tenha memória suficiente (recomenda-se 32 GB ou mais) e recursos de GPU (pelo menos 16 GB de memória gráfica). Consulte a documentação oficial do Hugging Face:

https://huggingface.co/docs/transformers/main/en/main_classes/pipelines

7. advertências

- Os modelos não são implementados com nenhum provedor de inferência e precisam ser baixados e configurados por conta própria.

- Verifique os recursos de hardware antes de executar, a contagem de parâmetros 671B requer alta potência de computação.

- Para fazer o ajuste fino, use a função Hugging Face's

Trainerconsulte a documentação oficial:

https://huggingface.co/docs/transformers/main/en/training

Operação da função em destaque

- Raciocínio eficienteEm comparação com o R1-0528, o token do R1T2 é mais eficiente e adequado para tarefas de inferência de alta frequência. Definição

max_length=100Livros didáticos curtos podem ser gerados rapidamente. - Reparo de marcadoresO modelo processa automaticamente a marcação durante a inferência, garantindo uma saída consistente. Não é necessária nenhuma intervenção manual.

- Flexibilidade de código abertoOs desenvolvedores podem modificar os pesos do modelo para se adaptar a tarefas específicas. Por exemplo, o ajuste fino pode ser usado para personalizar um sistema de diálogo.

cenário do aplicativo

- pesquisa acadêmica

Os pesquisadores podem usar o R1T2 para analisar a literatura acadêmica, gerar relatórios de pesquisa ou responder a perguntas complexas. Por exemplo, digite "summarise recent advances in quantum mechanics" e o modelo extrairá as principais informações e gerará um relatório conciso. - criação de conteúdo

Os criadores de conteúdo podem usar o modelo para gerar artigos, publicações em mídias sociais ou textos de marketing. Digite "write a blog about the environment" (escrever um blog sobre o meio ambiente) para obter um artigo claramente estruturado. - desenvolvimento de tecnologia

Os desenvolvedores podem integrar modelos em chatbots ou assistentes inteligentes para dar suporte a interações multilíngues e processamento de tarefas complexas. Por exemplo, criar bots de atendimento ao cliente para lidar com as consultas dos usuários. - Auxílios educacionais

Alunos e professores podem usar os modelos para responder a perguntas de matemática, física, etc., ou para gerar materiais didáticos. Por exemplo, digite "Explain Newton's second law" (Explique a segunda lei de Newton) e o modelo fornecerá uma explicação detalhada.

QA

- Para quem é o DeepSeek-TNG-R1T2-Chimera?

Adequado para desenvolvedores, pesquisadores e criadores de conteúdo que precisam de geração de texto e raciocínio eficientes. O modelo é de código aberto e adequado para usuários com algumas habilidades de programação. - Qual é a melhoria do R1T2 em relação ao DeepSeek-R1T?

O R1T2 incorpora três modelos principais, melhora a velocidade em 20%, corrige problemas de marcação e apresenta melhor desempenho em testes como o GPQA. - Como posso reduzir os requisitos de hardware para executar o modelo?

Técnicas de quantificação de modelos (por exemplo, quantificação de 4 bits) ou implantação de GPU em nuvem podem ser usadas; consulte a documentação do Hugging Face. - Quais idiomas são compatíveis com o modelo?

Suporte a vários idiomas, incluindo inglês, chinês, espanhol etc., o escopo específico do suporte precisa ser testado e verificado.