EXO: execução de clusters de IA distribuídos usando dispositivos domésticos ociosos, com suporte a vários mecanismos de inferência e descoberta automatizada de dispositivos.

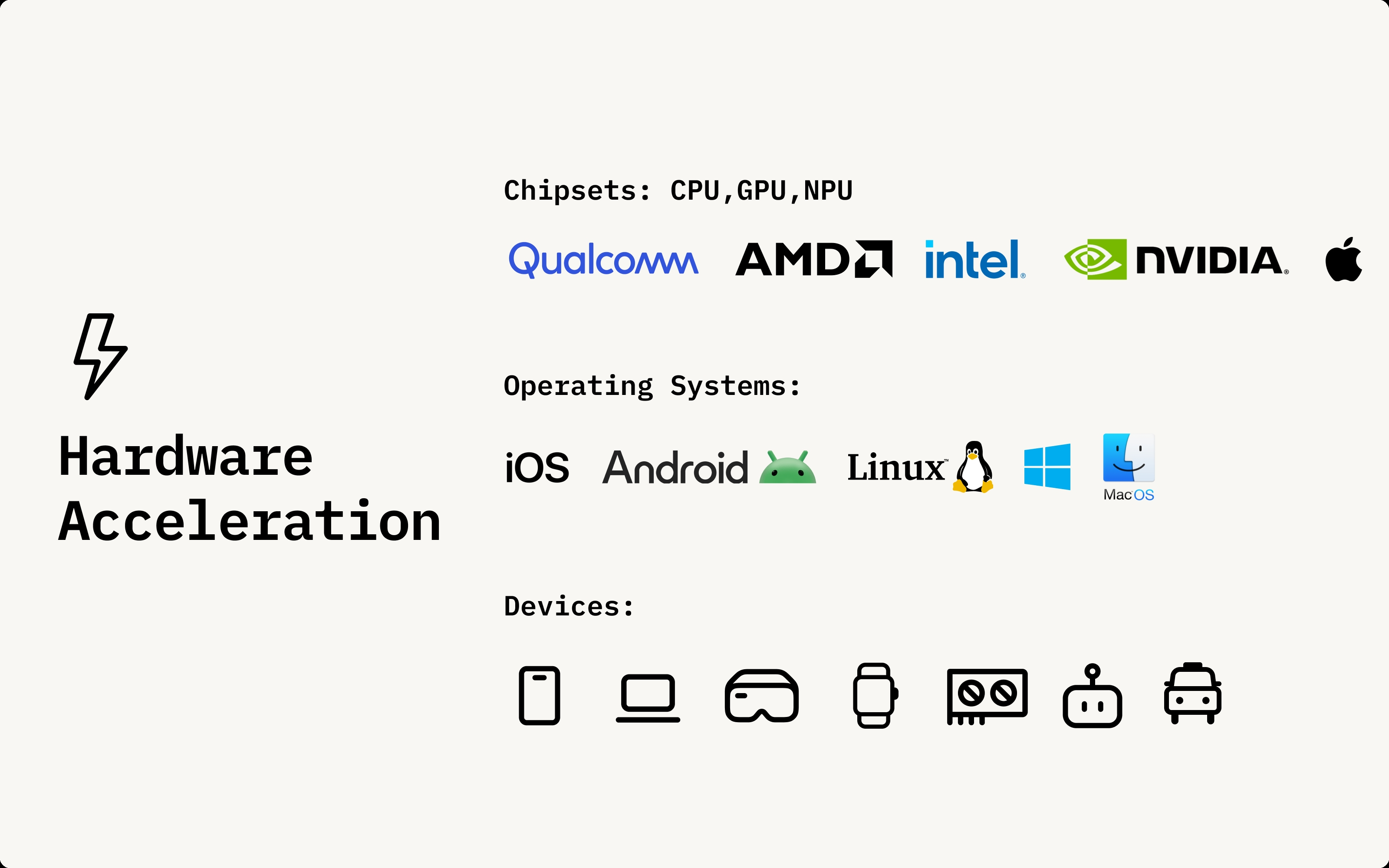

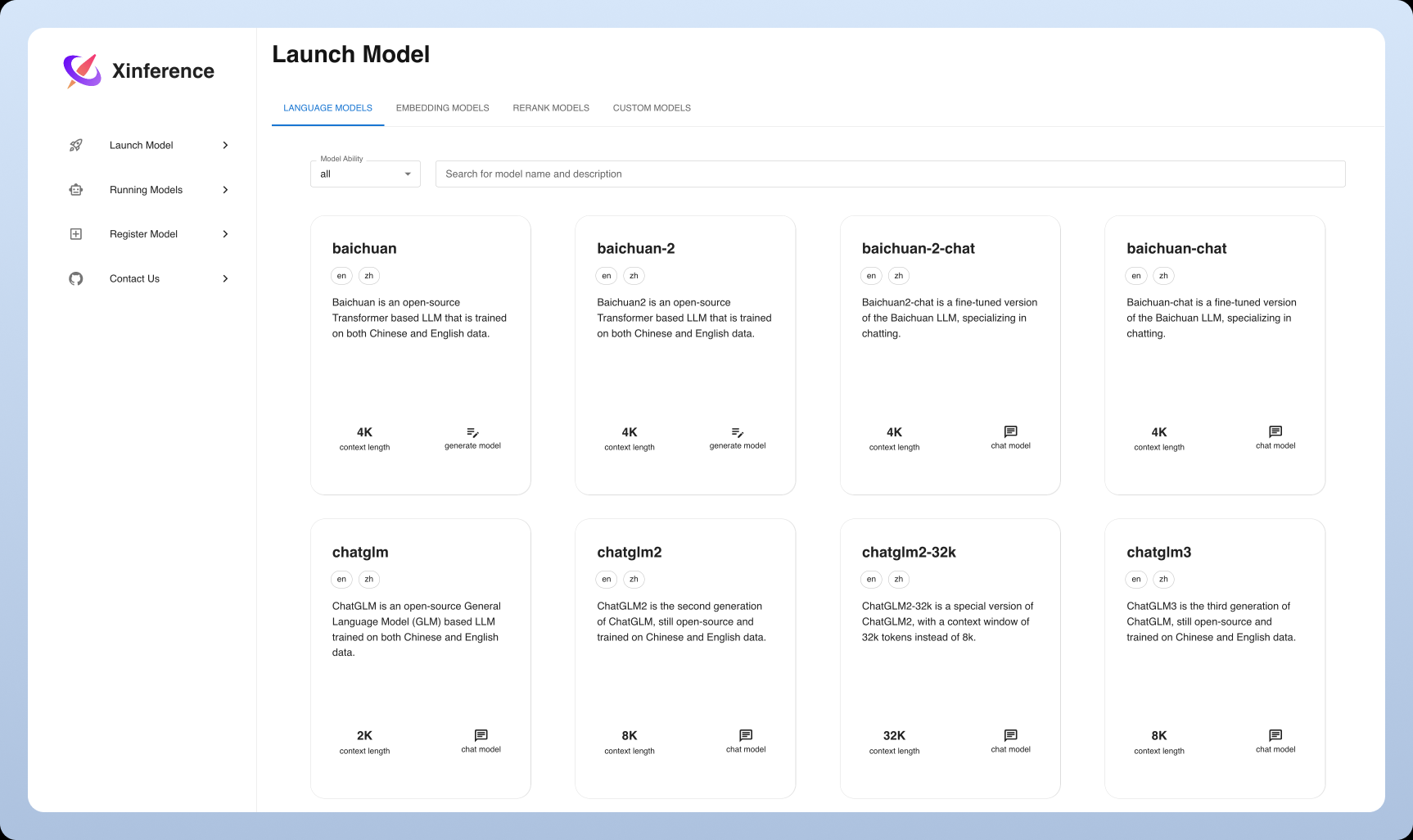

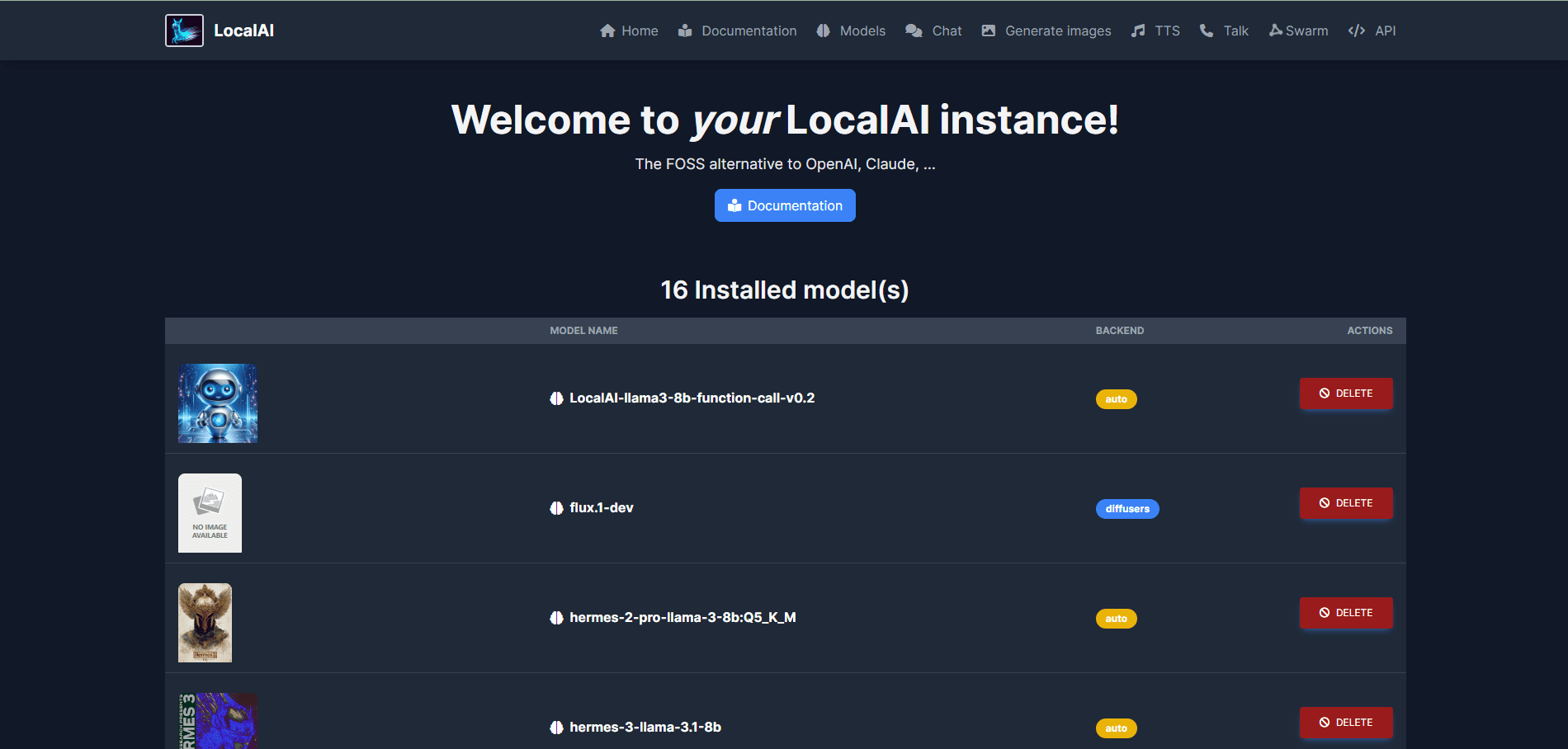

O Exo é um projeto de código aberto que tem como objetivo executar seu próprio cluster de IA usando dispositivos cotidianos (por exemplo, iPhone, iPad, Android, Mac, Linux etc.). Por meio do particionamento dinâmico de modelos e da descoberta automatizada de dispositivos, o Exo é capaz de unificar vários dispositivos em uma única GPU avançada, com suporte a vários modelos, como LLaMA, Mistral...