O Baidu anunciou em 30 de junho que abriu oficialmente o código-fonte de seu mais recente ERNIE 4.5 Uma família de modelos multimodais de larga escala. A família é composta por 10 variantes em diferentes escalas, abrangendo totalmente a arquitetura Mixed Expertise (MoE) e fornecendo uma solução de pilha completa, desde modelos até kits de desenvolvimento e ferramentas de implantação, tudo na plataforma Apache 2.0 Aberto sob licença.

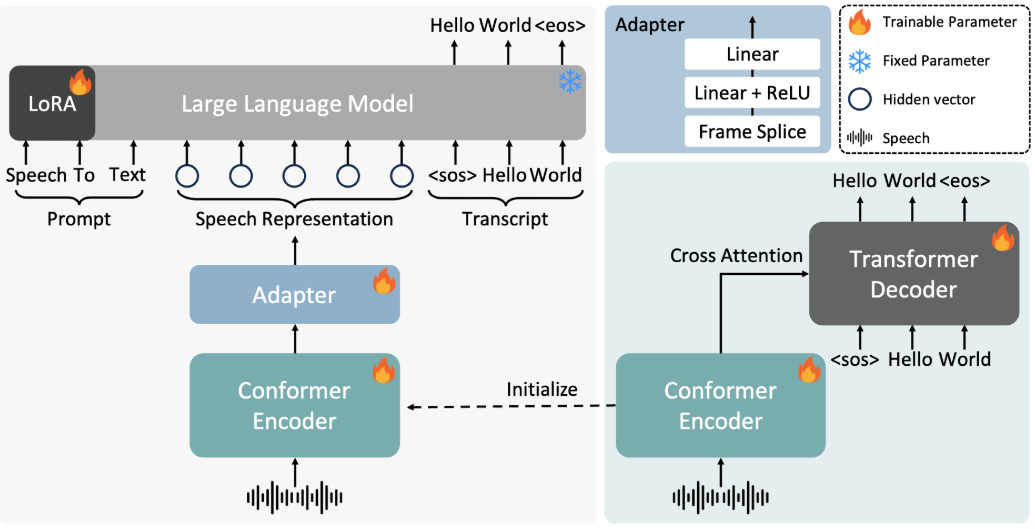

Núcleo da tecnologia: Arquitetura de MoE heterogênea projetada para multimodalidade

Ao contrário do modelo MoE, que é comum no setor, o modeloERNIE 4.5 Uma das características distintivas do MoE é sua abordagem inovadora de pré-treinamento "Multimodal Heterogeneous MoE". A arquitetura foi projetada para permitir que o modelo compartilhe parâmetros comuns ao processar informações multimodais, como texto e imagens, ao mesmo tempo em que mantém parâmetros independentes dedicados a modalidades específicas.

Para atingir esse objetivo, a equipe de P&D projetou uma variedade de técnicas, incluindo roteamento isolado por modalidade, perda ortogonal de roteador e perda balanceada de token multimodal. A ideia central desses projetos é garantir que a aprendizagem das modalidades textual e visual possa se promover mutuamente em vez de interferir uma na outra durante o treinamento conjunto, melhorando significativamente a compreensão multimodal do modelo sem sacrificar o desempenho da tarefa textual.

Além da arquitetura do modelo, a Baidu também destacou suas otimizações de eficiência na infraestrutura de treinamento e inferência. Com técnicas como paralelismo especializado no nó, agendamento de pipeline com eficiência de memória, treinamento de precisão mista FP8 e recomputação refinada, o pré-treinamento de seu maior modelo de linguagem atingiu uma utilização de FLOPs de modelo (MFU) de 47%. No lado da inferência, oERNIE 4.5 Algoritmos como a colaboração paralela de vários especialistas e a quantificação codificada convolucional foram usados para obter a quantificação de 4 bits/2 bits de baixo teor.

Desempenho: comparação multidimensional com os principais modelos do setor

De acordo com os resultados de benchmarking publicados pelo BaiduERNIE 4.5 Forte competitividade em várias dimensões.

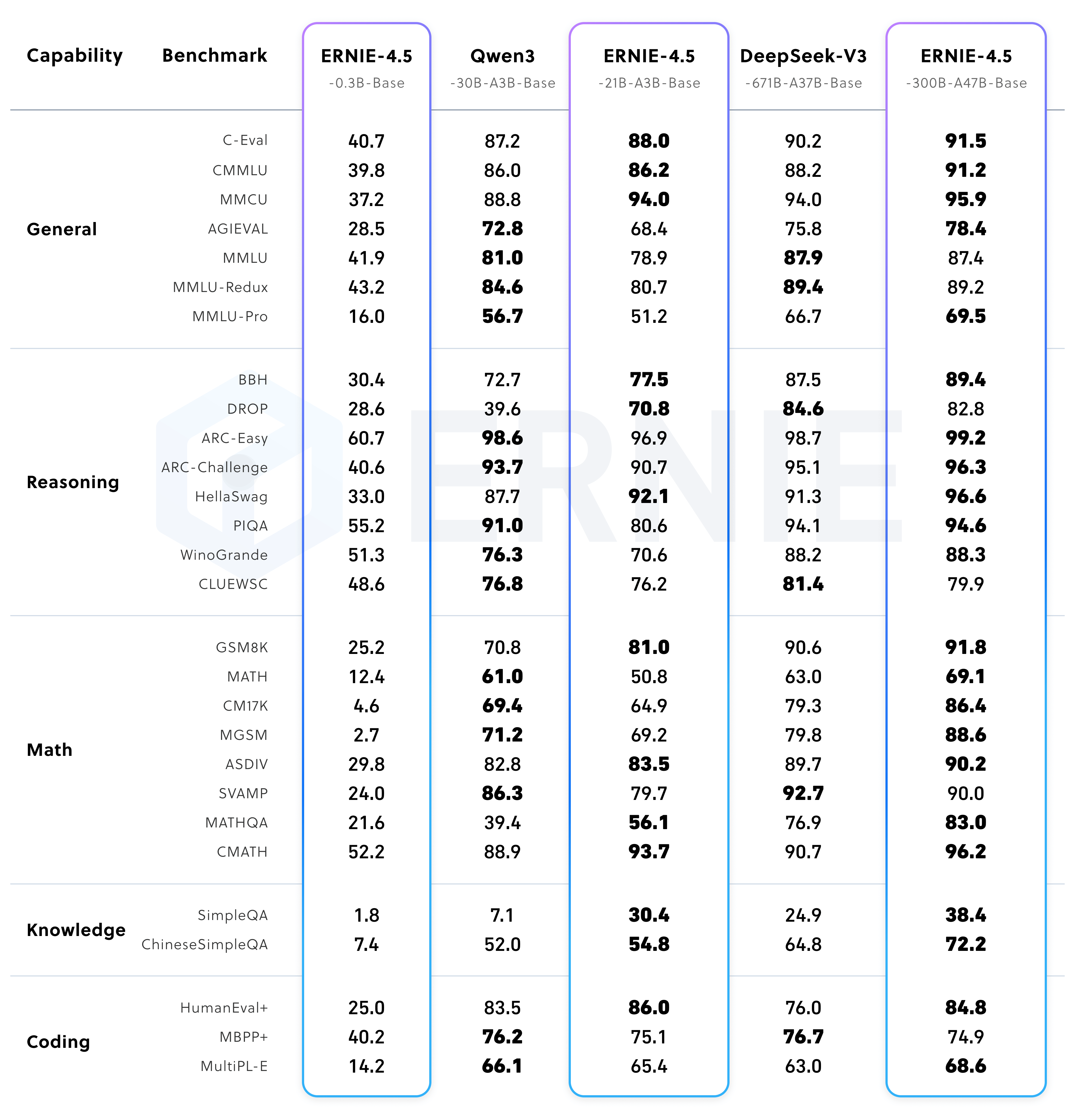

Desempenho do modelo básico pré-treinado

ERNIE-4.5-300B-A47B-Base O modelo apresenta desempenho superior em 22 dos 28 benchmarks. DeepSeek-V3-671B-A37B-Base. Isso mostra que o modelo está na vanguarda das tarefas de generalização, raciocínio e conhecimento intensivo.

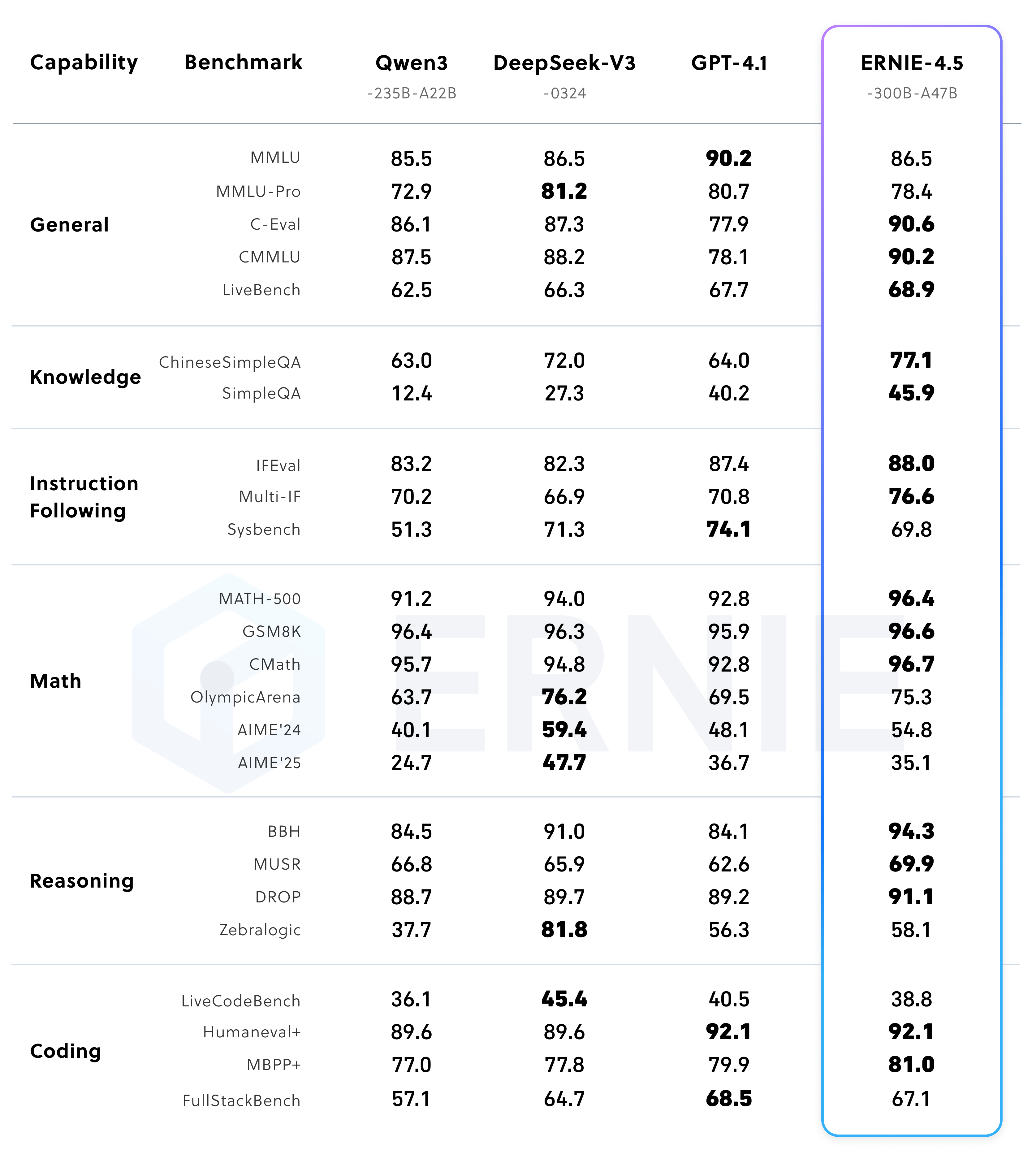

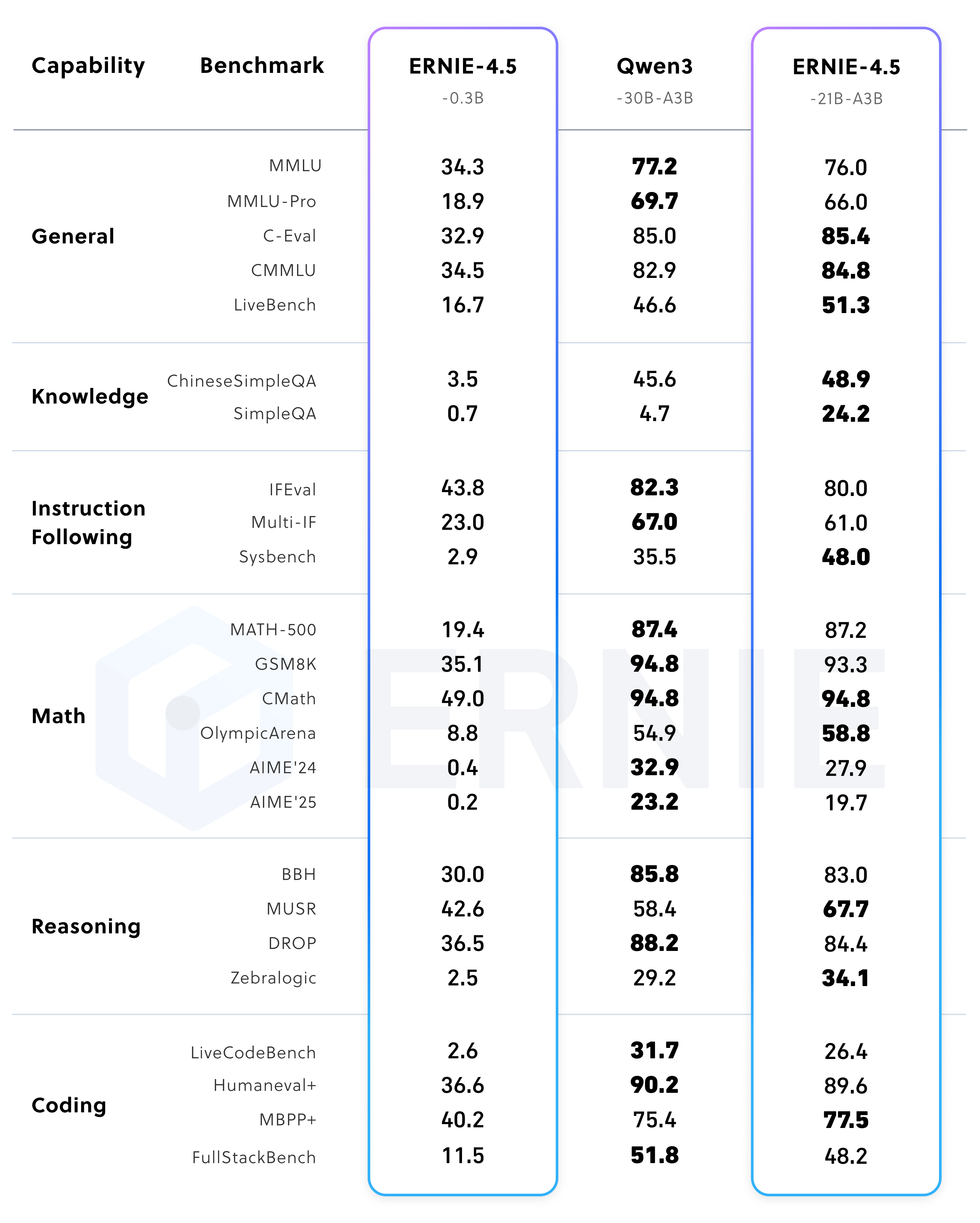

Desempenho do modelo após o ajuste fino do comando

Após o ajuste fino do comando ERNIE-4.5-300B-A47B O modelo obteve as melhores pontuações em tarefas como Instrução Seguida (IFEval) e Questionário de Conhecimento (SimpleQA).

Ao mesmo tempo, o tamanho menor do parâmetro ERNIE-4.5-21B-A3B O modelo, que tem um número total de senadores de cerca de Qwen3-30B do 70%, mas supera o último em benchmarks matemáticos e de inferência, como BBH e CMATH, demonstrando alta eficiência de parâmetros.

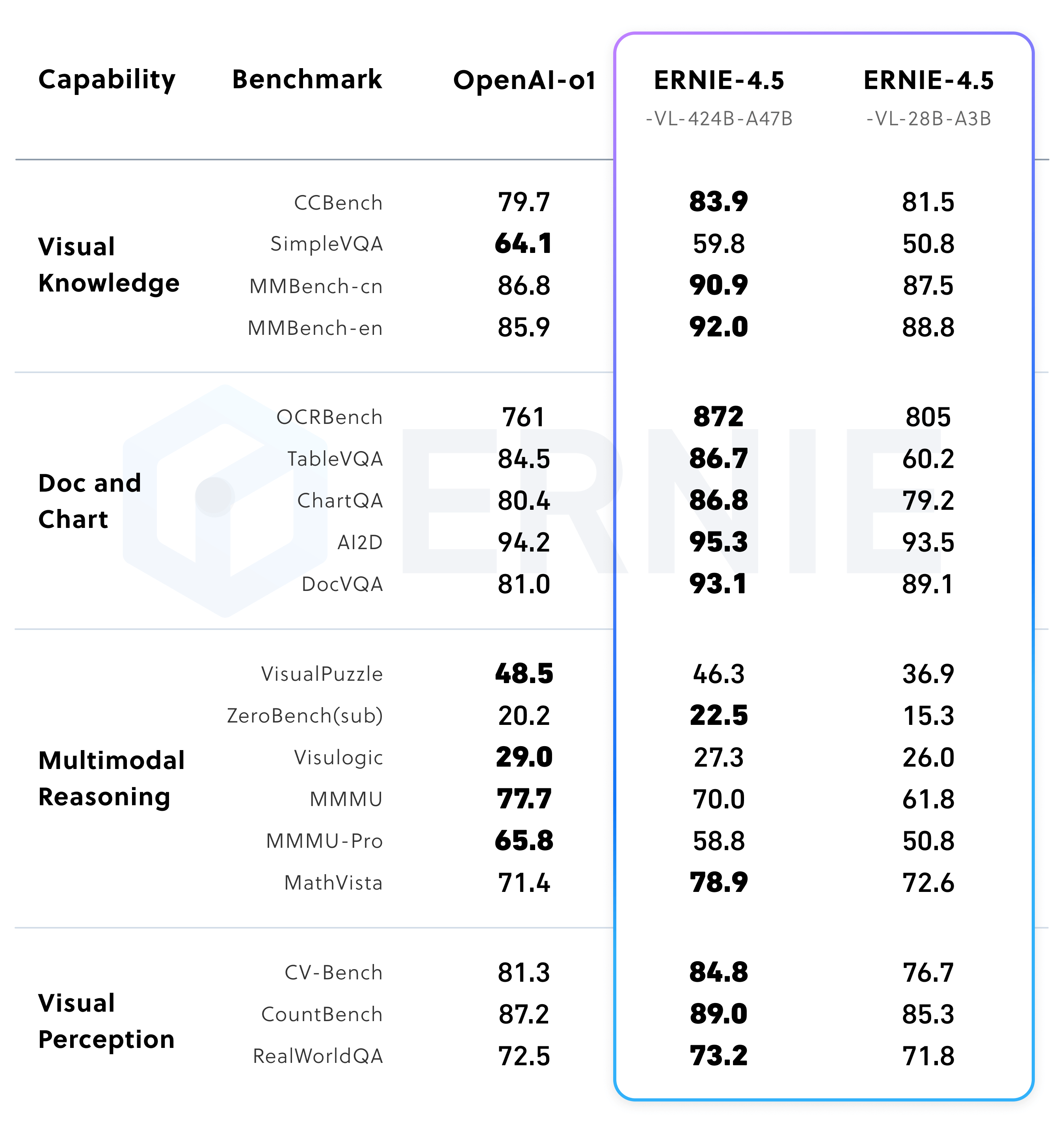

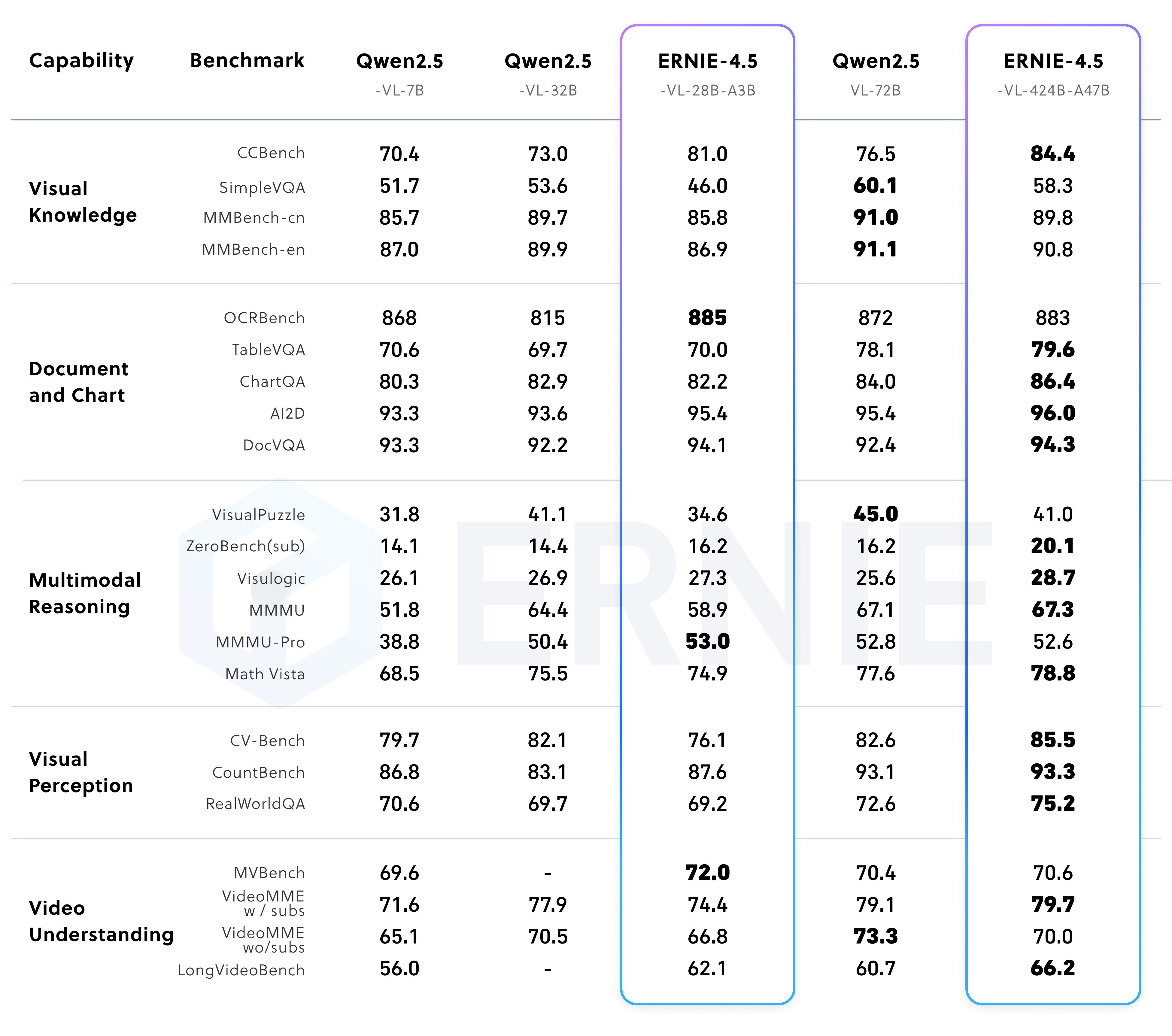

Desempenho do modelo multimodal

ERNIE 4.5 O Modelo de Linguagem Visual (VLM) suporta tanto o "modo de pensar" quanto o "modo de não pensar".

No modo não pensante, o modelo se concentra na percepção visual eficiente e na compreensão de documentos e diagramas. Já no modo de pensamento, o modelo mantém fortes recursos perceptivos e melhora significativamente a capacidade de MathVistaeMMMU Capacidade de raciocínio em benchmarks complexos, comoERNIE-4.5-VL A versão leve do Qwen2.5-VL-32B.

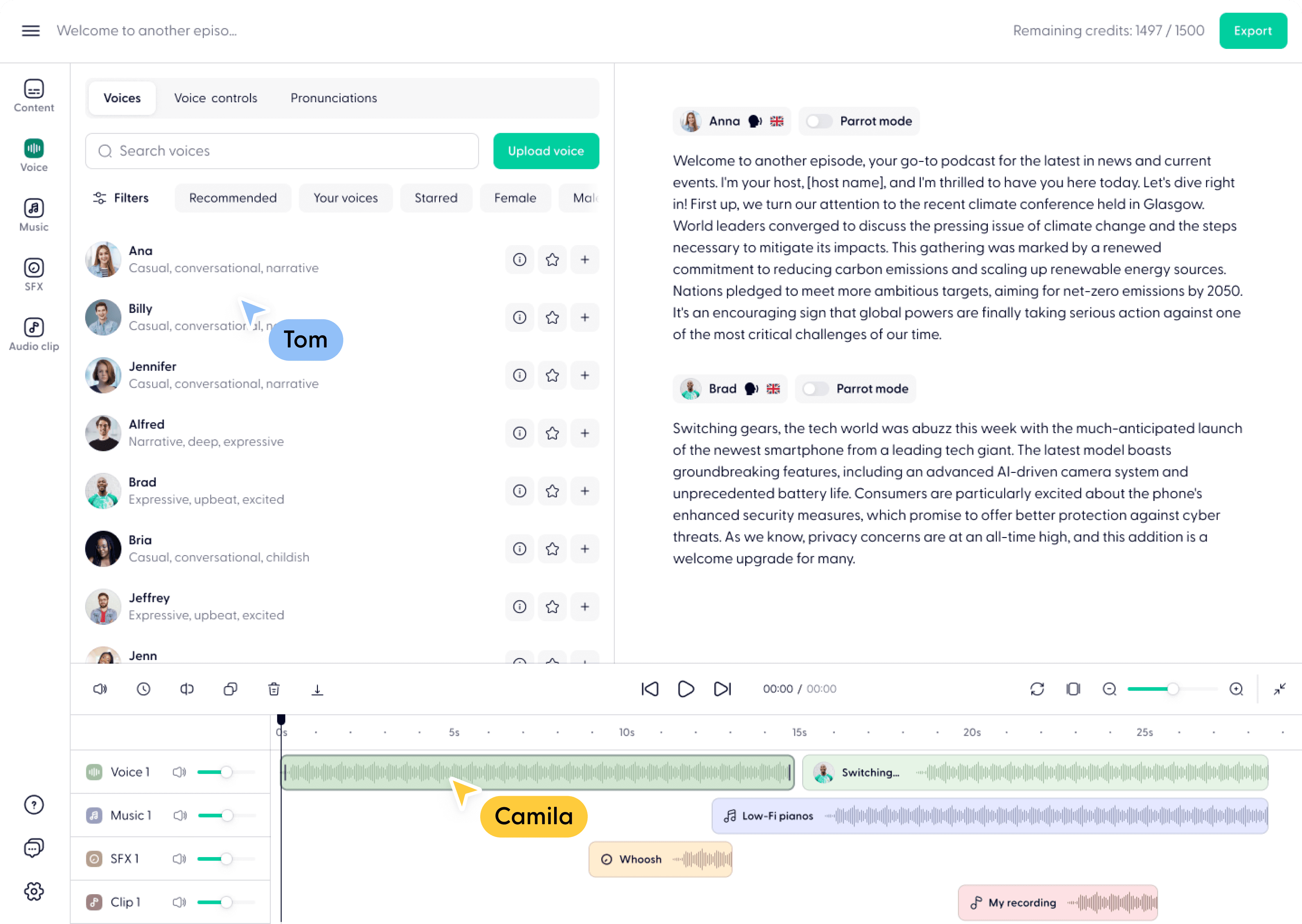

Ecologia e cadeia de ferramentas:ERNIEKit responder cantando FastDeploy

ERNIE 4.5 A família de modelos é baseada em PaddlePaddle treinamento em estrutura de aprendizagem profunda e também oferece PyTorch Versões compatíveis. A Baidu lançou duas ferramentas principais com o objetivo de reduzir a barreira de uso para os desenvolvedores.

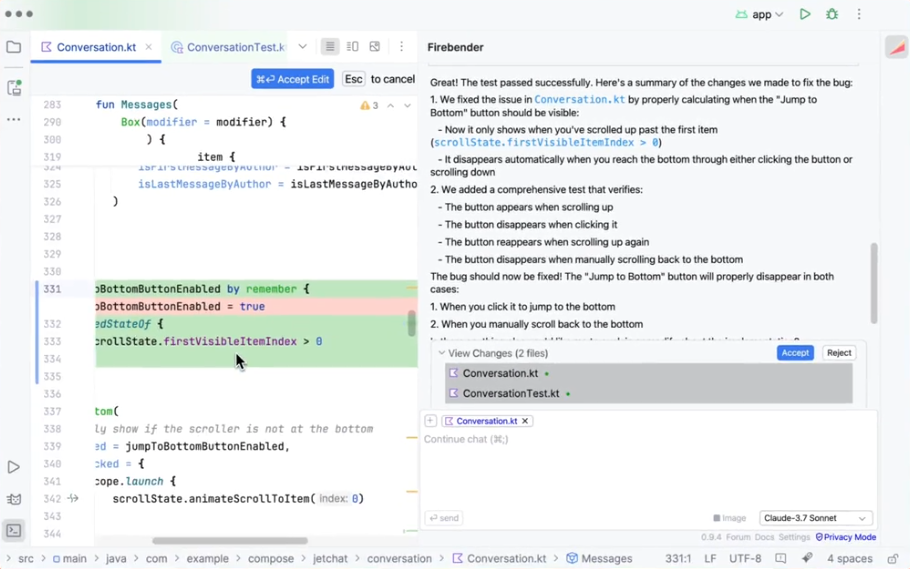

- ERNIEKit: ajuste fino e alinhamento do modelo

ERNIEKité um kit de ferramentas de desenvolvimento de nível industrial que oferece suporte a ajuste fino supervisionado (SFT), otimização de preferência direta (DPO) eLoRAtreinamento com consciência quantitativa (QAT) e quantificação pós-treinamento (PTQ), além de uma série de outras técnicas convencionais de treinamento e compressão.Os desenvolvedores podem fazer download de modelos e executar tarefas de SFT ou DPO por meio de ferramentas de linha de comando.

# 下载模型 huggingface-cli download baidu/ERNIE-4.5-300B-A47B-Base-Paddle \ --local-dir baidu/ERNIE-4.5-300B-A47B-Base-Paddle # 监督微调 (SFT) erniekit train examples/configs/ERNIE-4.5-300B-A47B/sft/run_sft_wint8mix_lora_8k.yaml \ model_name_or_path=baidu/ERNIE-4.5-300B-A47B-Base-Paddle - FastDeploy: implantação eficiente de modelos

FastDeployé um kit de ferramentas de implantação eficiente para modelos grandes com uma API compatível com ovLLMresponder cantandoOpenAIque oferece suporte à implantação de serviços com um clique. Ele fornece aERNIE 4.5O modelo MoE da Microsoft oferece uma solução de implantação de vários computadores de nível industrial com técnicas de aceleração integradas, como quantificação de poucos bits, cache de contexto e decodificação especulativa.O código de exemplo de inferência local é o seguinte:

from fastdeploy import LLM, SamplingParams prompt = "Write me a poem about large language model." sampling_params = SamplingParams(temperature=0.8, top_p=0.95) llm = LLM(model="baidu/ERNIE-4.5-0.3B-Paddle", max_model_len=32768) outputs = llm.generate(prompt, sampling_params)As implantações com serviços, por outro lado, podem ser iniciadas com uma única linha de comando:

python -m fastdeploy.entrypoints.openai.api_server \ --model "baidu/ERNIE-4.5-0.3B-Paddle" \ --max-model-len 32768 \ --port 9904

Licenciamento e citação de código aberto

ERNIE 4.5 O modelo segue Apache License 2.0 a licença permite o uso comercial.

Para citar em sua pesquisa, use o seguinte BibTeX Formato:

@misc{ernie2025technicalreport,

title={ERNIE 4.5 Technical Report},

author={Baidu ERNIE Team},

year={2025},

eprint={},

archivePrefix={arXiv},

primaryClass={cs.CL},

url={}

}