关键词:H100 价格飙升、补贴推理定价、出口管制、MLA

DeepSeek 的叙事风靡全球

DeepSeek 风靡全球。在过去一周里,DeepSeek 一直是世界上每个人都想谈论的唯一话题。目前,DeepSeek 的每日流量远高于 Claude、Perplexity,甚至 Gemini。

但对于密切关注该领域的人来说,这并不完全是“新”闻。我们 一直 在 谈论 DeepSeek 已经几个月了 (每个链接都是一个例子)。这家公司并不新鲜,但狂热的炒作是新鲜的。SemiAnalysis 长期以来一直认为 DeepSeek 非常有才华,而美国更广泛的公众并不关心。当世界最终关注时,它以一种不反映现实的狂热炒作方式进行。

我们想强调的是,这种说法与上个月相比发生了变化,当时 Scaling Laws 被打破,我们消除了这个误解,现在算法改进太快了,这在某种程度上对 Nvidia 和 GPU 也不利。

背景:2024 年 12 月 11 日 Scaling Laws – O1 Pro 架构、推理训练基础设施、Orion 和 Claude 3.5 Opus 的“失败”

现在的说法是,DeepSeek 非常高效,以至于我们不需要更多的计算,而且由于模型的变化,现在一切都出现了巨大的产能过剩。虽然杰文斯悖论也被过度炒作,但杰文斯更接近现实,这些模型已经诱发了需求,对 H100 和 H200 的定价产生了切实的影响。

DeepSeek 和 High-Flyer

High-Flyer 是一家中国对冲基金,也是在其交易算法中使用 AI 的早期采用者。他们很早就意识到 AI 在金融以外领域的潜力以及 Scaling 的关键洞察力。因此,他们一直在增加 GPU 的供应。在用数千个 GPU 的集群对模型进行试验后,High Flyer 在 2021 年投资了 10,000 个 A100 GPU *在任何出口限制之前。*这得到了回报。随着 High-Flyer 的改进,他们意识到是时候在 2023 年 5 月分拆“DeepSeek”了,目标是更专注地追求进一步的 AI 能力。High-Flyer 自行资助了该公司,因为当时外部投资者对 AI 没什么兴趣,主要担心的是缺乏商业模式。High-Flyer 和 DeepSeek 今天经常共享资源,包括人力和计算资源。

DeepSeek 现在已经发展成为一家严肃、协同努力的公司,绝不是许多媒体声称的“副业”。我们相信,即使考虑到出口管制,他们的 GPU 投资也超过 5 亿美元。

-

来源:SemiAnalysis, Lennart Heim

GPU 情况

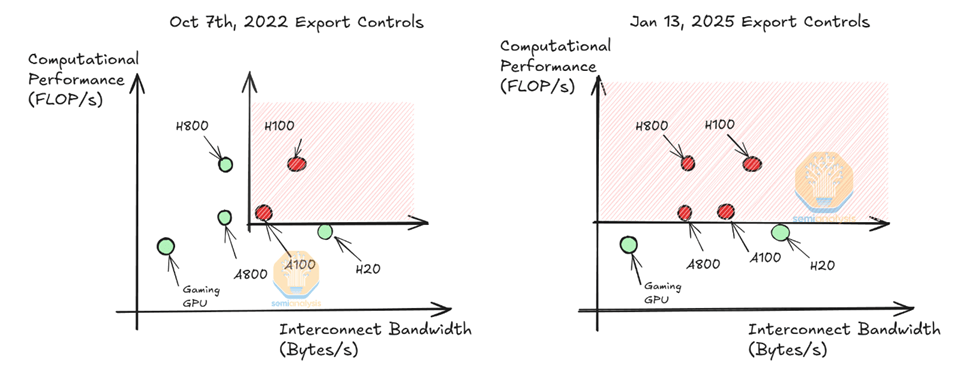

我们认为他们可以使用大约 50,000 个 Hopper GPU,这与某些人声称的 50,000 个 H100 不同。Nvidia 制造了不同型号的 H100 以符合不同的法规 (H800、H20),目前只有 H20 可供中国的模型提供商使用。请注意,H800 与 H100 具有相同的计算能力,但网络带宽较低。

我们认为 DeepSeek 可以使用大约 10,000 个 H800 和大约 10,000 个 H100。此外,他们还订购了更多的 H20,Nvidia 在过去 9 个月中生产了超过 100 万个中国专用 GPU。这些 GPU 在 High-Flyer 和 DeepSeek 之间共享,并在一定程度上进行地理分布。它们用于交易、推理、训练和研究。有关更具体的详细分析,请参阅我们的加速器模型。

-

来源:SemiAnalysis

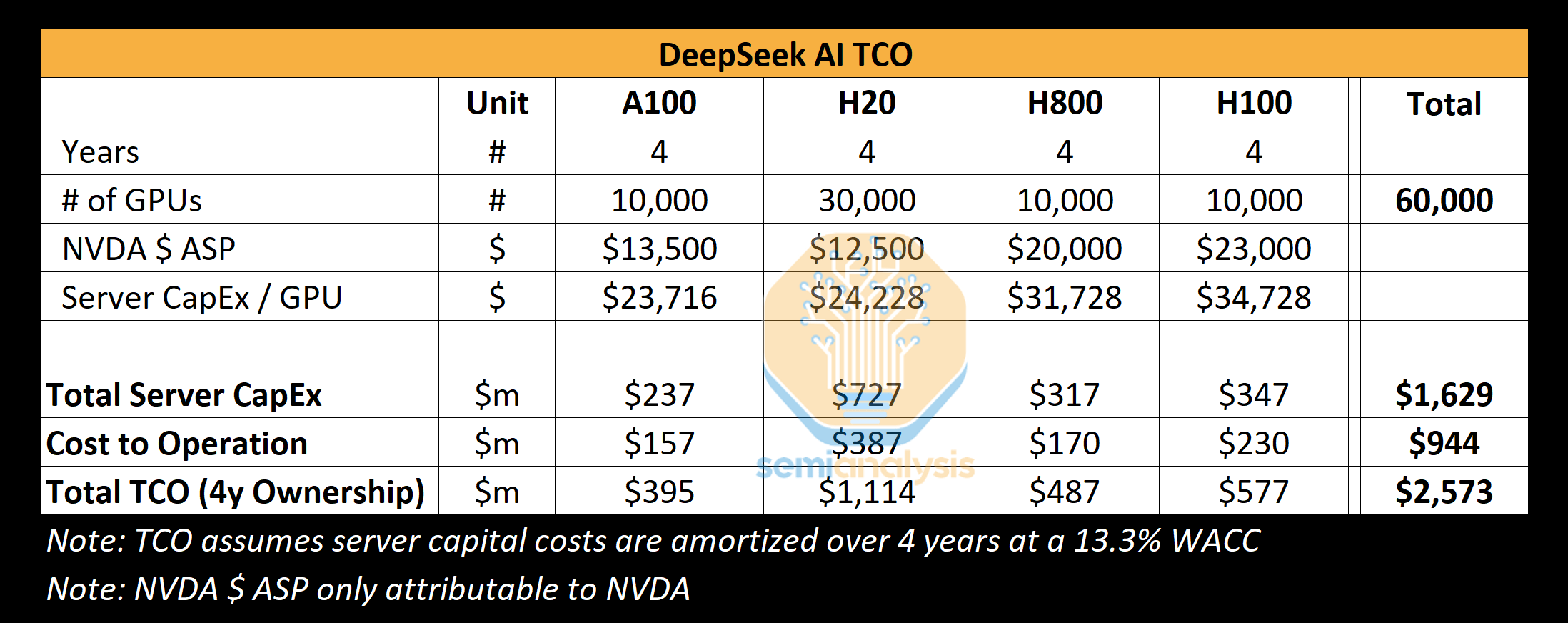

我们的分析表明,DeepSeek 的服务器总资本支出约为 16 亿美元,运营此类集群的相关成本高达 9.44 亿美元。同样,所有 AI 实验室和超大规模企业都有更多的 GPU 用于各种任务,包括研究和训练,而不是他们提交给单个训练运行的 GPU,因为资源的集中是一个挑战。X.AI 是一家独特的 AI 实验室,其所有 GPU 都位于 1 个位置。

DeepSeek 专门从中国采购人才,不考虑以前的资历,非常注重能力和好奇心。DeepSeek 定期在北京大学和浙江大学等顶尖大学举办招聘活动,许多员工都毕业于这些大学。职位不一定是预先定义的,招聘人员被赋予灵活性,招聘广告甚至吹嘘可以使用 10,000 多个 GPU 且没有使用限制。他们极具竞争力,据称向有前途的候选人提供超过 130 万美元的薪水,远高于竞争激烈的中国大型科技公司和 AI 实验室,如 Moonshot。他们有大约 150 名员工,但正在迅速增长。

历史表明,一个资金充足、专注的小型初创公司通常可以突破可能的界限。DeepSeek 缺乏像 Google 这样的官僚机构,而且由于他们是自筹资金,可以迅速推进想法。然而,与 Google 一样,DeepSeek (在大多数情况下) 运行自己的数据中心,不依赖外部方或提供商。这为实验开辟了更多的空间,使他们能够在整个堆栈中进行创新。

我们相信他们是当今最好的“开放权重”实验室,击败了 Meta 的 Llama、Mistral 和其他公司。

DeepSeek 的成本和性能

DeepSeek 的价格和效率引发了本周的狂热,主要标题是 DeepSeek V3 的“600 万美元”训练成本。这是错误的。这类似于指出产品物料清单的特定部分并将其归因于整个成本。预训练成本是总成本中非常小的一部分。

训练成本

我们认为预训练数字远非模型的实际花费。我们相信他们在公司历史上在硬件上的花费远高于 5 亿美元。为了开发新的架构创新,在模型开发过程中,在测试新想法、新架构想法和消融方面有相当大的支出。多头潜注意力 (Multi-Head Latent Attention) 是 DeepSeek 的一项关键创新,花费了几个月的时间进行开发,并花费了整个团队的人力和 GPU 时间。

论文中 600 万美元的成本仅归因于预训练运行的 GPU 成本,这只是模型总成本的一部分。不包括难题的重要部分,如研发和硬件本身的 TCO。作为参考,Claude 3.5 Sonnet 的训练成本为数千万美元,如果这是 Anthropic 所需的全部成本,那么他们就不会从 Google 筹集数十亿美元,从 Amazon 筹集数百亿美元。这是因为他们必须进行实验、提出新的架构、收集和清理数据、支付员工工资等等。

那么 DeepSeek 是如何拥有如此大的集群的呢?出口管制的滞后是关键,将在下面的出口部分中讨论。

缩小差距 – V3 的性能

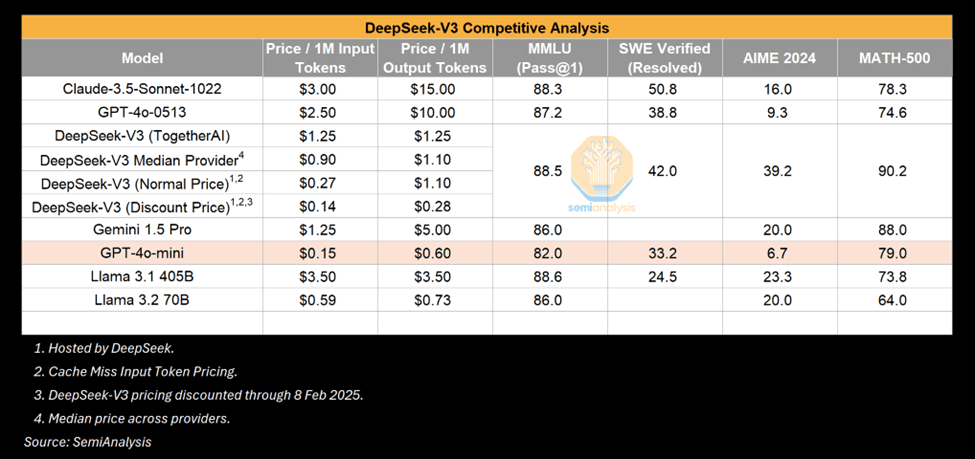

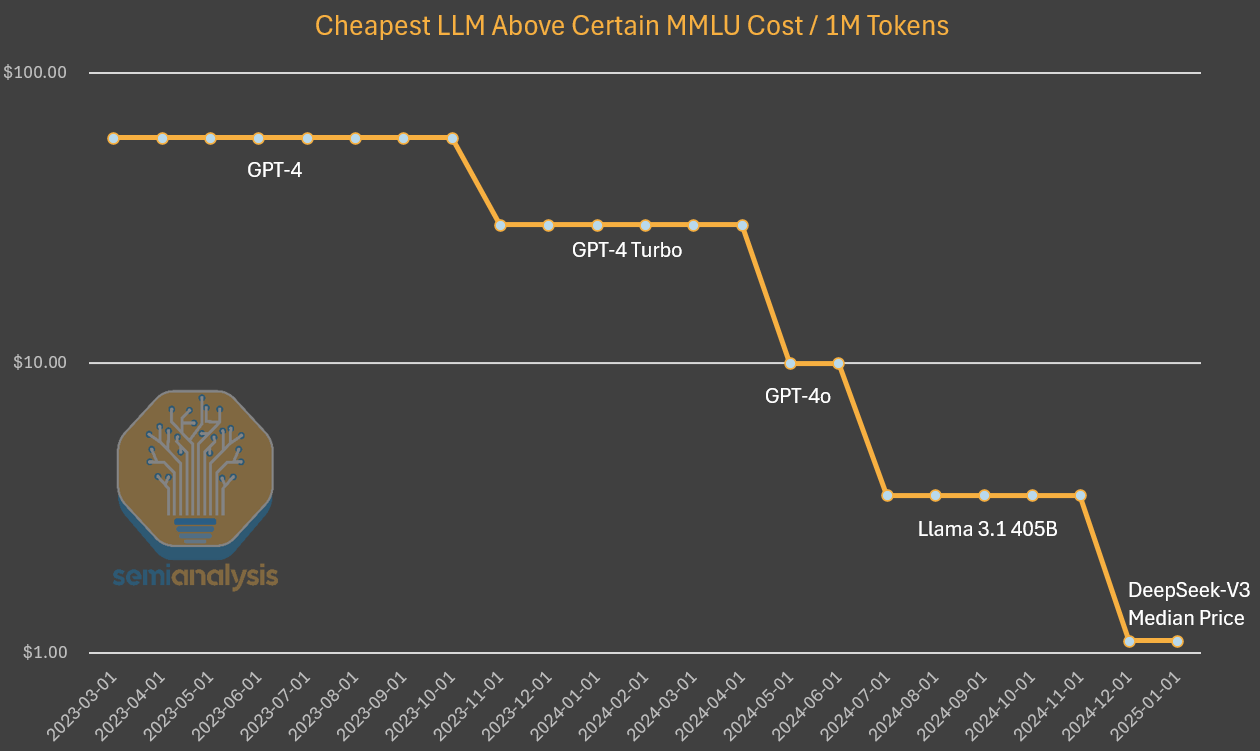

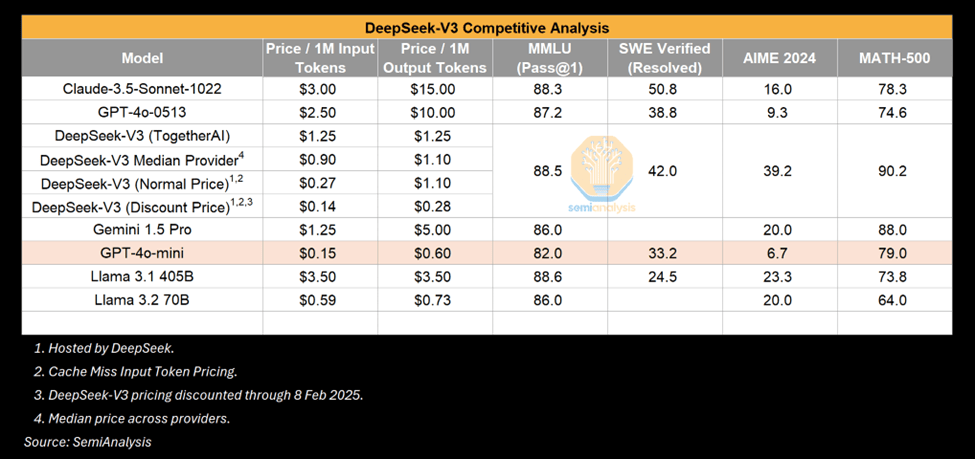

V3 无疑是一个令人印象深刻的模型,但值得强调的是 相对于什么令人印象深刻。许多人将 V3 与 GPT-4o 进行了比较,并强调 V3 如何击败 4o 的性能。这是真的,但 GPT-4o 是在 2024 年 5 月发布的。AI 发展迅速,2024 年 5 月在算法改进方面是另一个时代。此外,我们并不惊讶地看到在给定时间后,更少的计算就能实现相当或更强的能力。推理成本崩溃是 AI 改进的标志。

-

来源:SemiAnalysis

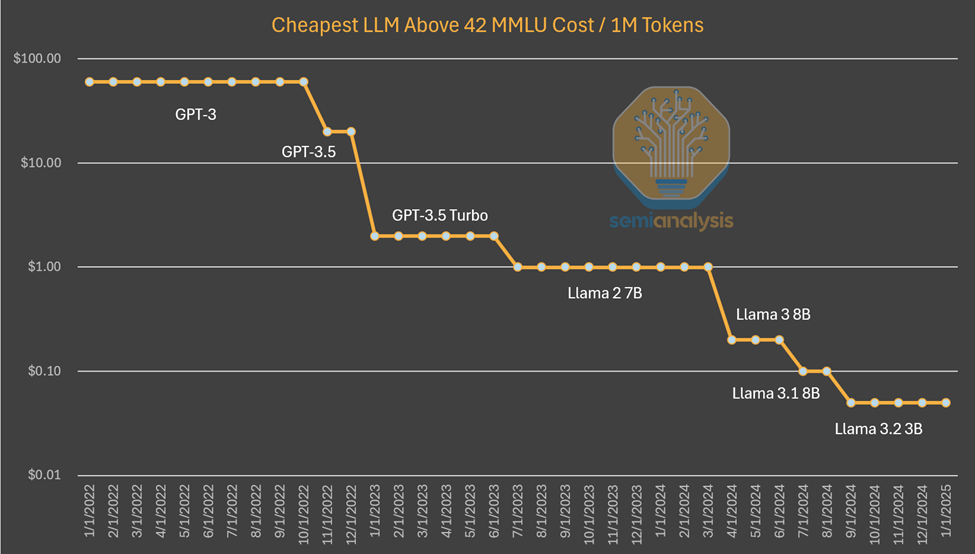

一个例子是可以在笔记本电脑上运行的小型模型具有与 GPT-3 相当的性能,GPT-3 需要一台超级计算机进行训练和多个 GPU 进行推理。换句话说,算法改进允许更少量的计算来训练和推理具有相同能力的模型,并且这种模式一次又一次地发挥作用。这次世界注意到了,因为它是来自 中国 的一个实验室。但是更小的模型变得更好并不是什么新鲜事。

-

来源:SemiAnalysis, Artificialanalysis.ai, Anakin.ai, a16z

到目前为止,我们目睹的这种模式是,AI 实验室花费更多的绝对美元来获得 更多 的智能。估计算法进展为每年 4 倍,这意味着每过一年,只需要少 4 倍的计算就能达到相同的能力。Anthropic 的 CEO Dario 认为,算法进步甚至更快,可以产生10 倍的改进。就 GPT-3 质量的推理定价而言,成本下降了 1200 倍。

在调查 GPT-4 的成本时,我们看到成本也有类似的下降,尽管在曲线的早期。虽然成本随时间的差异减少可以通过不再像上图那样保持能力恒定来解释。在这种情况下,我们看到算法改进和优化使成本降低了 10 倍,能力提高了 10 倍。

-

来源:SemiAnalysis, OpenAI, Together.ai

需要明确的是,DeepSeek 的独特之处在于他们首先实现了这种水平的成本和能力。他们在发布开放权重方面是独一无二的,但之前的 Mistral 和 Llama 模型过去也这样做过。DeepSeek 已经实现了这种水平的成本,但到今年年底,如果成本再下降 5 倍,请不要感到惊讶。

R1 的性能是否与 o1 相当?

另一方面,R1 能够取得与 o1 相当的结果,而 o1 仅在 9 月份宣布。DeepSeek 是如何如此迅速地赶上的?

答案是,推理是一种新的范式,具有更快的迭代速度和更容易实现的目标,与以前的范式相比,少量计算就能获得有意义的收益。正如我们的Scaling Laws 报告中所述,以前的范式依赖于预训练,而这正变得越来越昂贵,并且难以实现稳健的收益。

新范式侧重于通过在现有模型上进行后训练中的合成数据生成和强化学习来实现推理能力,从而以较低的价格实现更快的收益。较低的进入门槛加上简单的优化意味着 DeepSeek 能够比平时更快地复制 o1 方法。随着参与者弄清楚如何在这种新范式中进行更多扩展,我们预计匹配能力的时间差距会增加。

请注意,R1 论文 没有提及 使用的计算。这不是偶然的 – 需要大量的计算才能生成用于后训练 R1 的合成数据。这还不包括强化学习。R1 是一个非常好的模型,我们对此没有异议,并且如此迅速地赶上推理优势客观上令人印象深刻。DeepSeek 是中国的,并且用更少的资源赶上了,这一事实使其更加令人印象深刻。

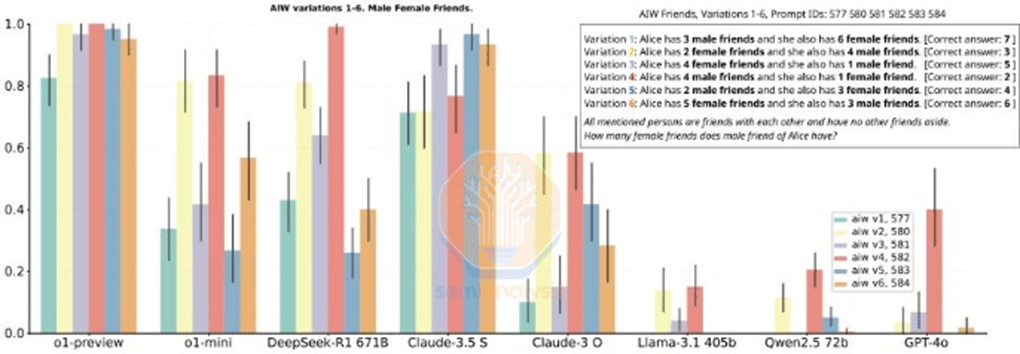

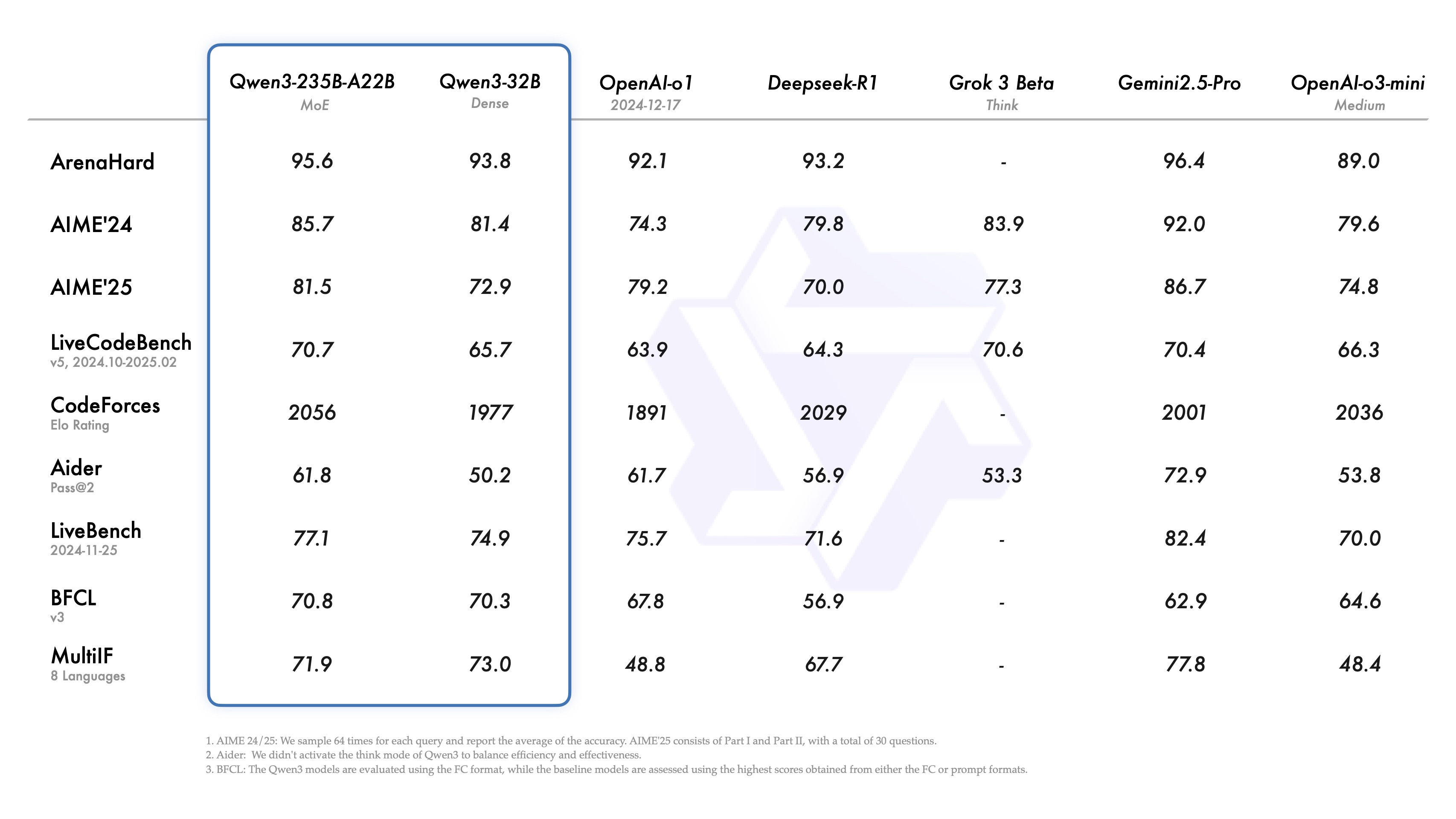

但 R1 提到的一些基准测试也 具有误导性。将 R1 与 o1 进行比较很棘手,因为 R1 没有特别提到他们不领先的基准测试。虽然 R1 在推理性能方面相匹配,但在每个指标上都不是明显的赢家,在许多情况下它比 o1 差。

-

来源:(Yet) another tale of Rise and Fall: DeepSeek R1

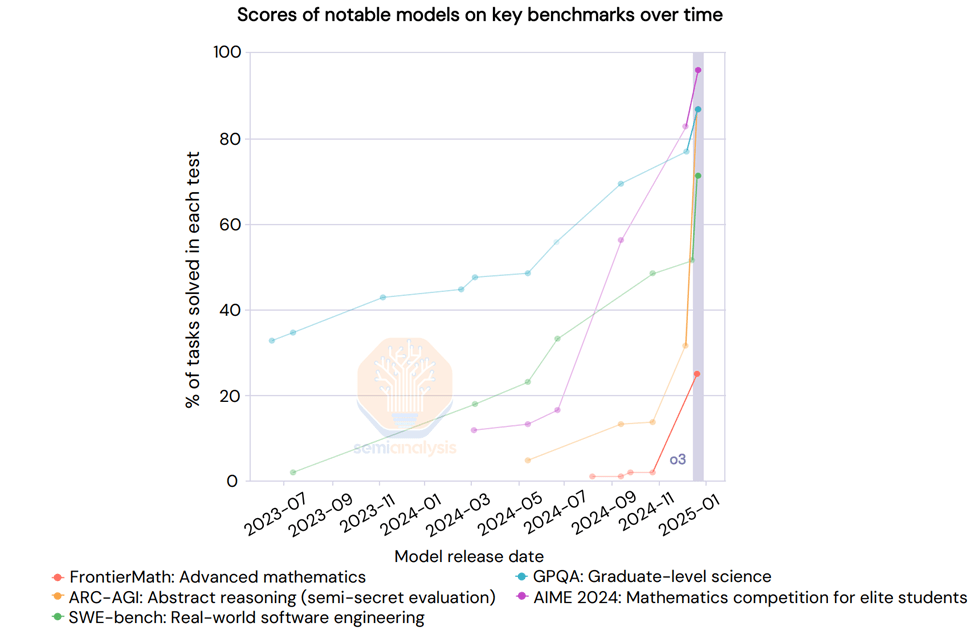

我们还没有提到 o3。o3 的能力明显高于 R1 或 o1。事实上,OpenAI 最近分享了 o3 的结果,基准测试的 Scaling 是垂直的。“深度学习已经碰壁”,但却是另一种。

-

来源:AI Action Summit

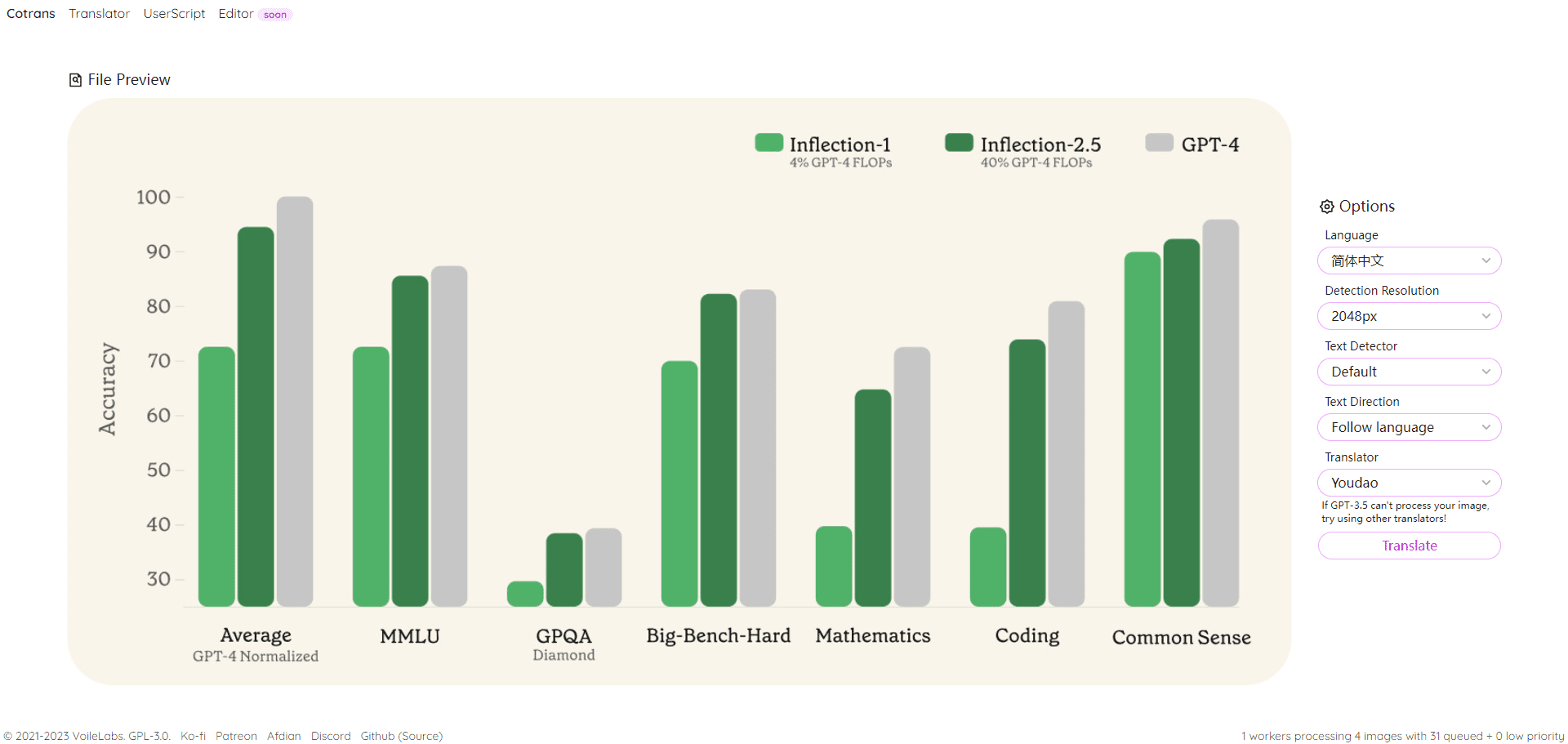

Google 的推理模型与 R1 一样好

虽然 R1 有一股狂热的炒作,但一家价值 2.5 万亿美元的美国公司在一个月前发布了一个更便宜的推理模型:Google 的 Gemini Flash 2.0 Thinking。该模型可供使用,并且通过 API 比 R1 便宜得多,即使模型的上下文长度更大。

在报告的基准测试中,Flash 2.0 Thinking 击败了 R1,尽管基准测试并不能说明全部情况。Google 只发布了 3 个基准测试,所以这是一个不完整的图景。尽管如此,我们认为 Google 的模型是稳健的,在许多方面都可以与 R1 抗衡,但却没有受到任何炒作。这可能是因为 Google 缺乏市场进入战略和糟糕的用户体验,但 R1 也是一个中国的惊喜。

-

来源:SemiAnalysis

需要明确的是,这些都不会减损 DeepSeek 的卓越成就。DeepSeek 作为一家快速发展、资金充足、聪明且专注的初创公司的结构是它在发布推理模型方面击败 Meta 等巨头的原因,这是值得称赞的。

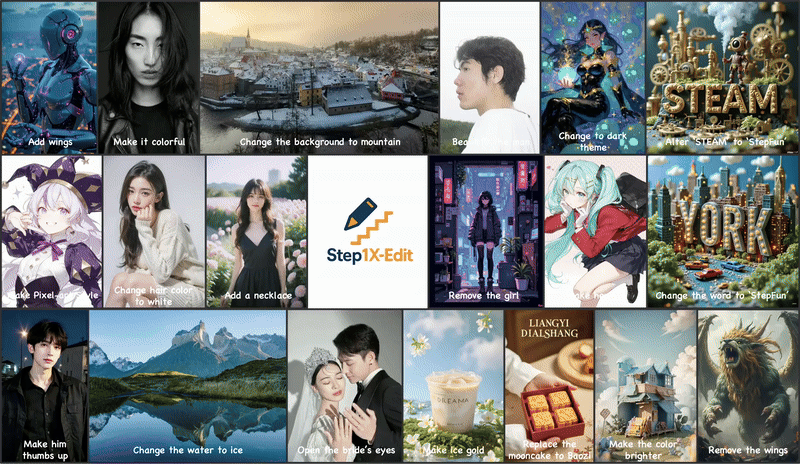

技术成就

DeepSeek 已经破解了密码并解锁了领先实验室尚未实现的创新。我们预计,任何已发布的 DeepSeek 改进都将几乎立即被西方实验室复制。

这些改进是什么?大多数架构成就专门与 V3 相关,V3 也是 R1 的基础模型。让我们详细介绍这些创新。

训练 (预训练和后训练)

DeepSeek V3 利用了前所未有规模的多 Token 预测 (MTP),这些是添加的注意力模块,可以预测接下来的几个 Token,而不是单个 Token。这提高了训练期间的模型性能,并且可以在推理期间丢弃。这是一个算法创新的例子,它以较低的计算量实现了改进的性能。

还有其他注意事项,例如在训练中进行 FP8 精度,但领先的美国实验室已经进行 FP8 训练一段时间了。

DeepSeek v3 也是一个混合专家模型,它是一个由许多其他较小的专家组成的大型模型,这些专家专门研究不同的事物,这是一种涌现行为。MoE 模型面临的一个难题是如何确定哪个 Token 进入哪个子模型或“专家”。DeepSeek 实现了一个“门控网络”,它以平衡的方式将 Token 路由到正确的专家,而不会影响模型性能。这意味着路由非常高效,并且相对于模型的整体大小,每个 Token 在训练期间只更改了几个参数。这增加了训练效率和低推理成本。

尽管担心混合专家 (MoE) 的效率提升可能会减少投资,但Dario 指出更强大的 AI 模型的经济效益是如此巨大,以至于任何节省的成本都会迅速再投资于构建更大的模型。MoE 改进的效率不会降低总体投资,而是会加速 AI Scaling 工作。这些公司专注于将模型扩展到更多的计算,并通过算法使其更有效率。

就 R1 而言,它从拥有一个强大的基础模型 (v3) 中受益匪浅。这部分是因为强化学习 (RL)。RL 有两个重点:格式化 (以确保它提供连贯的输出) 以及有用性和无害性 (以确保模型有用)。推理能力是在模型的微调过程中在一个合成数据集上出现的。这,如我们的 Scaling Laws 文章中所述,就是 o1 发生的事情。请注意,在 R1 论文中没有提到计算,这是因为提到使用了多少计算会表明他们拥有的 GPU 比他们的叙述所暗示的要多。这种规模的 RL 需要大量的计算,特别是生成合成数据。

此外,DeepSeek 使用的部分数据似乎来自 OpenAI 的模型,我们认为这将对从输出中提取的策略产生影响。这在服务条款中已经是非法的,但展望未来,一种新趋势可能是一种 KYC (了解你的客户) 形式来阻止提取。

说到提取,也许 R1 论文中最有趣的部分是能够通过使用来自推理模型的输出来微调非推理小型模型,从而将它们转变为推理模型。数据集管理总共包含 80 万个样本,现在任何人都可以使用 R1 的 CoT 输出制作自己的数据集,并在这些输出的帮助下制作推理模型。我们可能会看到更多的小型模型展示推理能力,从而提高小型模型的性能。

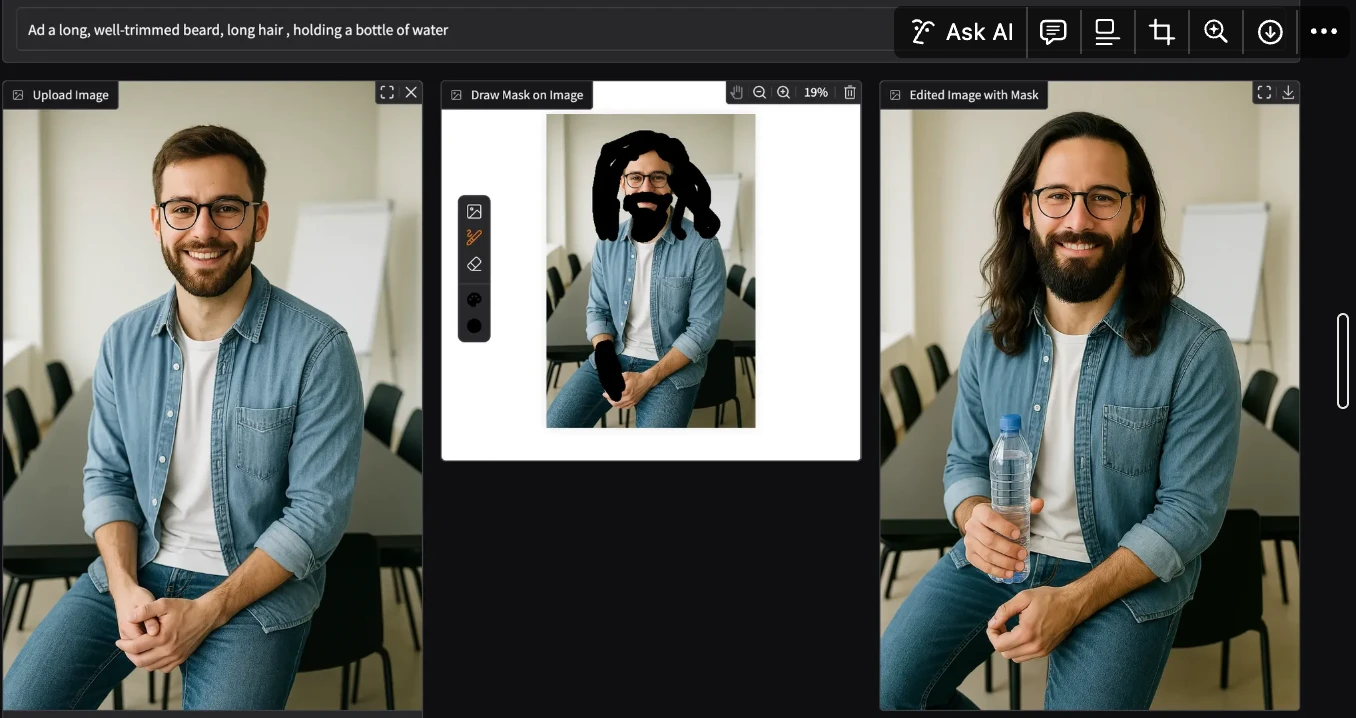

多头潜注意力 (MLA)

MLA 是一项关键创新,它使 DeepSeek 的推理价格大幅降低。原因是与标准注意力相比,MLA 将每次查询所需的 KV 缓存量减少了约 93.3%。KV 缓存是 Transformer 模型中的一种内存机制,用于存储表示对话上下文的数据,从而减少不必要的计算。

正如我们的 Scaling Laws 文章中所讨论的,KV 缓存随着对话上下文的增长而增长,并产生了相当大的内存限制。大幅减少每次查询所需的 KV 缓存量会减少每次查询所需的硬件数量,从而降低成本。然而,我们认为 DeepSeek 是以成本价提供推理以获得市场份额,而实际上并没有赚到任何钱。Google Gemini Flash 2 Thinking 仍然更便宜,而且 Google 不太可能以成本价提供。MLA 特别引起了许多领先的美国实验室的注意。MLA 在 2024 年 5 月发布的 DeepSeek V2 中发布。与 H100 相比,DeepSeek 还通过 H20 享受了更高的推理工作负载效率,因为 H20 具有更高的内存带宽和容量。他们还宣布了与华为的合作伙伴关系,但到目前为止,Ascend 计算方面的工作很少。

我们认为最有趣的含义特别是对利润的影响,以及这对整个生态系统的意义。下面我们对整个 AI 行业未来的定价结构进行了展望,并详细说明了为什么我们认为 DeepSeek 在补贴价格,以及为什么我们看到杰文斯悖论正在发挥作用的早期迹象。我们评论了对出口管制的影响,以及随着 DeepSeek 的主导地位增强,CCP 可能会如何反应等等。