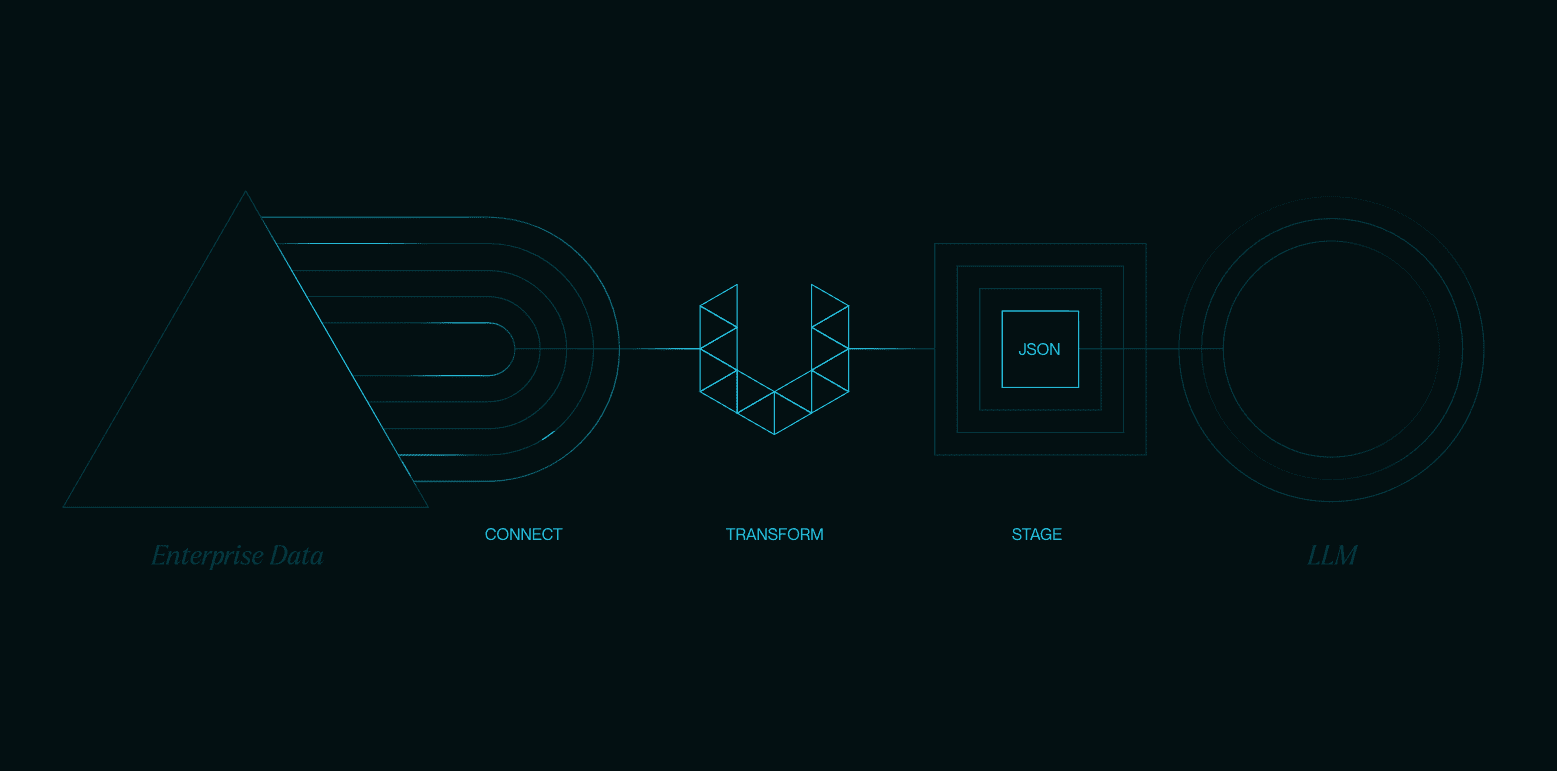

Nunchakuは、MIT HAN Labによって開発されたオープンソースの推論エンジンで、4ビットの定量化拡散モデルを効率的に実行することに重点を置いています。SVDQuant技術を用いてモデルの重みと活性度を4ビットに定量化し、メモリフットプリントと推論レイテンシーを大幅に削減します。 フラックス やSANAなどの拡散モデルを使用して、画像の生成、編集、変換などの作業を行うことができます。以下と互換性があります。 ComfyUI このプロジェクトは、研究者や開発者が低リソースデバイス上で複雑なモデルを実行するためのユーザーフレンドリーなインターフェースを提供する。このプロジェクトはGitHub上でオープンソースとして公開されており、活発なコミュニティが存在し、ユーザーがすぐに使い始められるように詳細なドキュメントとサンプルスクリプトを提供している。

機能一覧

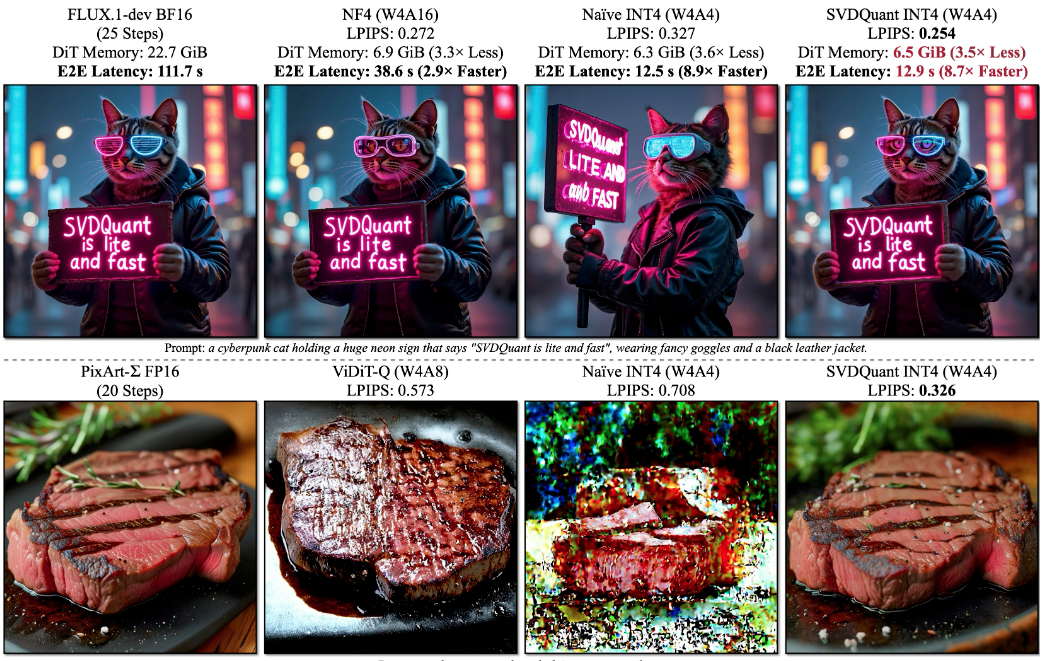

- メモリフットプリントを3.6倍削減し、最大8.7倍高速化した4ビット量子化拡散モデル推論をサポート。

- FLUX.1-dev、FLUX.1-schnell、FLUX.1-toolsを含むFLUX.1ファミリーに対応。

- テキストから画像へ、スケッチから画像へ、深度マップ/エッジマップから画像へ、画像復元など、さまざまな生成タスクを提供。

- LoRAロードがサポートされ、ユーザーはカスタムモデルをロードして生成を強化できる。

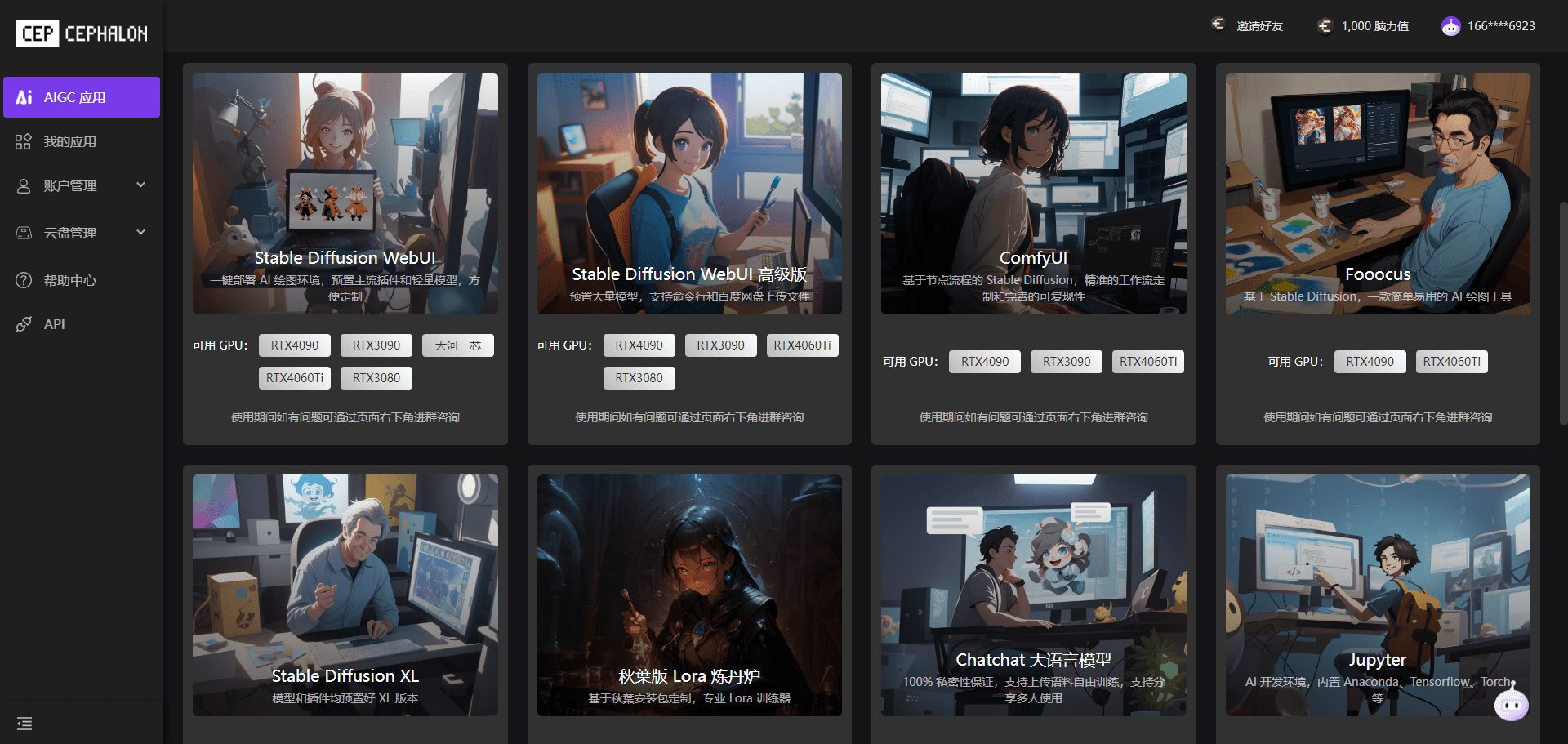

- ComfyUIとの統合により、ワークフロー設定を簡素化するノードベースのオペレータインターフェイスを提供します。

- FLUX.1-Kontext-devによる自然言語による画像編集とテキストによる画像変更をサポート。

- FP16の精度をサポートし、モデルの性能と生成品質を最適化します。

- PuLID v0.9.1との統合により、カスタムモデルパスとタイムステップ制御をサポート。

ヘルプの使用

設置プロセス

Nunchakuのインストールには、お使いのシステムがPyTorch、CUDA、特定のコンパイラを含む基本的な要件を満たしていることを確認する必要があります。以下は、LinuxとWindowsの両方のシステムに対する詳細なインストール手順です。

環境準備

- PyTorchのインストールPyTorch 2.6以降がインストールされていることを確認してください。例えば、以下のコマンドでPyTorch 2.6をインストールします:

pip install torch==2.6 torchvision==0.21 torchaudio==2.6Blackwell GPU(RTX 50シリーズなど)を使用する場合は、PyTorch 2.7とCUDA 12.8以降が必要です。

- CUDAバージョンの確認LinuxはCUDA 12.2以上、WindowsはCUDA 12.6以上が必要です。

- コンパイラのインストール::

- Linux: インストールの確認

gcc/g++11以上、Conda経由でインストール:conda install -c conda-forge gcc gxx - Windows:最新バージョンのVisual Studioをインストールし、C++開発コンポーネントが含まれていることを確認してください。

- Linux: インストールの確認

- 依存関係のインストール必要なPythonパッケージをインストールします:

pip install ninja wheel diffusers transformers accelerate sentencepiece protobuf huggingface_hubGradioのデモを実行する必要がある場合は、追加でインストールしてください:

pip install peft opencv-python gradio spaces

ヌンチャクを取り付ける

- ハギング・フェイスからのインスタレーションPythonとPyTorchのバージョンに適したホイールファイルを選択してください。例えば、Python 3.11とPyTorch 2.6です:

pip install https://huggingface.co/mit-han-lab/nunchaku/resolve/main/nunchaku-0.2.0+torch2.6-cp311-cp311-linux_x86_64.whlWindowsユーザー向け:

pip install https://huggingface.co/mit-han-lab/nunchaku/resolve/main/nunchaku-0.1.4+torch2.6-cp312-cp312-win_amd64.whl - ソースからのインストール(オプション):

git clone https://github.com/mit-han-lab/nunchaku.git cd nunchaku git submodule init git submodule update export NUNCHAKU_INSTALL_MODE=ALL python setup.py develop注:設定

NUNCHAKU_INSTALL_MODE=ALL生成されたホイールファイルが異なるGPUアーキテクチャと互換性があることを確認してください。

ComfyUIの統合

- ComfyUIのインストールComfyUIがまだインストールされていない場合は、以下のコマンドでインストールできます:

git clone https://github.com/comfyanonymous/ComfyUI.git cd ComfyUI pip install -r requirements.txt - ComfyUIヌンチャクプラグインのインストール::

pip install comfy-cli comfy install comfy node registry-install ComfyUI-nunchakuまたは、ComfyUIのカスタムノードマネージャーから検索してインストールしてください。

ComfyUI-nunchaku. - ダウンロードモデル必要なモデルファイルを指定したディレクトリにダウンロードします。例

huggingface-cli download comfyanonymous/flux_text_encoders clip_l.safetensors --local-dir models/text_encoders huggingface-cli download comfyanonymous/flux_text_encoders t5xxl_fp16.safetensors --local-dir models/text_encoders huggingface-cli download black-forest-labs/FLUX.1-schnell ae.safetensors --local-dir models/vae - ワークフローの複製サンプルワークフローをComfyUIディレクトリにコピーします:

mkdir -p user/default/example_workflows cp custom_nodes/nunchaku_nodes/example_workflows/* user/default/example_workflows/ - ComfyUIの実行::

cd ComfyUI python main.py

主な機能

ヌンチャクには様々な画像生成・編集機能があり、以下に説明する。

テキストから画像への変換

- ComfyUIを開き、ヌンチャクワークフローを読み込みます。

nunchaku-flux.1-dev-pulid.json). - ワークフローで選択

Nunchaku Text Encoder Loader設定use_4bit_t5=True4ビット量子化T5テキストエンコーダを使用することでメモリを節約する。 - はっきり確実に示す

t5_min_length=512画質を向上させる。 - テキストプロンプト(例えば「夕暮れの未来都市」)を入力し、生成パラメータ(例えばサンプリング・ステップ数、ブートストラップ・スケール)を調整する。

- ワークフローを実行して画像を生成する。

画像編集(FLUX.1-Kontext-dev)

- FLUX.1-Kontext-devモデルを読み込み、自然言語による画像編集を可能にする。

- 編集したい画像をアップロードし、「空に明るい月を追加する」などの編集コマンドを入力する。

- アダプト

start_timestep歌で応えるend_timestep編集の強さと範囲をコントロールするパラメータ。 - Generateを実行すると、編集した画像が表示されます。

スケッチから画像へ

- ComfyUIで

Sketch-to-Imageワークフロー。 - スケッチ画像をアップロードし、生成パラメータを設定します。

- ワークフローを実行し、スケッチベースの画像を生成します。

LoRAローディング

- カスタムLoRAモデルをダウンロードまたはトレーニングし、それを

models/loraカタログ - ComfyUIのワークフローに

LoRA LoaderLoRA モデルのパスを指定するノード。 - ワークフローを実行し、LoRAの強化された生成効果を適用する。

ほら

- GPUアーキテクチャの互換性を確保(Turing、Ampere、Ada、A100などをサポート)。

- 特にComfyUI Portableでは、ログ出力をチェックしてPythonの実行パスを確認してください。

- インストールに問題が発生した場合は、公式ドキュメントを参照してください。

docs/setup_windows.mdあるいはチュートリアルビデオ。

アプリケーションシナリオ

- AIによる芸術的創造

アーティストがヌンチャクを使って高品質のアートイメージを生成します。ユーザーはテキストを入力したり、スケッチをアップロードすることで、コンセプトデザインや芸術的探求に適した創造的な画像を素早く生成することができます。 - 研究開発

研究者たちは、Nunchakuを使用して、低リソースデバイス上で4ビット量子化モデルをテストした。低いメモリフットプリントと高い推論速度は、学術的な実験やモデルの最適化に適しています。 - 画像編集と修復

写真家やデザイナーは、傷の修正や要素の追加など、自然言語コマンドで画像を編集することで、後処理プロセスを合理化します。 - 教育と学習

ComfyUIのノードベースのインターフェイスは、直感的で分かりやすく、教育や練習に最適です。

品質保証

- ヌンチャクはどのGPUをサポートしていますか?

Nunchakuは、Turing(RTX 2080)、Ampere(RTX 3090、A6000)、Ada(RTX 4090)、A100アーキテクチャを含むNVIDIA GPUをサポートしています。 Blackwell GPUには、CUDA 12.8とPyTorch 2.7が必要です。 - Windowsへのインストール方法は?

Visual StudioとCUDA 12.6以上をインストールするか、Hugging FaceのWindowsホイールファイルを使用して直接インストールするか、または以下を参照してください。docs/setup_windows.md. - 4ビット量子化は画質に影響するか?

SVDQuantテクノロジーは、低ランク成分によって外れ値を吸収することで、視覚的な忠実度を維持します。FLUX.1-devでは、4ビット量子化の画質は16ビットモデルの画質に近づいた。 - ComfyUIのインストールの失敗を解決するには?

Pythonの環境がComfyUIと一致していることを確認し、ログのPython実行ファイルへのパスを確認してください。ログ中のPython実行ファイルへのパスはcomfy-cliまたは手動インストールComfyUI-nunchaku.

応用例

nunchaku-flux.1-kontext-dev AI Raw Graphics One-Click Integration Pack Minimum 4G Graphics Card Runs 30 Seconds to Graphics v20250630

FLUX.1-コンテキスト-dev統合パック