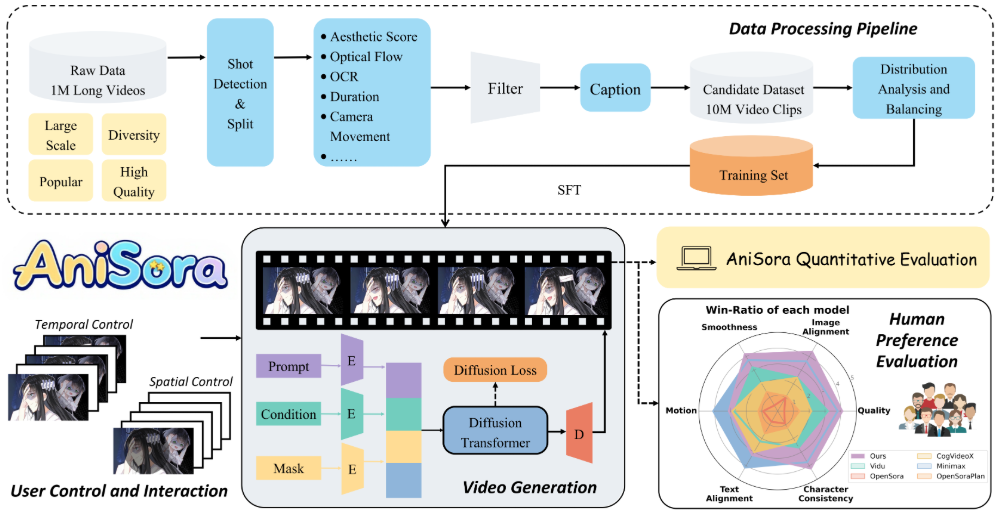

Index-AniSoraは、Bilibiliによって開発され、オープンソース化され、GitHubでホストされているアニメ動画生成モデルです。CogVideoX-5BとWan2.1-14Bをベースモデルとしており、アニメ本編、国内オリジナルアニメ、漫画原作、VTuberコンテンツ、アニメPV、なりきり動画など、多様なアニメスタイルの動画生成に対応している。このプロジェクトは、IJCAI'25で採択された論文の成果を統合し、完全な学習と推論コードを提供し、ファーウェイのRise 910B NPUハードウェアをサポートする。Index-AniSoraは、数千万の超高品質データセットと時空間マスクモジュールにより、画像から動画への生成、フレーム補間、ローカルガイドアニメーションを実装する。評価用データセットには948のアニメーションビデオクリップが含まれ、Qwen-VL2が生成したテキストキューと組み合わせることで、ビデオコンテンツとテキストの正確な位置合わせを実現している。このプロジェクトは、Apache 2.0ライセンスの完全なオープンソースであり、コミュニティによる開発への参加が奨励されている。

機能一覧

- アニメのエピソード、漫画の映画化、VTuberのコンテンツなど、多様なアニメスタイルの動画生成をサポートする。

- 1枚の画像からダイナミックビデオを生成する画像-ビデオ生成機能を提供。

- アニメーションの滑らかさを最適化するために、キーフレーム、ミドルフレーム、エンドフレームを生成するフレーム補間をサポート。

- 局所的な画像誘導アニメーション機能を提供し、ユーザーが指定した領域をアニメーション化できます。

- 948のアニメーションビデオクリップと手動で修正されたテキストプロンプトを含む評価データセット。

- ファーウェイのRise 910B NPUをサポートし、トレーニングと推論のパフォーマンスを最適化。

- 強化学習最適化フレームワーク(RLHF)を提供し、アニメスタイルの出力品質を向上させる。

- 完全なトレーニングコードと推論コードをパスで公開する。

anisoraV1_train_npu歌で応えるanisoraV2_npu. - 計算コストを削減し、生成品質を維持するための蒸留加速推論技術を提供します。

ヘルプの使用

設置プロセス

Index-AniSoraはGitHubでホストされているオープンソースプロジェクトであり、ユーザーはリポジトリをクローンし、その機能を使用するための環境を設定する必要があります。以下は詳細なインストールと使用手順です:

- クローン倉庫

ターミナルで以下のコマンドを実行し、Index-AniSoraリポジトリをクローンする:git clone https://github.com/bilibili/Index-anisora.git cd Index-anisora

- 環境設定

このプロジェクトはPython環境と特定の深層学習フレームワークに依存している。Python 3.8以上を推奨する。依存関係をインストールします:pip install -r requirements.txtPyTorch(RiseのNPUまたはGPUをサポート)、CogVideoX、Wan2.1の依存関係がインストールされていることを確認してください。HuaweiのRise 910B NPUを使用している場合は、Rise開発キット(CANNなど)をインストールする必要があります。具体的なインストール手順については、公式ドキュメントまたはHuawei Riseコミュニティを参照してください。

- モデルウェイトのダウンロード

AniSoraV1またはAniSoraV2モデルウエイトの申し込みが必要。公式の申込書(PDF形式)に必要事項を記入し、以下のメールアドレスに送信してください。yangsiqian@bilibili.comもしかしたらxubaohan@bilibili.com.レビュー後、weightsのダウンロードリンクを取得します。ダウンロードが完了したら、リポジトリの指定されたディレクトリにweightsファイルを置きます。anisoraV2_npu). - 推論コードを実行する

このプロジェクトでは、推論コード一式を提供している。anisoraV1_train_npuもしかしたらanisoraV2_npuディレクトリサンプルの推論コマンドを実行する:python inference.py --model_path anisoraV2_npu --prompt "一个穿和服的少女在樱花树下跳舞" --output output_video.mp4パラメータの説明

--model_pathモデルのウェイトパスを指定します。--promptアニメーションのシーンを説明するテキストプロンプトを入力します。--output出力ビデオファイルのパスを指定します。

- トレーニングモデル

カスタムトレーニングが必要な場合、プロジェクトはトレーニングコード(anisoraV1_train_npu).データセットを準備したら、トレーニング・スクリプトを実行する:python train.py --data_path your_dataset --output_dir trained_modelデータセットはプロジェクトの要件を満たす必要があり、テキストプロンプト付きの評価データセットと同様のアニメーションビデオクリップを使用することが推奨される。トレーニングはHuawei Rise NPUとGPUをサポートする。

主な機能

- 画像からビデオへの変換

ユーザーは静止画像(例えばアニメキャラクターの絵)をアップロードし、テキストでプロンプトを出すと、アニメーション動画を生成する。例えば、画像を「忍者キャラクター」、プロンプトを「忍者が森で戦う」と入力すると、モデルが対応するアニメーションを生成します。ステップ- 画像ファイル(PNG/JPG形式など)を用意する。

- アクション、シーン、スタイルを説明する詳細なテキストプロンプトを書く。

- 画像パスとプロンプトを指定する推論スクリプトを実行する:

python inference.py --image_path input_image.png --prompt "忍者在森林中战斗" --output ninja_video.mp4 - 生成されたビデオファイルをチェックし、キューを調整して結果を最適化する。

- フレーム補間

フレーム補間機能は、動画の滑らかさを向上させるために、アニメーションの中間フレームを生成するために使用されます。ユーザーはキーフレーム(例えば、開始フレームと終了フレーム)を提供することができ、モデルは自動的に中間遷移フレームを生成します。操作ステップ- 指定したディレクトリに配置するキーフレームイメージを準備する。

- フレーム補間スクリプトを実行する:

python frame_interpolation.py --keyframe_dir keyframes --output interpolated_video.mp4 - 出力ビデオをチェックし、フレーム間の自然なトランジションを確認する。

- ローカル・イメージ・ガイド・アニメーション

ユーザーは、画像の特定の領域を指定してアニメーションを生成することができます。例えば、背景を固定し、キャラクターだけを動かすことができます。アクションステップ- 画像ファイルとマスクファイルを提供する(マスクはアニメーション領域を指定する)。

- ローカルブートスクリプトを実行する:

python local_guided_animation.py --image_path scene.png --mask_path mask.png --prompt "角色在背景前挥手" --output guided_video.mp4 - アニメーションの領域が期待通りであることを出力で確認する。

- データセットの使用を評価する

このプロジェクトでは、モデルのパフォーマンスをテストするために、948のアニメーションビデオクリップからなる評価データセットを提供しています。ユーザはデータセットへのアクセスを申請する必要がある(モデルウェイトの申請プロセスと同じ)。取得後、評価スクリプトを実行することができます:python evaluate.py --dataset_path anisora_benchmark --model_path anisoraV2_npu評価結果には、動きの一貫性やスタイルの一貫性など、モデルの最適化に適用可能な指標が含まれている。

注目の機能操作

- 最適化のための強化学習(RLHF)

AniSoraV1.0は、アニメビデオ生成のための最初のRLHFフレームワークを導入し、生成品質を向上させます。ユーザーは提供されるRL最適化スクリプトでモデルを微調整することができます:python rlhf_optimize.py --model_path anisoraV1_npu --data_path rlhf_data --output optimized_modelRLHFのデータは各自で用意し、質の高いアニメ映像や評価を含めることを推奨する。

- ファーウェイ製ライズNPUサポート

このプロジェクトは、国内ユーザー向けにHuawei社のRise 910B NPUに最適化されています。Rise Development Kitをインストール後、推論やトレーニングを実行する際は、必ずNPUデバイスを指定してください:python inference.py --device npu --model_path anisoraV2_npu

アプリケーションシナリオ

- 短編アニメーション制作

Index-AniSoraを使えば、クリエイターがハイクオリティなアニメーションクリップを生成することができます。例えば、キャラクターデザインと「近未来都市を走るキャラクター」という説明文を入力すると、自主制作アニメに適したショートアニメが生成されます。 - VTuberコンテンツ制作

VTuberのキャスターは、このモデルを使って、「ステージでパフォーマンスするバーチャル・アイドル」のようなアバターのアニメーション動画を生成し、ライブや短い動画コンテンツを素早く作成することができる。 - コミック映画化プレビュー

漫画家は、静止したコミックフレームをモーションビデオに変換し、適応されたアニメーションの効果をプレビューし、絵コンテの滑らかさを検証することができます。 - 教育・研究

研究者は、評価データセットとトレーニングコードを使用して、アニメビデオ生成技術を探求し、モデルを最適化し、新しいアルゴリズムを開発することができます。

品質保証

- モデルの重みとデータセットはどのように入手できますか?

申込書(PDF形式)に必要事項を記入の上、下記までお送りください。yangsiqian@bilibili.comもしかしたらxubaohan@bilibili.com.レビュー後にダウンロードリンクを取得する。 - シンギュラリティ以外のハードウェアをサポートしていますか?

はい、このプロジェクトはGPU環境をサポートしていますが、Rise NPUのパフォーマンスの方が優れています。互換性のあるバージョンのPyTorchをインストールしてください。 - 生成されたビデオの品質は?

このモデルはCogVideoXとWan2.1に基づいて学習され、RLHF最適化と組み合わせることで、生成された映像は動きとスタイルの一貫性の点で高度なレベルに達し、幅広いアニメシーンに適している。 - プログラミングの経験は必要ですか?

スクリプトを実行するには、基本的なPythonの知識が必要です。開発者でない方は、事前に訓練されたモデルを使用してビデオを生成するためのドキュメントを参照することができます。