バイドゥは6月30日、同社の最新作を正式にオープンソース化したと発表した。 ERNIE 4.5 大規模マルチモーダルモデルのファミリー。MoE(ミックスド・エキスパート)アーキテクチャを全面的に採用し、モデルから開発キット、配備ツールまで、フルスタックのソリューションを提供します。 Apache 2.0 ライセンスの下で公開。

テクノロジー・コア:マルチモダリティ向けに設計されたヘテロジニアスMoEアーキテクチャ

業界で一般的なMoEモデルとは異なりERNIE 4.5 MoEの特徴の一つは、革新的な「マルチモーダルヘテロジニアスMoE」事前学習アプローチである。このアーキテクチャは、特定のモダリティ専用の独立したパラメータを保持しながら、テキストや画像などのマルチモーダル情報を処理する際に、モデルが共通のパラメータを共有できるように設計されている。

この目標を達成するために、研究開発チームは、モダリティ分離ルーティング、ルータ直交損失、マルチモーダルトークンバランス損失を含む様々な技術を設計した。これらの設計の核となる考え方は、テキストとビジュアルの両方のモダリティの学習が、共同学習中に互いに干渉することなく、互いを促進できるようにすることである。

モデル・アーキテクチャに加えて、Baiduはトレーニングおよび推論インフラにおける効率最適化も強調した。ノード内エキスパート並列、メモリ効率の高いパイプラインスケジューリング、FP8混合精度トレーニング、きめ細かな再計算などの技術により、最大の言語モデルの事前トレーニングでは、47%のモデルFLOPs利用率(MFU)を達成した。推論側ではERNIE 4.5 4ビット/2ビットの低ビット量子化を達成するために、マルチエキスパート並列コラボレーションや畳み込み符号化量子化などのアルゴリズムが使用された。

パフォーマンス:業界トップモデルとの多次元比較

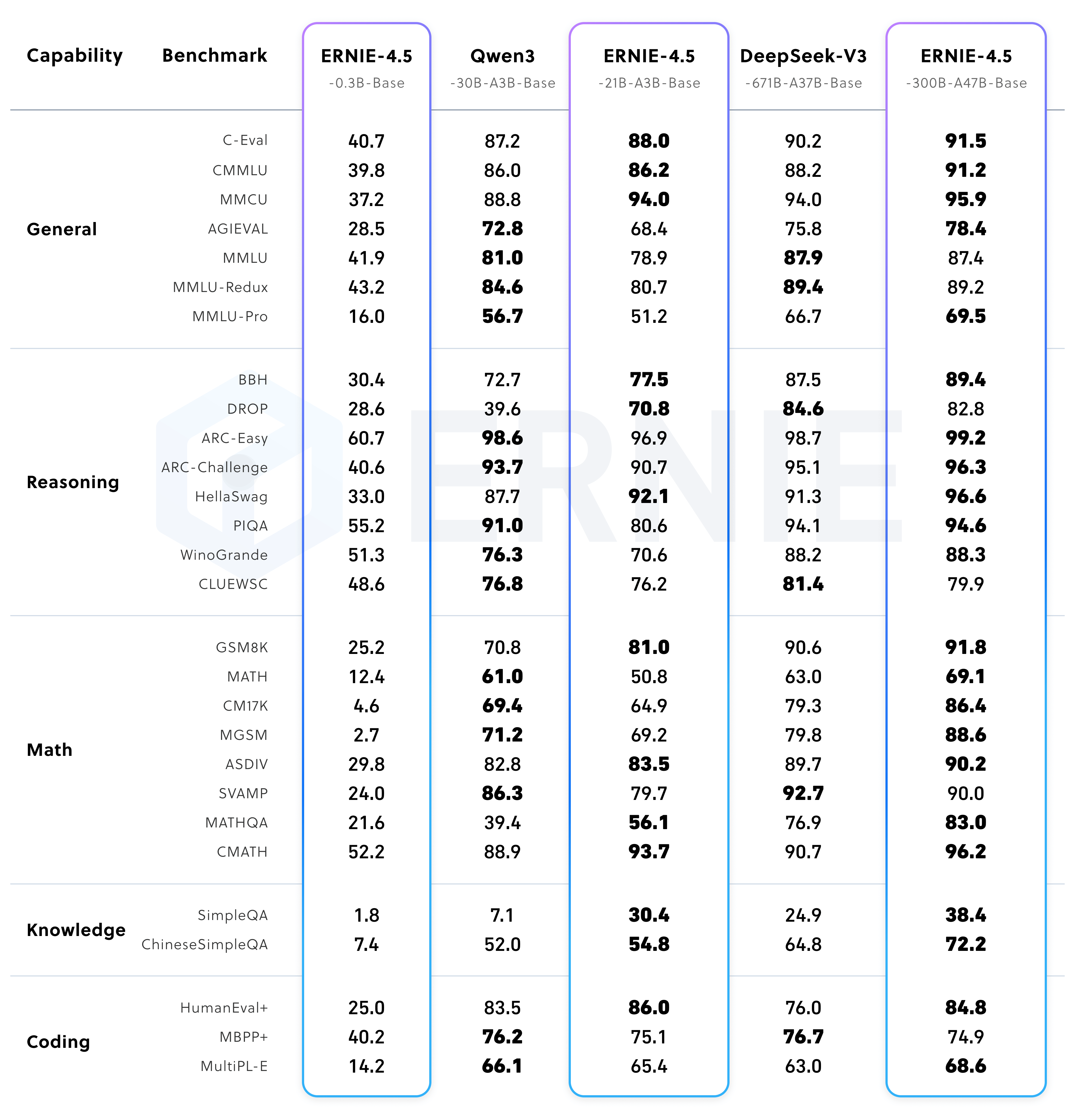

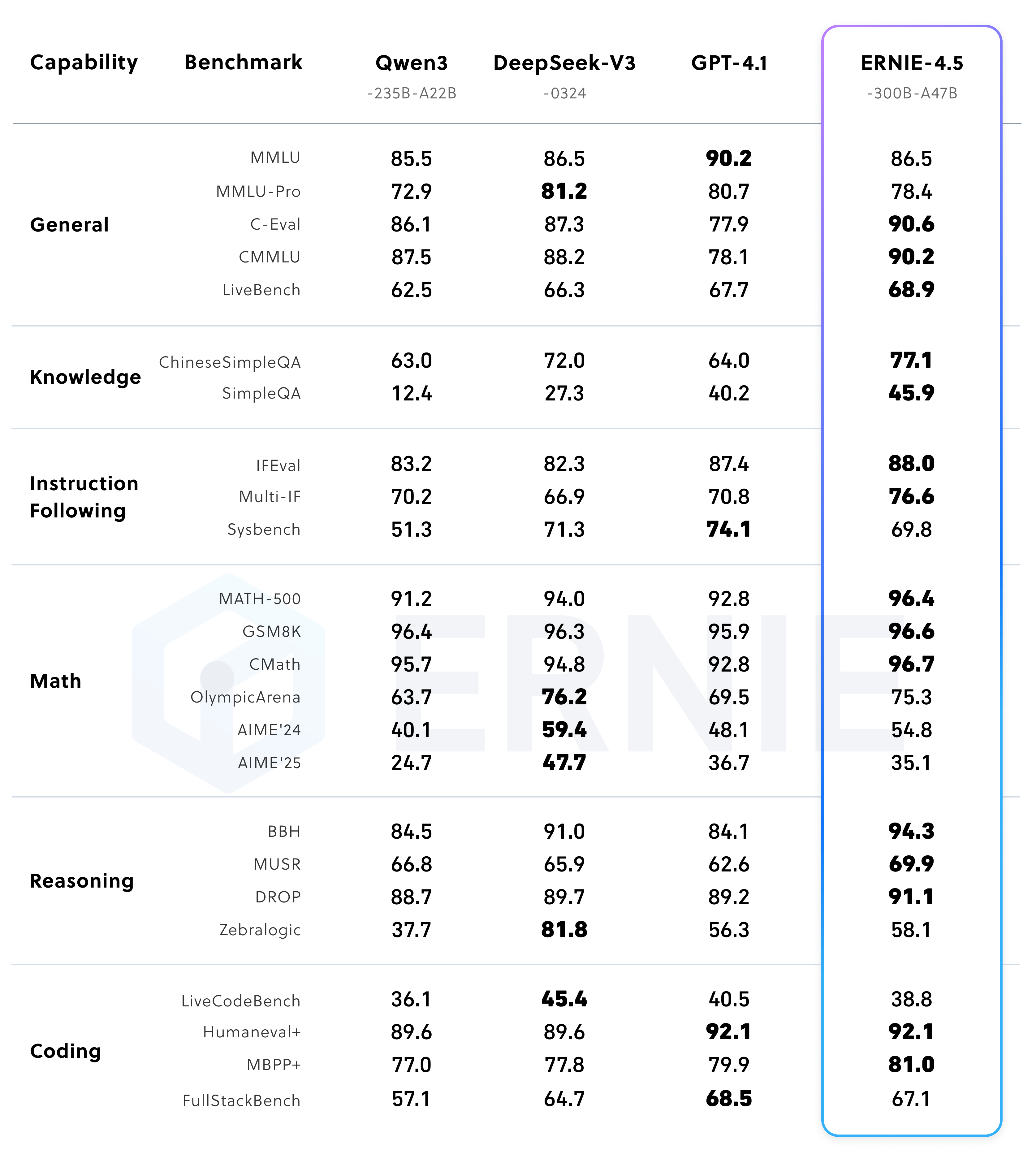

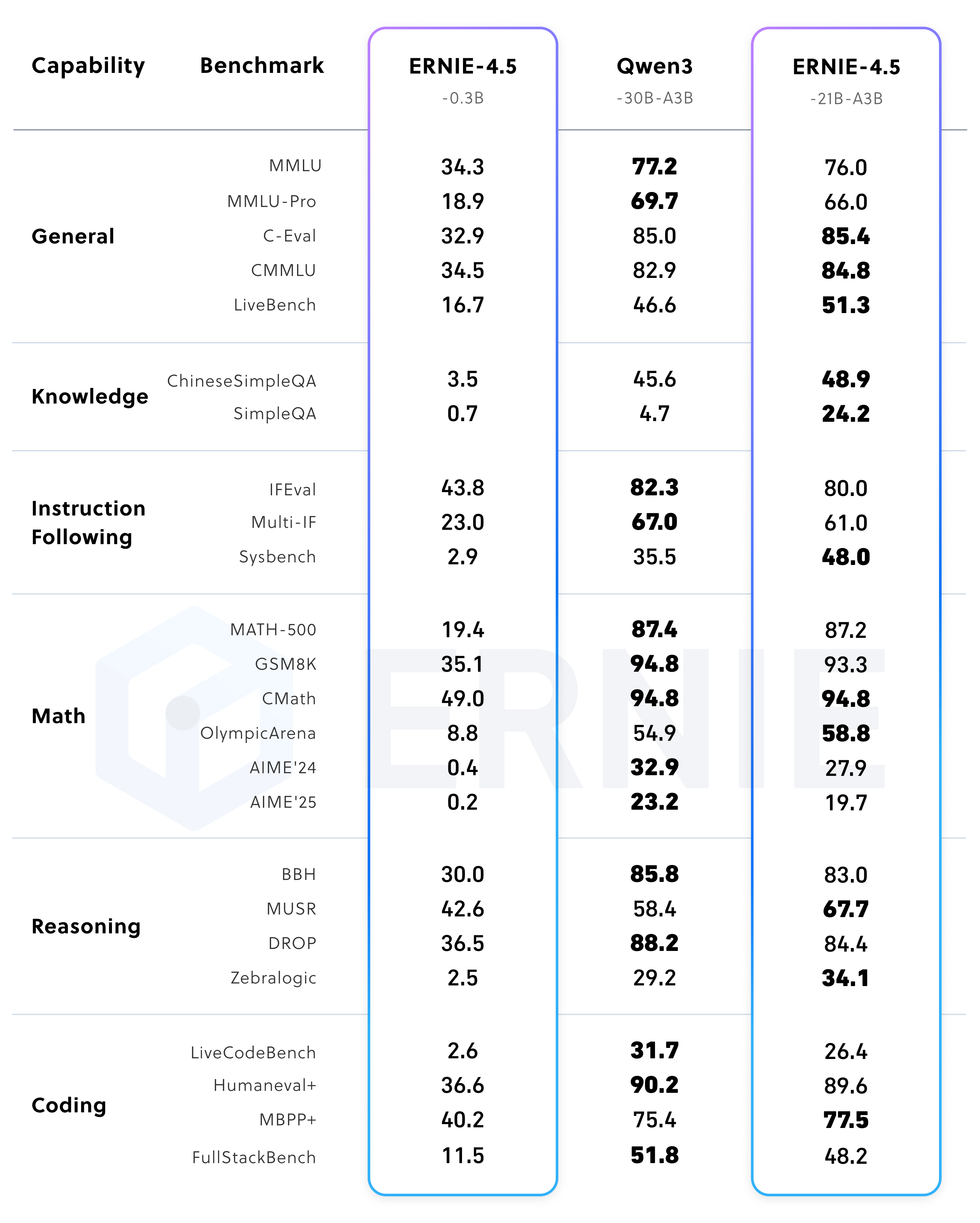

百度が発表したベンチマーク結果によるとERNIE 4.5 さまざまな面で強い競争力を持つ。

訓練済みベースモデルのパフォーマンス

ERNIE-4.5-300B-A47B-Base モデルは、28のベンチマークのうち22のベンチマークで優れている。 DeepSeek-V3-671B-A37B-Base.これは、このモデルが汎化可能性、推論、知識集約的タスクの最先端にあることを示している。

コマンド微調整後のモデル性能

コマンドの微調整の後 ERNIE-4.5-300B-A47B このモデルは、Instruction Followed (IFEval)やKnowledge Quiz (SimpleQA)などのタスクでトップスコアを獲得した。

同時に、以下のパラメータサイズが小さくなっている。 ERNIE-4.5-21B-A3B このモデルは、上院議員の総数が約1,000人である。 Qwen3-30B の70%を上回るが、BBHやCMATHのような数学・推論ベンチマークでは後者を上回り、高いパラメータ効率を示す。

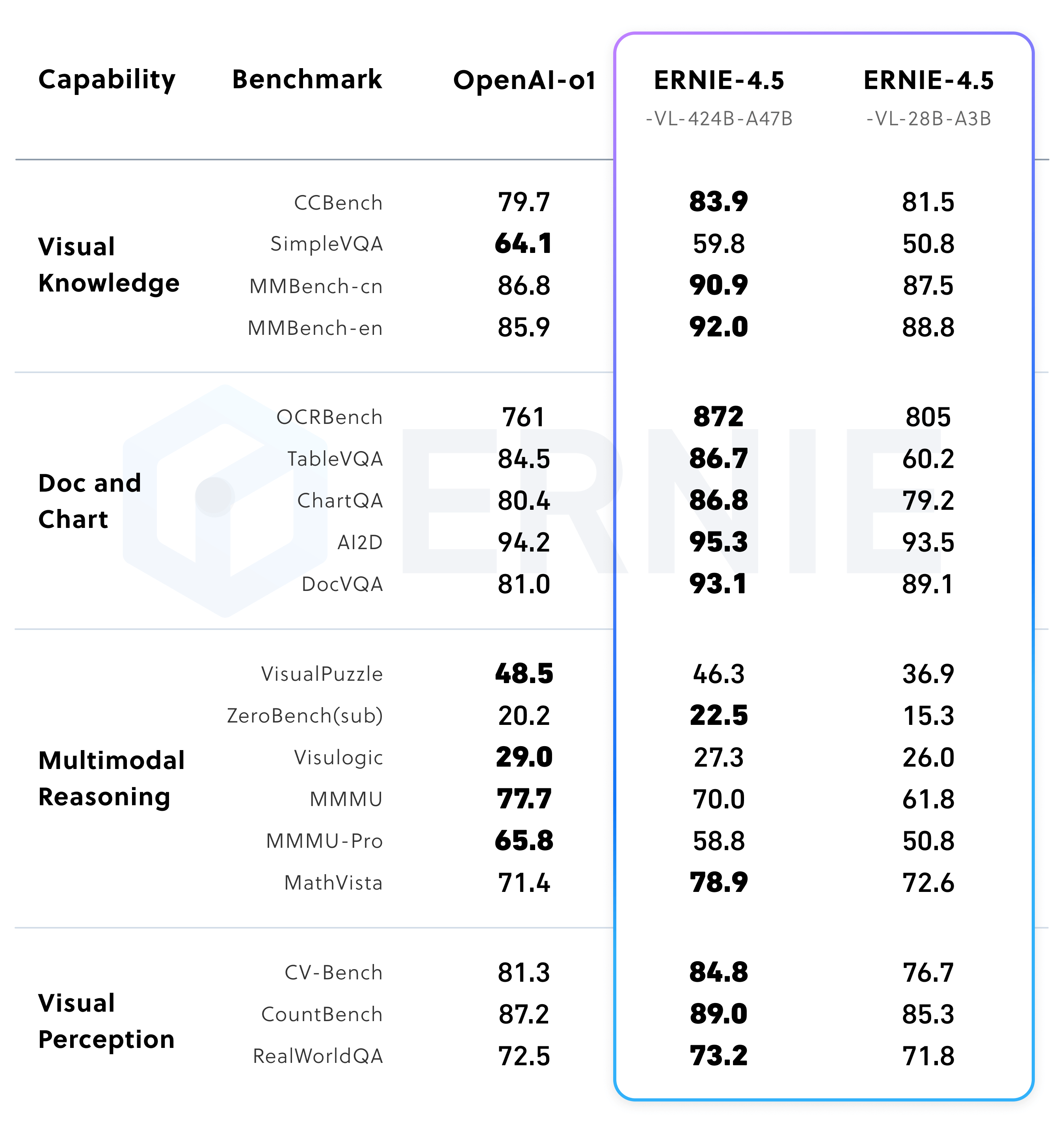

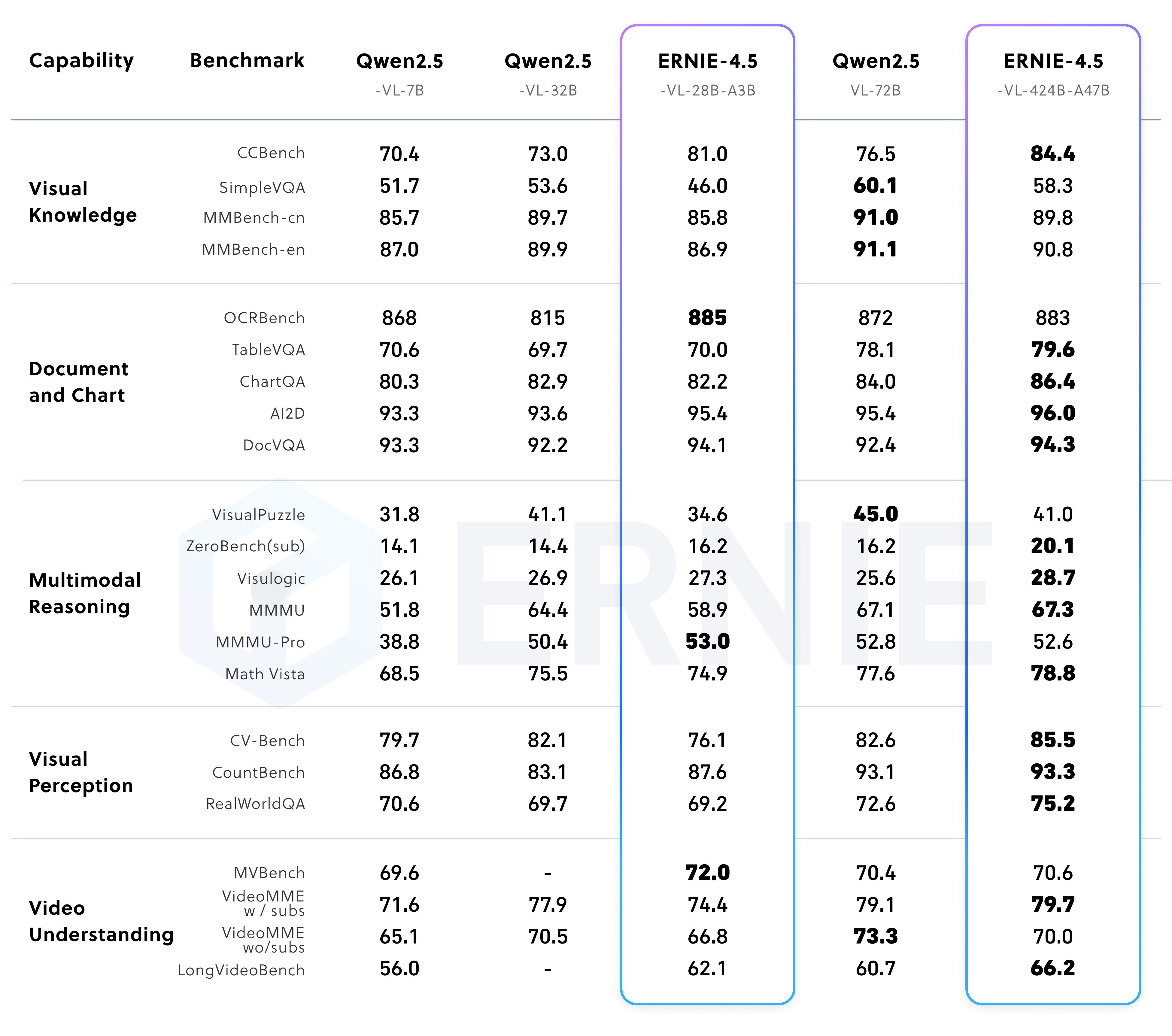

マルチモーダルモデルの性能

ERNIE 4.5 視覚言語モデル(VLM)は、「思考モード」と「非思考モード」の両方をサポートしている。

非思考モードでは、このモデルは効率的な視覚的知覚、文書や図表の理解に重点を置いている。一方、思考モードでは、このモデルは強力な知覚能力を維持しながら、以下の能力を大幅に強化する。 MathVistaそしてMMMU 以下のような複雑なベンチマークに関する推論能力ERNIE-4.5-VL の軽量版である。 Qwen2.5-VL-32B.

エコロジーとツールチェーン:ERNIEKit 歌で応える FastDeploy

ERNIE 4.5 モデル・ファミリーは、以下に基づいている。 PaddlePaddle ディープ・ラーニング・フレームワークのトレーニング PyTorch 対応バージョン。バイドゥは、開発者の利用障壁を下げることを目的とした2つのコアツールをリリースした。

- ERNIEKit:モデルの微調整とアライメント

ERNIEKitは、スーパーバイズド・ファインチューニング(SFT)、ダイレクト・プリファレンス・オプティマイゼーション(DPO)をサポートする産業グレードの開発ツールキットです。LoRA定量化されたトレーニング(QAT)、トレーニング後の定量化(PTQ)、その他様々な主流のトレーニングや圧縮技術。開発者は、コマンドラインツールを使用してモデルをダウンロードし、SFTまたはDPOタスクを実行できます。

# 下载模型 huggingface-cli download baidu/ERNIE-4.5-300B-A47B-Base-Paddle \ --local-dir baidu/ERNIE-4.5-300B-A47B-Base-Paddle # 监督微调 (SFT) erniekit train examples/configs/ERNIE-4.5-300B-A47B/sft/run_sft_wint8mix_lora_8k.yaml \ model_name_or_path=baidu/ERNIE-4.5-300B-A47B-Base-Paddle - FastDeploy: 効率的なモデル展開

FastDeployと互換性のあるAPIを持つ、大規模モデル用の効率的なデプロイメント・ツールキットである。vLLM歌で応えるOpenAIワンクリックでサービタイゼーションを展開できるプロトコル。このプロトコルはERNIE 4.5のMoEモデルは、低ビット量子化、コンテキスト・キャッシュ、投機的デコードなどの統合アクセラレーション技術を備えた、産業グレードのマルチコンピュータ展開ソリューションを提供する。ローカル推論のサンプルコードは以下の通り:

from fastdeploy import LLM, SamplingParams prompt = "Write me a poem about large language model." sampling_params = SamplingParams(temperature=0.8, top_p=0.95) llm = LLM(model="baidu/ERNIE-4.5-0.3B-Paddle", max_model_len=32768) outputs = llm.generate(prompt, sampling_params)一方、サービス・デプロイは1行のコマンドで開始できる:

python -m fastdeploy.entrypoints.openai.api_server \ --model "baidu/ERNIE-4.5-0.3B-Paddle" \ --max-model-len 32768 \ --port 9904

オープンソースのライセンスと引用

ERNIE 4.5 モデルは以下の通り。 Apache License 2.0 契約では、ライセンスは商業利用を許可している。

研究に引用するには、以下を使用する。 BibTeX フォーマット

@misc{ernie2025technicalreport,

title={ERNIE 4.5 Technical Report},

author={Baidu ERNIE Team},

year={2025},

eprint={},

archivePrefix={arXiv},

primaryClass={cs.CL},

url={}

}