Meta AI 于 6 月 11 日发布了其最新的世界模型 V-JEPA 2 (Video Joint Embedding Predictive Architecture 2)。该模型在物理世界的视觉理解和预测方面取得了当前最先进的性能,并能用于机器人“零样本”(zero-shot)规划,使其在陌生环境中与未知物体进行交互。

与模型一同发布的还有三个全新的基准测试,旨在更准确地评估现有模型对物理世界的推理能力。此举不仅是 Meta 在实现高级机器智能 (AMI) 道路上的又一步,也为整个行业提供了衡量 AI 物理世界交互能力的新标尺。

什么是世界模型?

人类婴儿在学会说话之前,就已经通过观察建立了对世界的直觉。比如,向上抛一个网球,它会掉下来,而不会悬浮在空中或突然变成一个苹果。这种物理直觉就是内心世界模型的体现。

这个内部模型让我们能预测自己或他人行为的后果,从而提前规划。在拥挤的人群中穿行时,我们会下意识地预测路径以避免碰撞;准备晚餐时,我们会根据经验判断何时关火。

要构建能够在物理世界中“三思而后行”的 AI 代理,其世界模型必须具备三种核心能力:

- understandings:能够识别视频中的物体、动作和运动。

- anticipate:能够预见世界的演变,以及在特定行为干预下世界会发生怎样的变化。

- program:基于预测能力,规划出一系列能够达成目标的动作。

V-JEPA 2 模型详解

V-JEPA 2 是一个拥有 12 亿参数的模型,它基于 Meta 在 2022 年首次提出的 JEPA 架构(联合嵌入预测架构)构建。该模型主要通过对海量视频的自监督学习进行训练,这让它无需人工标注就能洞察世界的运作方式。

其核心包含两个组件:

- 编码器 (encoder):输入原始视频,输出能够捕捉世界状态关键语义信息的嵌入(embeddings)。

- 预测器 (predictor):接收视频嵌入和预测目标等上下文信息,输出对未来的预测嵌入。

V-JEPA 2 的训练分为两个阶段:

- 无动作预训练:模型首先在超过 100 万小时的视频和 100 万张图片上进行训练。这些数据教会了它关于物体如何移动、互动的基础知识。在此阶段后,模型已在动作识别(Something-Something v2)、动作预期(Epic-Kitchens-100)和视频问答(Perception Test, TempCompass)等任务上达到顶尖水平。

- 有动作条件训练:在第一阶段的基础上,模型使用包含机器人视觉和控制动作的数据进行训练。这一步让预测器学会将“特定动作”纳入考量。值得注意的是,这一阶段仅用了 62 小时的机器人数据,就使模型获得了有效的规划与控制能力。

在机器人规划任务中,V-JEPA 2 展现了出色的零样本能力。它在一个开源的 DROID 数据集上训练后,可以直接部署在 Meta 实验室的机器人上,无需针对新环境或新机器人进行任何微调。

对于抓取、放置等短时任务,只需给机器人一张目标状态的图片。机器人会利用 V-JEPA 2 预测器“想象”执行一系列候选动作的后果,并选择最接近目标的一步执行。通过模型预测控制(model-predictive control)的方式,机器人可以持续重新规划并执行动作。对于更复杂的长时任务,可以通过提供一系列视觉子目标来引导机器人。通过这种方式,V-JEPA 2 在新环境中处理未见过物体的拾取和放置任务,成功率达到了 65% – 80%。

V-JEPA 2 相关资源:

为物理理解能力设立新基准

与模型一同发布的三个新基准测试,其重要性不亚于模型本身。它们旨在解决当前评估体系的漏洞,推动社区构建真正理解物理世界的模型。虽然人类在这些测试中能达到 85% – 95% 的准确率,但包括 V-JEPA 2 在内的顶尖模型表现与人类仍有显著差距。

- IntPhys 2

该基准旨在衡量模型区分物理上“可能”与“不可能”场景的能力。它通过游戏引擎生成成对的视频,其中一个视频在某个节点会发生违反物理规律的事件。模型需要识别出哪个视频有问题。测试结果显示,当前视频模型在该任务上的表现接近随机猜测。IntPhys 2 资源:

- Minimal Video Pairs (MVPBench)

此基准通过多项选择题来评估视频语言模型的物理理解力。它的巧妙之处在于,每个样本都有一个“最小变化对”:一个视觉上极为相似但答案相反的视频。模型必须同时答对这两个问题才能得分,这有效遏制了模型通过肤浅的视觉或文本线索“抄近路”的问题。MVPBench 资源:

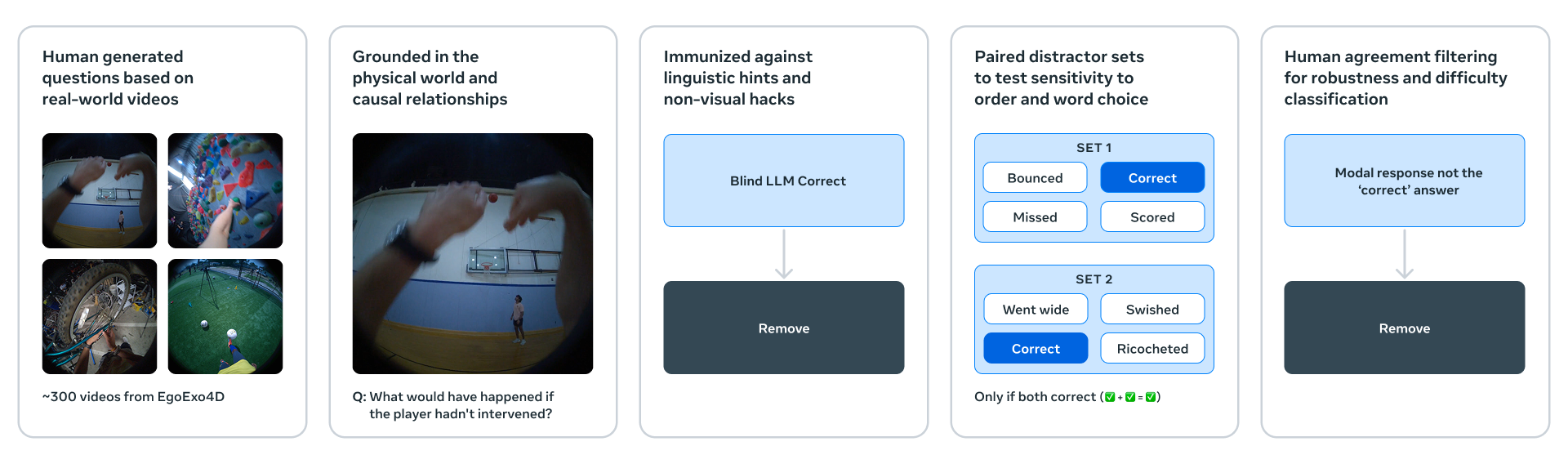

- CausalVQA

该基准专注于物理世界的因果关系理解。它向模型提出反事实(“如果……会发生什么?”)、预期(“接下来会发生什么?”)和规划(“为了实现目标,下一步该做什么?”)等问题。测试发现,尽管大型多模态模型能很好地回答“发生了什么”,但在回答“可能发生什么”或“本可能发生什么”这类问题时表现不佳。

CausalVQA 资源:

Meta 还在 Hugging Face 上发布了一个the charts (of best-sellers),用于追踪社区模型在这些新基准上的进展。

通往高级机器智能的下一步

V-JEPA 2 只是一个开始。目前,它在单一时间尺度上进行学习和预测。然而,像“把餐具放进洗碗机”或“烤一个蛋糕”这类任务,需要在不同时间尺度上进行分层规划。

因此,未来的研究重点将是分层 JEPA 模型,它能够跨越多个时空尺度进行学习、推理和规划。另一个重要方向是多模态 JEPA 模型,能够融合视觉、听觉、触觉等多种感官信息进行预测。这些探索将持续推动 AI 与物理世界的深度融合。