Von API-Aufrufen für große Sprachmodelle (Large Language Models, LLMs) bis hin zu autonomen, zielgerichteten agentengesteuerten Workflows vollzieht sich ein grundlegender Paradigmenwechsel bei KI-Anwendungen. Die Open-Source-Gemeinschaft hat bei dieser Welle eine Schlüsselrolle gespielt und eine Fülle von KI-Tools hervorgebracht, die sich auf spezifische Forschungsaufgaben konzentrieren. Bei diesen Tools handelt es sich nicht mehr um einzelne Modelle, sondern um komplexe Systeme, die Funktionen für Planung, Zusammenarbeit, Informationsbeschaffung und Toolaufrufe integrieren. In diesem Beitrag analysieren wir zehn repräsentative Open-Source-Forschungsassistenten, ihre Technologiepfade, Designphilosophien und strategische Positionierung im KI-Ökosystem.

Multi-Agenten-Systeme (MAS): Strukturierte Zusammenarbeit und dynamische Anpassung

Multiagentensysteme (MAS) lösen komplexe Probleme, die für eine einzelne Intelligenz nur schwer zu bewältigen sind, indem sie die Zusammenarbeit mehrerer unabhängiger Intelligenzen ermöglichen.DeerFlow und OWL zeigen die beiden vorherrschenden Implementierungswege in diesem Bereich: hierarchisch und dezentral.

DeerFlow stellt ein hierarchisches, strukturiertes Modell der Zusammenarbeit dar. Es gliedert das System in Koordinator, Planer und Expertenteams, was einer gut organisierten Unternehmensstruktur ähneln soll. Der Arbeitsablauf ist deterministisch: Der Planer zerlegt die Aufgaben, der Koordinator weist die Aufgaben zu, und die Expertenintelligenz führt sie aus. Der Vorteil dieses Modells besteht darin, dass es äußerst effizient und vorhersehbar ist, wenn es sich um klar abgegrenzte Aufgaben handelt, die effizient zerlegt werden können. Bei der Durchführung einer Sicherheitsüberprüfung einer umfangreichen Codebasis kann DeerFlow beispielsweise Aufgaben stabil an Intelligenzen mit unterschiedlichen Rollen zuweisen, wie Codeanalyse und Schwachstellenerkennung, und Berichte zusammenstellen.

Adresse des Projekts:https://github.com/bytedance/deer-flow

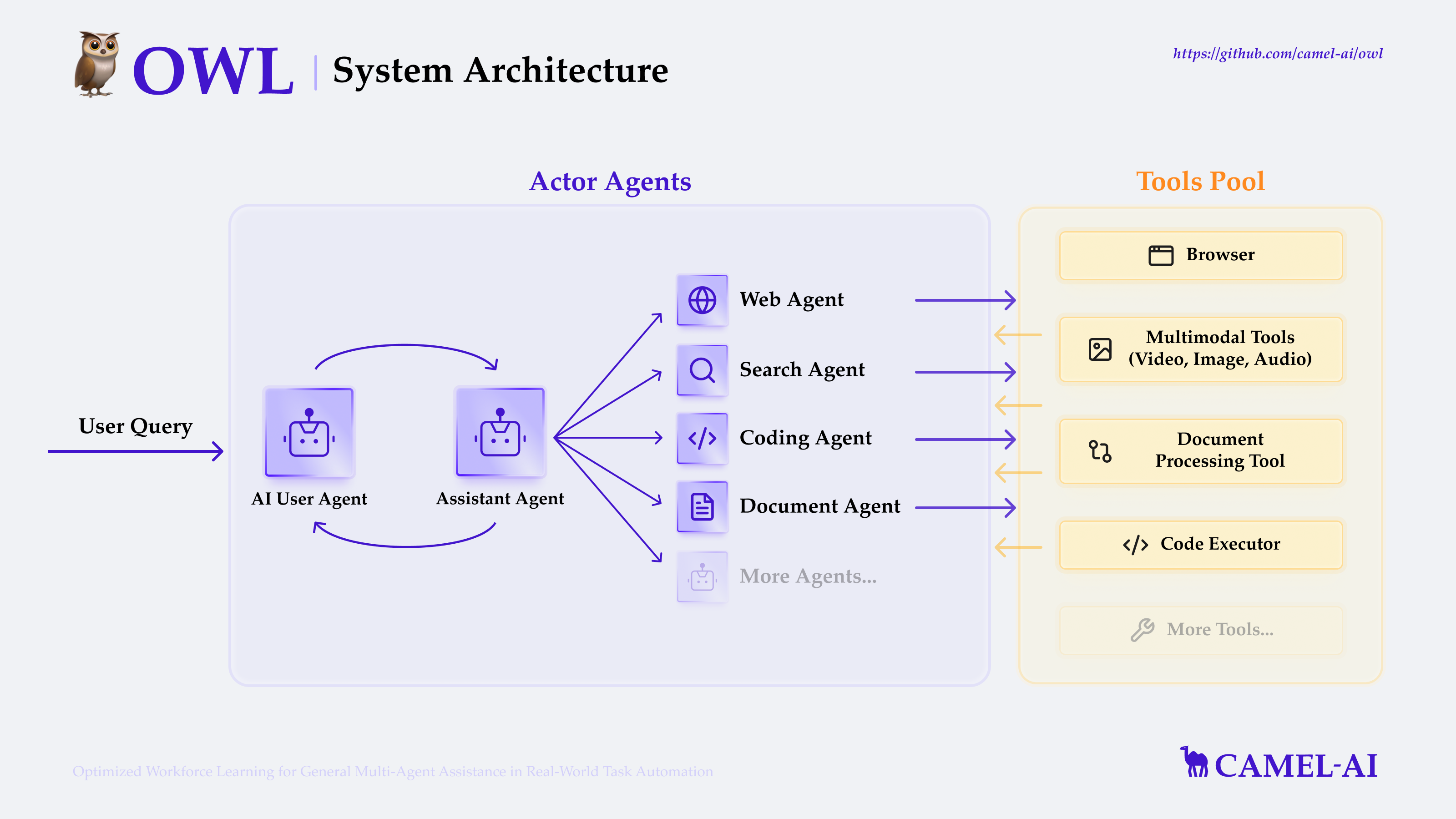

OWL verkörpert die Philosophie der dezentralen, dynamisch adaptiven Zusammenarbeit. Es basiert auf dem CAMEL-AI-Rahmenwerk, in dessen Mittelpunkt "Rollenspiel" und "Kommunikation und Verhandlung" zwischen den Intelligenzen stehen. Im Gegensatz zur vordefinierten Arbeitsteilung in DeerFlow können die Intelligenzen in OWL dynamisch verhandeln und je nach Fortschritt der Aufgaben in Echtzeit verschiedene Rollen übernehmen. Dieses emergente Kollaborationsmodell ist vorteilhaft, wenn es um offene, unstrukturierte Probleme geht (z.B. interdisziplinäre wissenschaftliche Exploration), da es dem System erlaubt, durch die Interaktion der Intelligenzen den besten Weg zur Zusammenarbeit selbst zu erforschen, ohne dass ein klarer Weg zur Lösung vorgegeben ist.Die Flexibilität von OWL geht auf Kosten eines Teils der Vorhersagbarkeit, die einen zentralen Kompromiss beim Entwurf multi-intelligenter Systeme darstellt.

Adresse des Projekts:https://github.com/camel-ai/owl

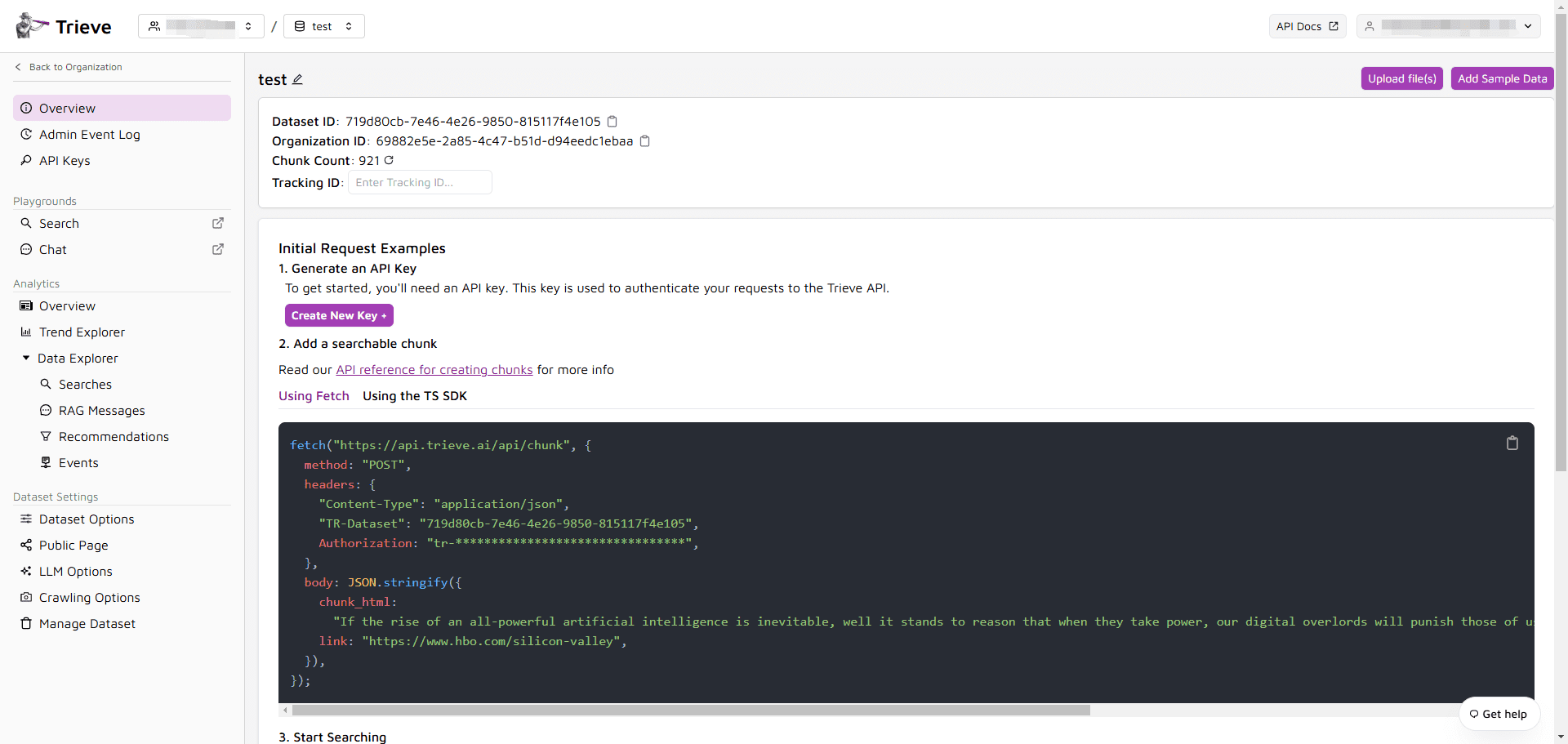

Advanced Retrieval Augmented Generation (Advanced RAG): vom Informationsabruf zur Wissenserschließung

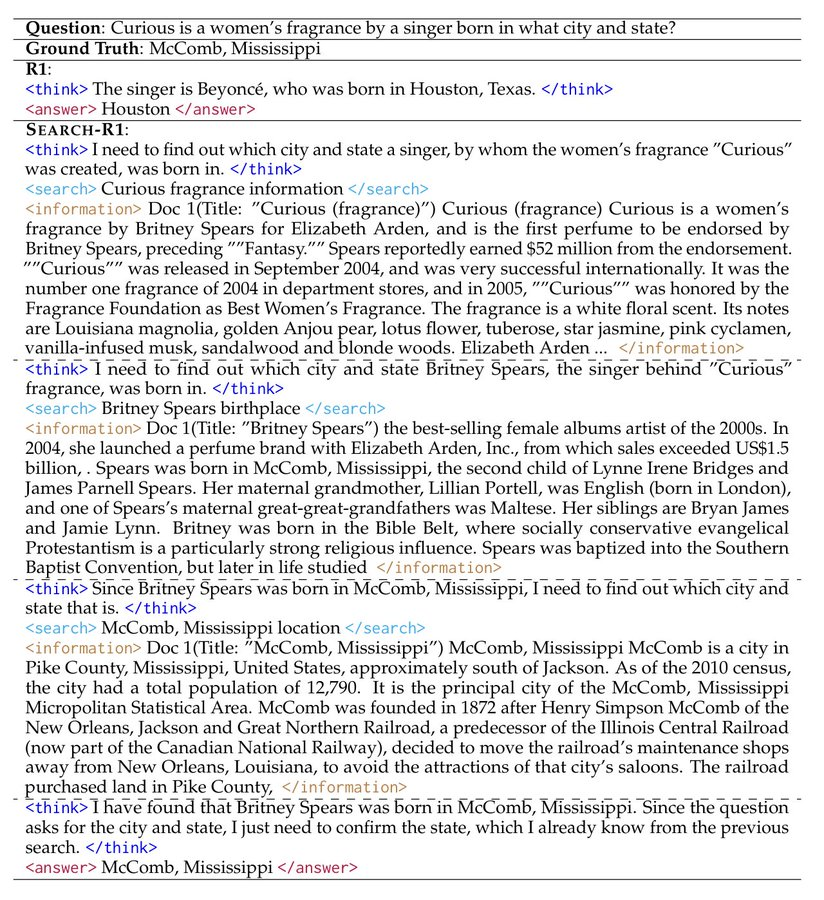

Retrieval-Augmented Generation (RAG) hat sich zu einer Standardtechnik entwickelt, um Modell-Illusionen abzuschwächen und Echtzeit-Informationen einzuführen. WebThinker und Search-R1 haben es von einem einfachen "Retrieval-Generierungs"-Modell zu einer fortgeschrittenen "Agenten-Erkundung" weiterentwickelt. WebThinker und Search-R1 haben es von einem einfachen "Retrieval-Generierungs"-Modell zu einer fortgeschrittenen "agentenbasierten Erkundung" weiterentwickelt.

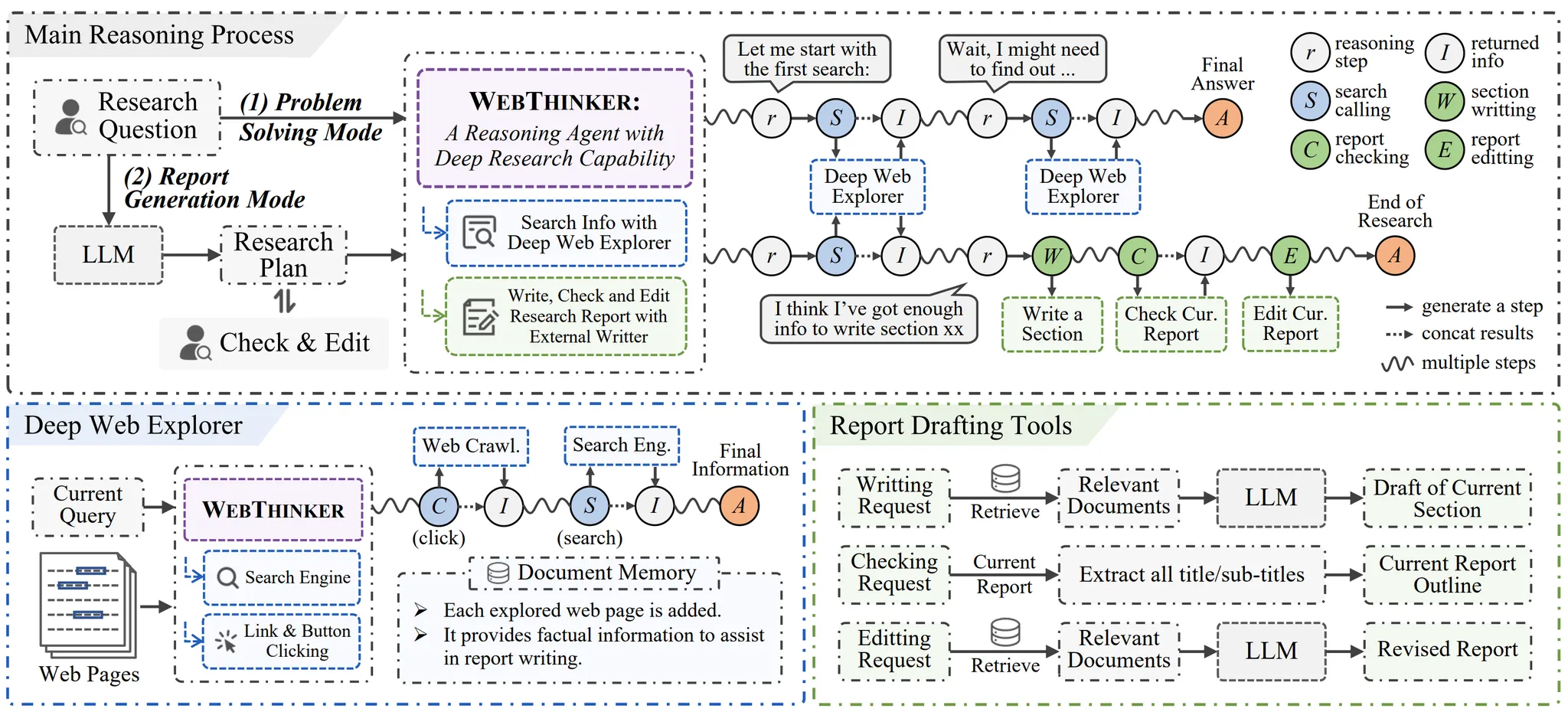

Der zentrale Durchbruch von WebThinker ist die Fähigkeit, LLM autonomes Browsing zu ermöglichen. Es geht über den Rahmen traditioneller RAG hinaus, die nur Textschnipsel aus Suchmaschinenergebnisseiten (SERPs) oder Vektordatenbanken extrahieren, und ist in der Lage, das Verhalten eines menschlichen Nutzers nachzuahmen, der auf einen Link klickt und tiefer in den Inhalt einer Webseite eindringt. Sein geschlossener "Think-Search-Write"-Prozess erzeugt im Wesentlichen einen detaillierten Reasoning Trace, der durch Reinforcement Learning optimiert wird. Dies ermöglicht es, ein umfassenderes Wissensbild in der öffentlichen Meinungsanalyse oder bei der Verfolgung von Branchen zu erstellen, die sowohl eine große Tiefe als auch eine große Breite an Informationen erfordern.

Adresse des Projekts:https://github.com/RUC-NLPIR/WebThinker

Search-R1 konzentriert sich auf "Meta-Kognition für die Suche". Es handelt sich nicht um einen festen Suchagenten, sondern um einen modularen Rahmen für den Aufbau und die Evaluierung von Suchagenten. Benutzer können verschiedene große Sprachmodelle wie LLaMA3, Qwen2.5, etc. mit Verstärkungslernalgorithmen wie PPO, GRPO, etc. frei kombinieren, genau wie bei der Konfiguration eines Servers. Diese Abstraktion auf Metaebene macht es zu einem leistungsstarken Forschungsinstrument, das es Entwicklern ermöglicht, die grundlegende Frage zu erforschen, wie KI lernt zu suchen, anstatt sich mit den Suchergebnissen selbst zufrieden zu geben.

Adresse des Projekts:https://github.com/PeterGriffinJin/Search-R1

Edge-Intelligenz und Datensouveränität: der Aufstieg der lokalisierten KI

Alita und AgenticSeek stehen stellvertretend für die Lösungen, die das KI-Computing aus der Cloud in den Edge-Bereich verlagern, da die Anforderungen an Datenschutz und Reaktionsfähigkeit steigen.

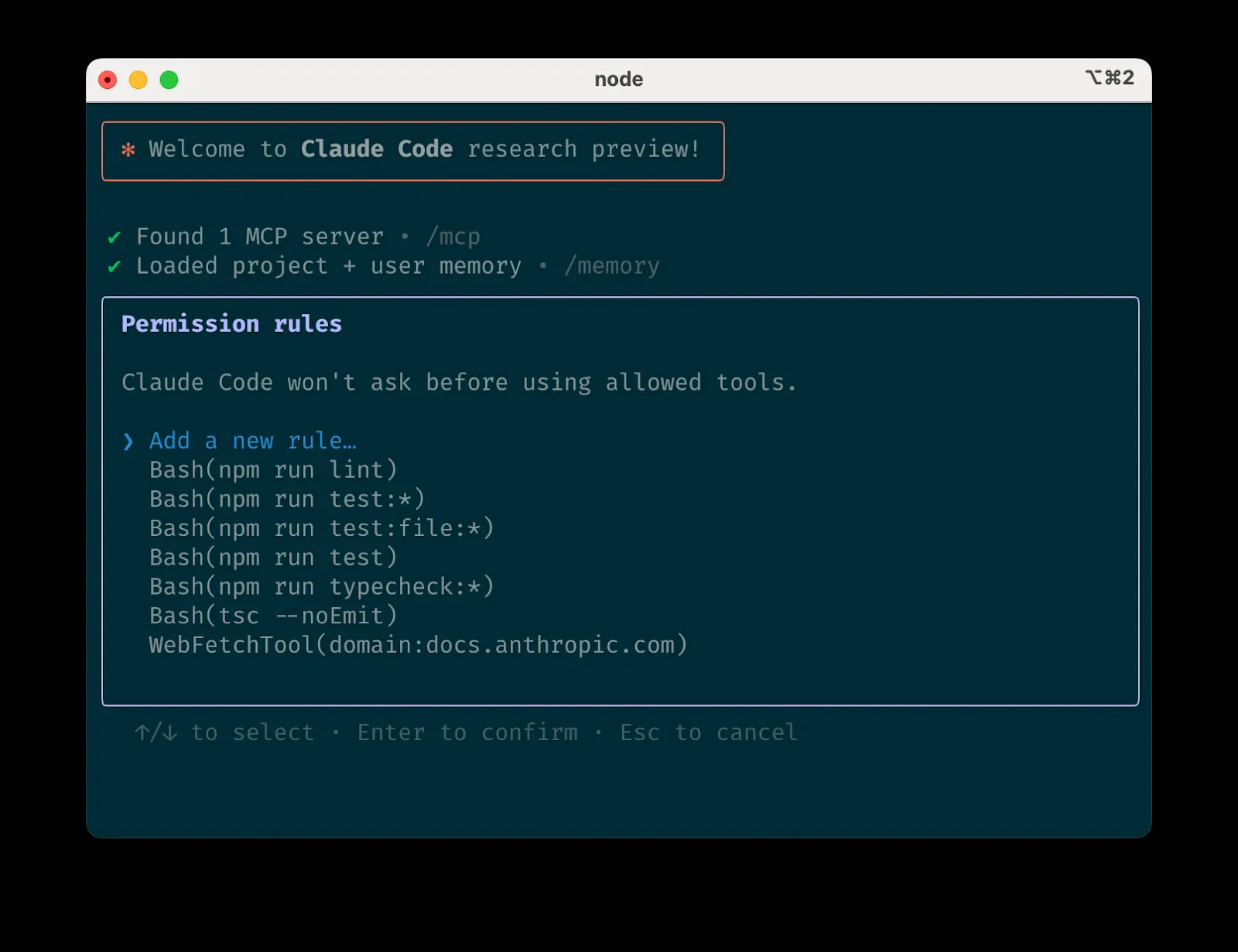

Das Kernkonzept von Alita besteht darin, die Integration und Wiederverwendung von Werkzeugen durch standardisierte Schnittstellen zu vereinfachen. Sein Model Context Protocol (MCP) kann als "Application Binary Interface (ABI) für KI-Tools" verstanden werden. Durch die Definition eines einheitlichen Interaktionsformats für verschiedene Werkzeuge ermöglicht Alita einen schnellen Zugriff und eine Erweiterung der Funktionalität, ohne dass komplexe Anpassungen für jedes neue Werkzeug erforderlich sind. Dieser "Plug-and-Play"-Charakter ermöglicht es, dass die aus einem einzigen Modul bestehende Denkarchitektur leichtgewichtig bleibt und gleichzeitig ein hohes Potenzial zur Selbstentwicklung besitzt, wodurch die Hürden für die Entwicklung komplexer KI-Anwendungen für Einzelpersonen und kleine Teams erheblich gesenkt werden.

Adresse des Projekts:https://github.com/CharlesQ9/Alita

AgenticSeek treibt die Datensouveränität auf die Spitze. Es handelt sich um einen KI-Agenten, der vollständig auf dem lokalen Gerät ausgeführt wird und sich nicht auf API-Aufrufe in der Cloud stützt, wodurch sichergestellt wird, dass keine Daten jemals den lokalen Bereich verlassen. Sein interner Mechanismus zum Abgleich der Aufgabenintelligenz kann als leichtes geräteseitiges "Mixture of Experts (MoE)"-Modell betrachtet werden, das auf intelligente Weise die am besten geeigneten lokalen Ressourcen auf der Grundlage der Art der Aufgabe (Browsing, Codierung, Planung) plant. Dies verschafft ihm einen unersetzlichen Vorteil beim Umgang mit hochsensiblen Daten wie Finanz- und medizinischen Daten oder bei der Arbeit in Offline-Umgebungen.

Adresse des Projekts:https://github.com/Fosowl/agenticSeek

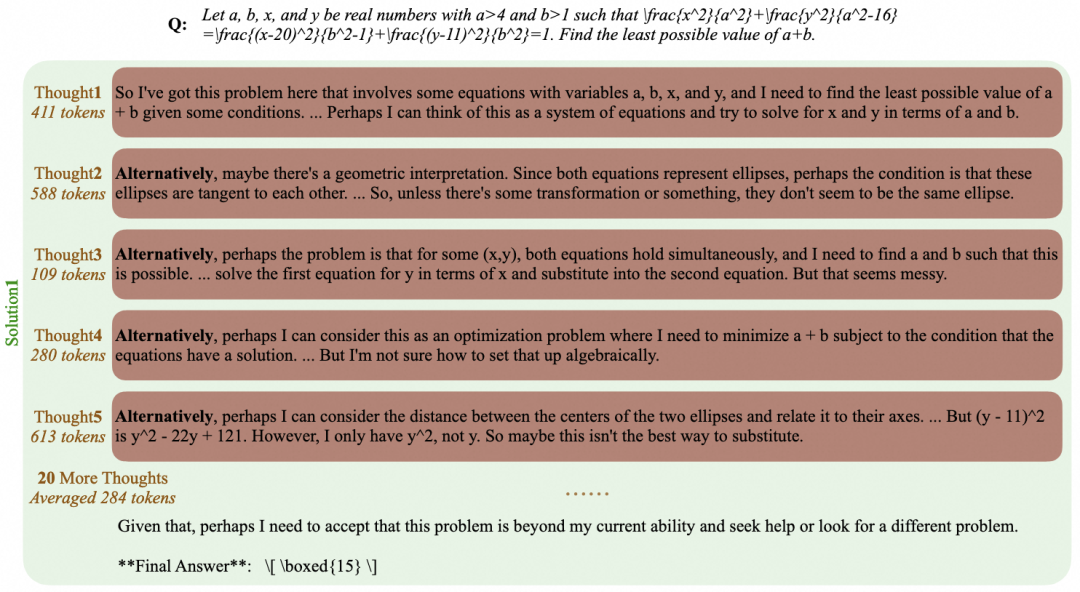

Freigegebene Modellierungsfähigkeiten: die Debatte über überwachte Feinabstimmung und Verstärkungslernpfade

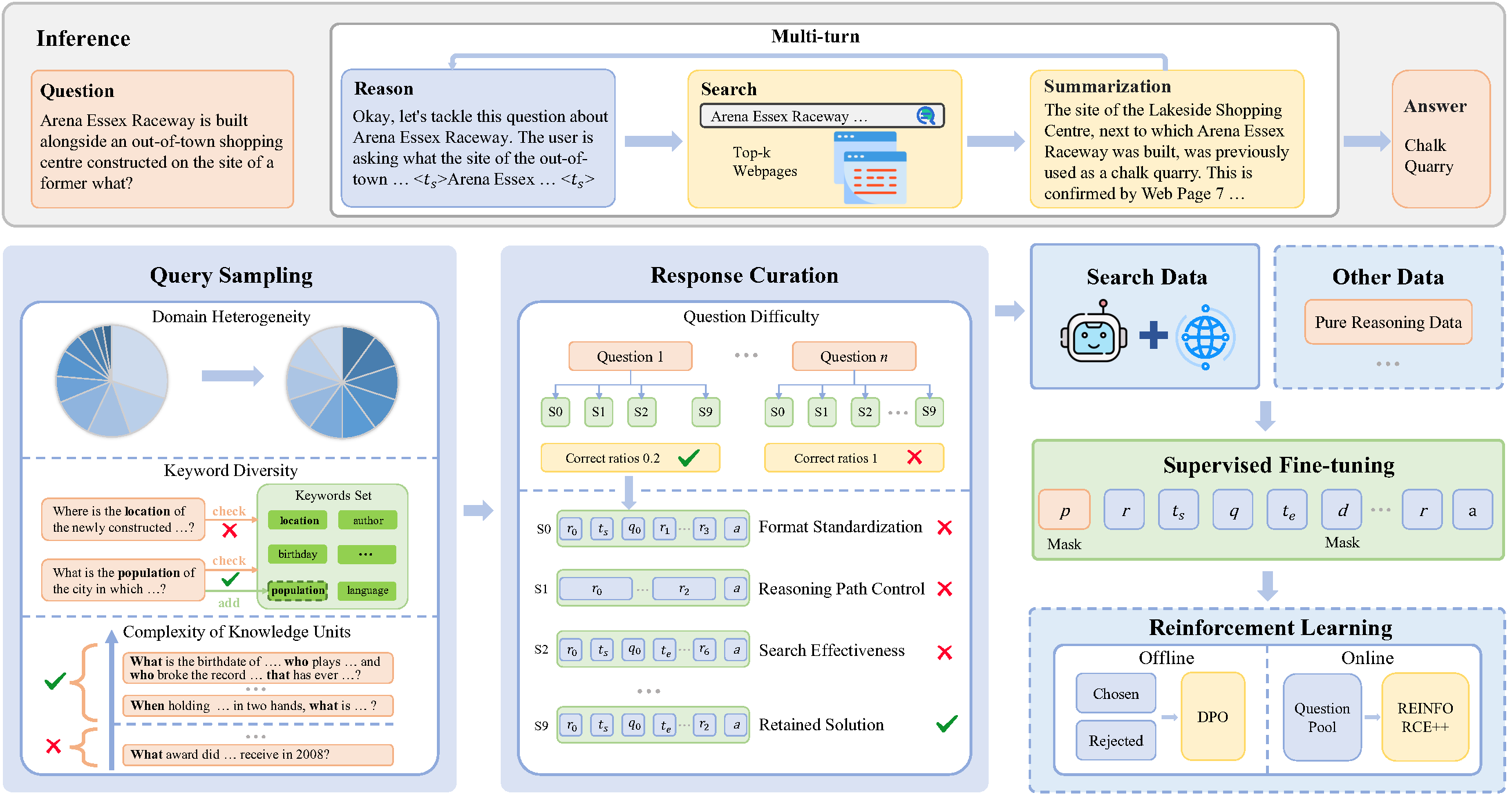

Wie man Modellen effizient beibringt, neue Fähigkeiten zu erlernen, ist ein zentrales Thema in der KI. SimpleDeepSearcher und ReCall sind innovative Anwendungen zweier gängiger Technologiepfade.

SimpleDeepSearcher hat bewiesen, dass hochwertiges Supervised Fine-Tuning (SFT) ebenso in der Lage ist, komplexe Forschungsfähigkeiten zu erreichen, von denen man bisher dachte, dass sie nur mit Reinforcement Learning (RL) erreichbar sind. Der Schlüssel zum Erfolg liegt in der Art und Weise, wie die Trainingsdaten aufgebaut sind. Anstatt einfache Datenpaare (Eingabe, endgültige Ausgabe) zu verwenden, werden durch die Simulation realer Webseiten-Interaktionen "Denk-Trajektorien" erzeugt, die Zwischenschritte und Entscheidungsprozesse enthalten. Diese Nachahmung des "Denkprozesses" ist weniger kostspielig und stabiler, als wenn man mit der Erforschung des Verstärkungslernens bei Null anfängt, und bietet eine wertvolle Abkürzung für das Training hochleistungsfähiger Spezialmodelle mit begrenzten Ressourcen.

Adresse des Projekts:https://github.com/RUCAIBox/SimpleDeepSearcher

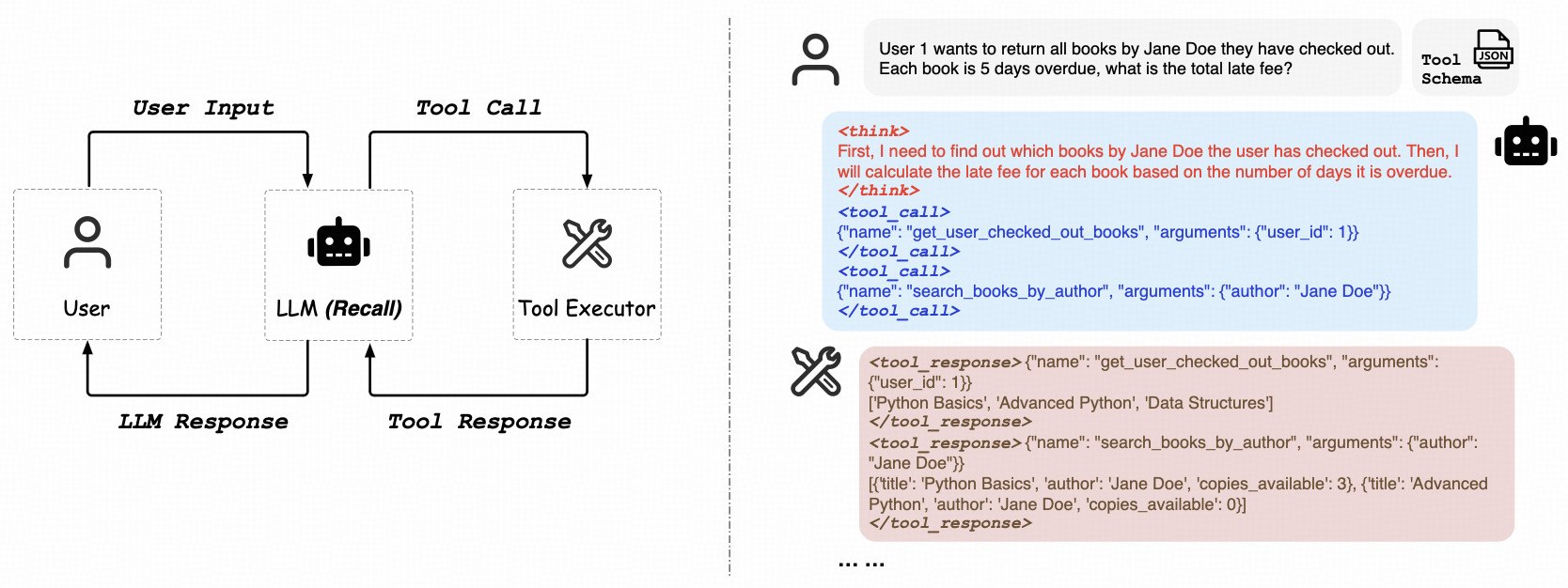

ReCall konzentriert sich auf einen reinen Verstärkungslernpfad und befasst sich mit der Generalisierungsfähigkeit von LLMs, die "lernen, Werkzeuge zu benutzen". Sein überzeugendstes Merkmal ist, dass es keine manuell beschrifteten Werkzeugaufrufdaten benötigt. Das Modell erhält Rückmeldungen von zurückgegebenen Ergebnissen (Erfolg, Misserfolg, Fehlermeldungen) durch direkte Interaktion mit der Umgebung (z. B. API-Endpunkte) und nutzt diese als Lernsignal, um seine Tool-Aufrufstrategie kontinuierlich zu optimieren. Dies ist analog zum Reinforcement Learning from AI Feedback (RLAIF), das es den Modellen ermöglicht, selbständig zu lernen, wie man OpenAI-ähnliche Tools in komplexen Aufgabenabläufen aufruft. Diese Fähigkeit ist ein entscheidender Schritt auf dem Weg zu einer Allzweck-KI (AGI).

Adresse des Projekts:https://github.com/Agent-RL/ReCall

End-to-End-Plattformen und strenge Forschung

In dem Maße, wie die zugrundeliegenden Fähigkeiten reifen, wird die Integration mehrerer Funktionen in eine End-to-End-Plattform und die Gewährleistung der Zuverlässigkeit des Outputs zu einem immer wichtigeren Ziel.

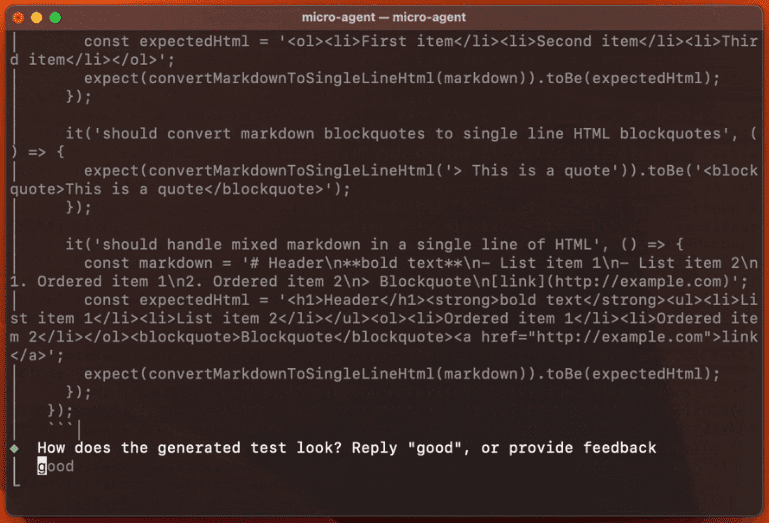

Suna ist als "KI-native Workflow-IDE" positioniert. Anstatt sich auf die Innovation einer zugrunde liegenden KI-Technologie zu konzentrieren, konzentriert sich Suna auf die Verbesserung der Entwicklererfahrung (DX). Durch die nahtlose Integration von Webbrowsing, Dateiverarbeitung, Befehlszeilenausführung und sogar Website-Bereitstellung zielt Suna darauf ab, die Kosten für den Wechsel zwischen verschiedenen Tools in einem technischen Workflow zu eliminieren. Es ist mehr wie ein Zapier oder Make für Entwickler und integriert KI-Funktionen tief in den gesamten Prozess des Projektmanagements und der Ausführung.

Adresse des Projekts:https://github.com/kortix-ai/suna

DeepResearcher hingegen geht die größte Herausforderung der KI in der seriösen Forschung direkt an: Zuverlässigkeit. DeepResearcher nutzt durchgängiges Reinforcement Learning, um Modelle zu trainieren und eine rigorose Forschungsstrategie zu entwickeln. Sein zentraler "Selbstreflexions"-Mechanismus stellt eine Art "epistemische Bescheidenheit" dar. Wenn das Modell nach der Überprüfung mehrerer Informationsquellen immer noch nicht zu einer zuverlässigen Schlussfolgerung gelangt, gibt es aktiv zu, dass es nicht weiß", anstatt zuversichtlich zu halluzinieren, wie es viele Modelle tun. Diese Art von Bewusstsein und Ehrlichkeit in Bezug auf Ungewissheit ist eine notwendige Eigenschaft für KI, um sich von einem "Informationsgenerator" zu einem vertrauenswürdigen "Forschungspartner" zu entwickeln.

Adresse des Projekts:https://github.com/GAIR-NLP/DeepResearcher