Allgemeine Einführung

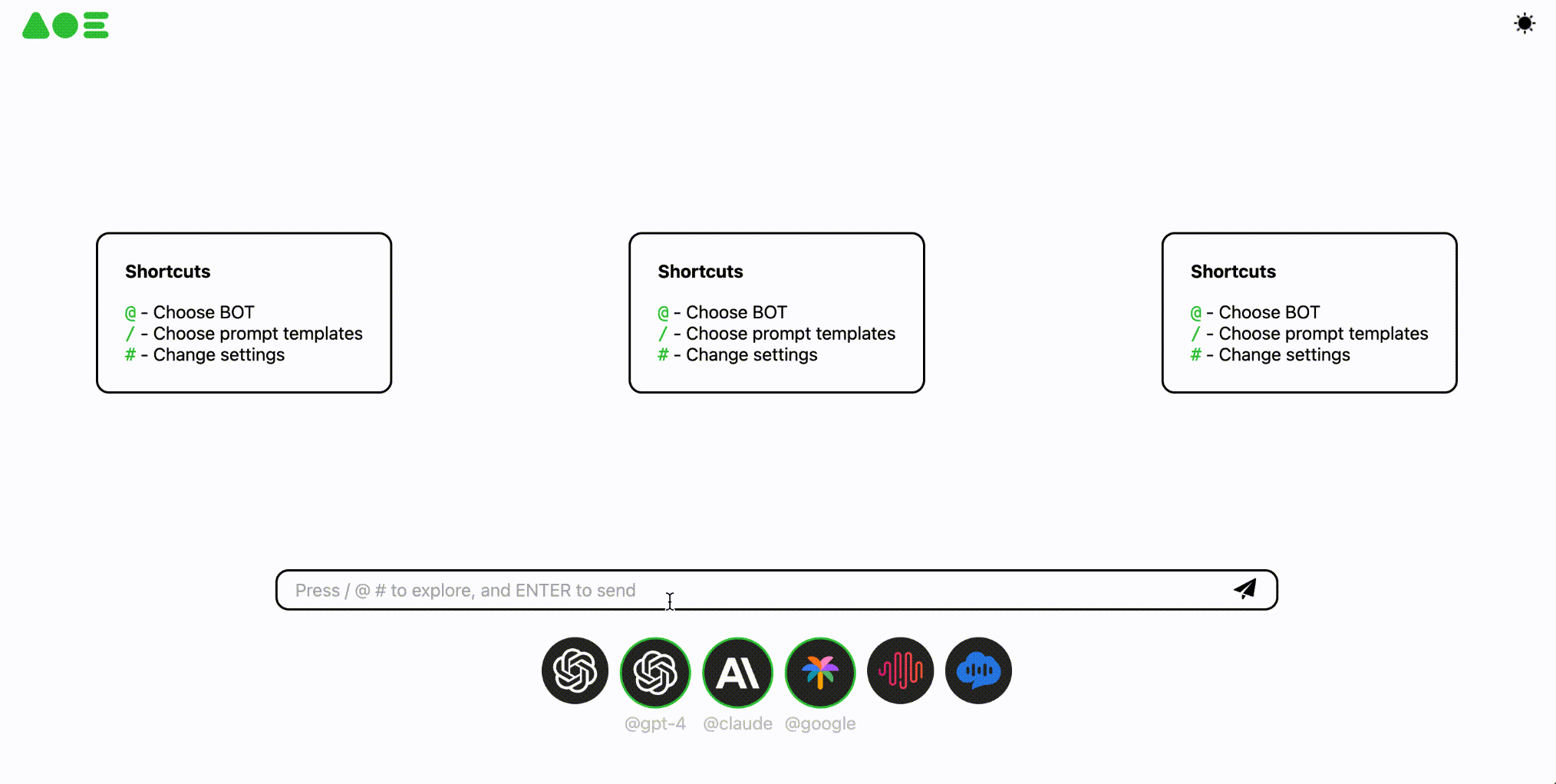

OpenAOE ist ein Open-Source-Gruppenchat-Framework für große Modelle, das das Problem des Mangels an Chat-Frameworks auf dem aktuellen Markt lösen soll, die auf mehrere Modelle parallel reagieren. Mit OpenAOE können Benutzer mit mehreren Large Language Models (LLMs) gleichzeitig sprechen und eine parallele Ausgabe erhalten. Das Framework unterstützt den Zugang zu mehreren kommerziellen und quelloffenen LLM-APIs, wie z.B. GPT-4, Google Palm, Minimax, Claude usw., und ermöglicht es den Benutzern, den Zugang zu anderen LLM-APIs anzupassen.OpenAOE bietet Back-End-APIs und Web-UIs, um den Bedürfnissen verschiedener Benutzer gerecht zu werden, und ist für LLM-Forscher, Evaluatoren, technische Entwickler und Laien geeignet. Entwickler und Nicht-Fachleute.

Funktionsliste

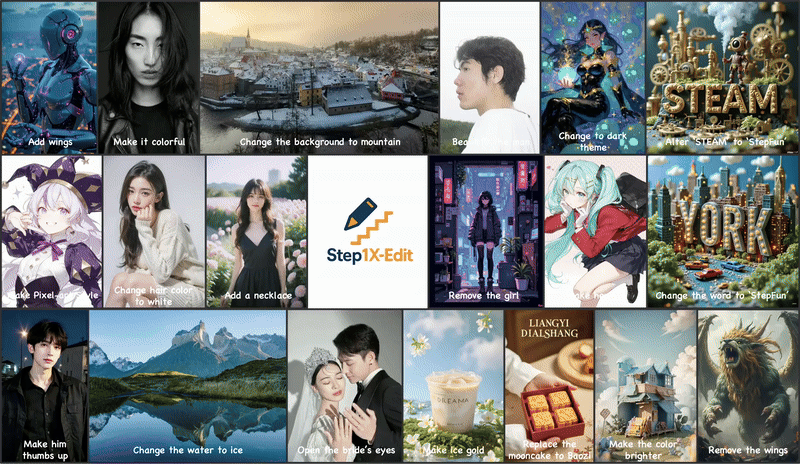

- Parallele Multimodell-AntwortUnterstützung für Konversationen mit mehreren großen Sprachmodellen zur gleichen Zeit, um eine parallele Ausgabe zu erhalten.

- Zugang zu kommerziellen und Open-Source-ModellenUnterstützung des Zugriffs auf GPT-4, Google Palm, Minimax, Claude und andere kommerzielle und Open-Source-APIs für große Sprachmodelle.

- Benutzerdefinierter ModellzugangErmöglicht den benutzerdefinierten Zugriff auf andere große Modell-APIs.

- Backend-API und Web-UIBietet Back-End-APIs und Web-UIs, um die Bedürfnisse verschiedener Benutzer zu erfüllen.

- Mehrere BetriebsartenUnterstützung für die Ausführung von OpenAOE über pip, docker und source.

Hilfe verwenden

Einbauverfahren

Installation über pip

- Stellen Sie sicher, dass die Python-Version >= 3.9 ist.

- Führen Sie den folgenden Befehl aus, um OpenAOE zu installieren:

pip install -U openaoe

- Starten Sie OpenAOE unter Verwendung der Konfigurationsdatei:

openaoe -f /path/to/your/config-template.yaml

Installation über Docker

- Holen Sie sich das OpenAOE-Docker-Image:

docker pull opensealion/openaoe:latest

oder ein Docker-Image erstellen:

git clone https://github.com/internlm/OpenAOE

cd OpenAOE

docker build . -f docker/Dockerfile -t opensealion/openaoe:latest

- Starten Sie den Docker-Container:

docker run -p 10099:10099 -v /path/to/your/config-template.yaml:/app/config.yaml --name OpenAOE opensealion/openaoe:latest

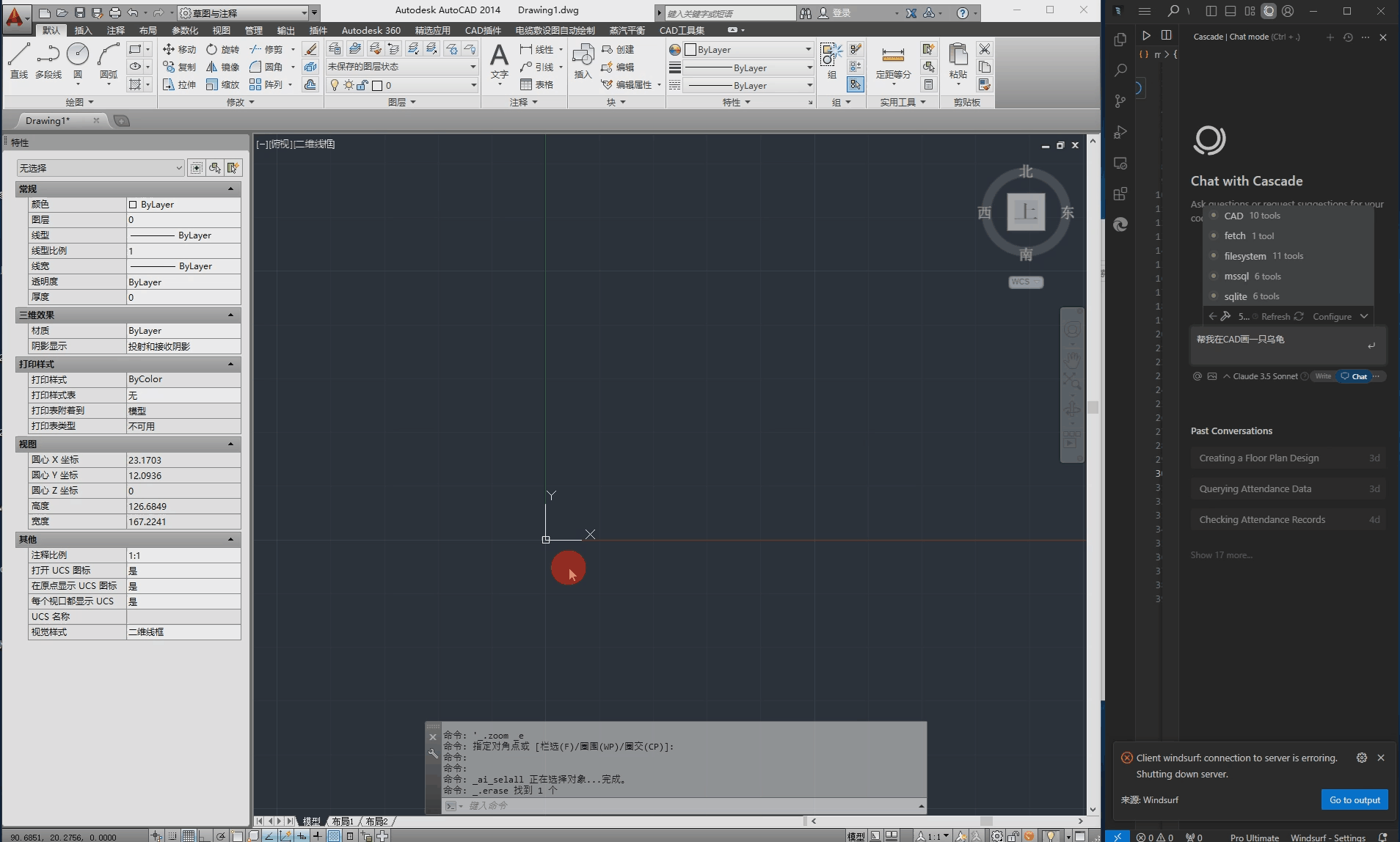

Leitlinien für die Verwendung

- KonfigurationsdateiBevor Sie OpenAOE starten, müssen Sie die Konfigurationsdatei vorbereiten

config-template.yamlDiese Datei wird zur Steuerung der Backend- und Frontend-Einstellungen verwendet. - Zugriffsmodell-APIIn der Konfigurationsdatei können die Benutzer die Modell-APIs konfigurieren, auf die zugegriffen werden muss, einschließlich GPT-4, Google Palm, Minimax, Claude usw. Die Benutzer können auch den Zugriff auf andere große Modell-APIs anpassen.

- Neue DiensteNach dem Start des OpenAOE-Dienstes im Anschluss an die Installation können die Nutzer ihn über die bereitgestellte Web-UI bedienen oder über die Backend-API integrieren.

- paralleler DialogIn der Web-UI kann der Benutzer ein Wort eingeben, woraufhin OpenAOE eine Anfrage an mehrere große Sprachmodelle gleichzeitig sendet und eine parallele Antwort liefert.

- Analyse der ErgebnisseBenutzer können die Reaktionsergebnisse verschiedener Modelle zur Analyse und Bewertung vergleichen.