Allgemeine Einführung

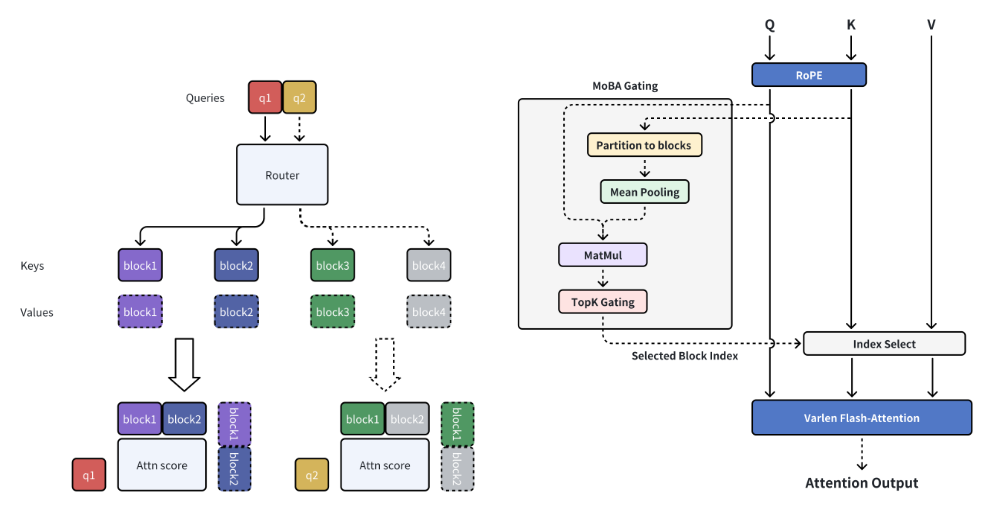

MoBA (Mixture of Block Attention) ist ein innovativer Aufmerksamkeitsmechanismus, der von MoonshotAI entwickelt wurde und für große Sprachmodelle (LLMs) mit langer Kontextverarbeitung konzipiert ist. MoBA erreicht eine effiziente Verarbeitung langer Sequenzen, indem es den gesamten Kontext in mehrere Blöcke unterteilt, und jedes Abfrage-Token lernt, sich auf die relevantesten KV-Blöcke zu konzentrieren. Sein einzigartiger parameterfreier Top-k-Gating-Mechanismus stellt sicher, dass sich das Modell nur auf die informativsten Chunks konzentriert, was die Berechnungseffizienz erheblich verbessert.MoBA ist in der Lage, nahtlos zwischen Full-Attention- und Sparse-Attention-Modi zu wechseln, was sowohl Leistung als auch Effizienz gewährleistet. Die Technik wurde erfolgreich auf Kimi-aktivierte lange Kontextanfragen angewandt, was einen bedeutenden Fortschritt bei der effizienten Berechnung der Aufmerksamkeit darstellt.

Funktionsliste

- Block Sparse AttentionAufteilung des vollständigen Kontexts in Teile und jedes Abfrage-Token lernt, sich auf die relevantesten KV-Teile zu konzentrieren.

- Parameterfreier AnschnittmechanismusEinführung eines parameterfreien Top-k-Gating-Mechanismus, der für jedes Abfrage-Token den relevantesten Block auswählt.

- Volle spärliche AufmerksamkeitsschaltungWechseln Sie nahtlos zwischen voller und spärlicher Aufmerksamkeit.

- Effizientes RechnenErhebliche Verbesserung der Berechnungseffizienz bei Aufgaben mit langem Kontext.

- offene QuelleVollständiger Open-Source-Code wird zur einfachen Nutzung und Weiterentwicklung bereitgestellt.

Hilfe verwenden

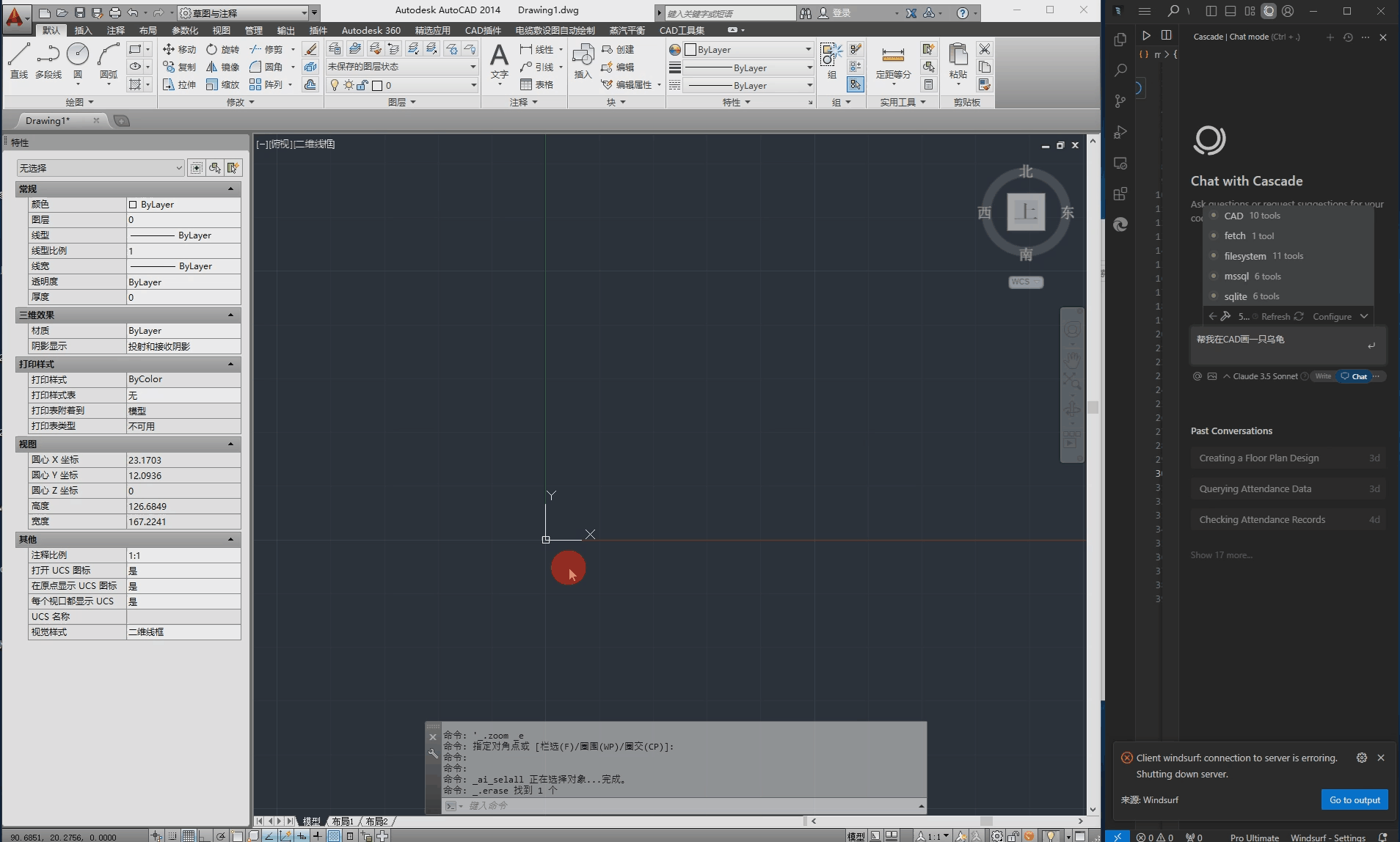

Einbauverfahren

- Erstellen Sie eine virtuelle Umgebung:

conda create -n moba python=3.10

conda activate moba

- Installieren Sie die Abhängigkeit:

pip install .

Schnellstart

Wir bieten eine MoBA-Implementierung, die mit Transformatoren kompatibel ist. Benutzer können die--attnDer Parameter wählt das Aufmerksamkeits-Backend zwischen moba und moba_naive.

python3 examples/llama.py --model meta-llama/Llama-3.1-8B --attn moba

Detaillierte Funktionsabläufe

- Block Sparse AttentionBeim Umgang mit langen Kontexten unterteilt MoBA den gesamten Kontext in mehrere Teile, und jedes Abfrage-Token lernt, sich auf die relevantesten KV-Teile zu konzentrieren, was eine effiziente Verarbeitung langer Sequenzen ermöglicht.

- Parameterfreier AnschnittmechanismusMoBA führt einen parameterfreien Top-k-Gating-Mechanismus ein, der für jedes Abfrage-Token den relevantesten Block auswählt und damit sicherstellt, dass sich das Modell nur auf die informativsten Blöcke konzentriert.

- Volle spärliche AufmerksamkeitsschaltungMoBA ist als flexible Alternative zur vollen Aufmerksamkeit konzipiert und ermöglicht einen nahtlosen Wechsel zwischen voller und geringer Aufmerksamkeit, wodurch sowohl Leistung als auch Effizienz gewährleistet werden.

- Effizientes RechnenDurch den oben beschriebenen Mechanismus verbessert MoBA die rechnerische Effizienz von langen Kontextaufgaben für eine Vielzahl komplexer Argumentationsaufgaben erheblich.

Beispielcode (Rechnen)

Nachfolgend finden Sie einen Beispielcode, der MoBA verwendet:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("meta-llama/Llama-3.1-8B")

model = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-3.1-8B", attn="moba")

inputs = tokenizer("长上下文示例文本", return_tensors="pt")

outputs = model(**inputs)

print(outputs)

Ein Satz Beschreibung (kurz)

MoBA ist ein innovativer Block-Attention-Mechanismus, der für große Sprachmodelle mit langer Kontextverarbeitung entwickelt wurde. Er verbessert die Berechnungseffizienz erheblich und unterstützt die vollständige Umschaltung der spärlichen Aufmerksamkeit.

Schlüsselwörter der Seite

Verarbeitung langer Kontexte, Block-Attention-Mechanismus, große Sprachmodelle, effizientes Rechnen, MoonshotAI

Allgemeine Einführung

MoBA (Mixture of Block Attention) ist ein innovativer Aufmerksamkeitsmechanismus, der von MoonshotAI entwickelt wurde und für große Sprachmodelle (LLMs) mit langer Kontextverarbeitung konzipiert ist. MoBA erreicht eine effiziente Verarbeitung langer Sequenzen, indem es den gesamten Kontext in mehrere Blöcke unterteilt, und jedes Abfrage-Token lernt, sich auf die relevantesten KV-Blöcke zu konzentrieren. Sein einzigartiger parameterfreier Top-k-Gating-Mechanismus stellt sicher, dass sich das Modell nur auf die informativsten Chunks konzentriert, was die Berechnungseffizienz erheblich verbessert.MoBA ist in der Lage, nahtlos zwischen Full-Attention- und Sparse-Attention-Modi zu wechseln, was sowohl Leistung als auch Effizienz gewährleistet. Die Technik wurde erfolgreich auf Kimi-aktivierte lange Kontextanfragen angewandt, was einen bedeutenden Fortschritt bei der effizienten Berechnung der Aufmerksamkeit darstellt.

Funktionsliste

- Block Sparse AttentionAufteilung des vollständigen Kontexts in Teile und jedes Abfrage-Token lernt, sich auf die relevantesten KV-Teile zu konzentrieren.

- Parameterfreier AnschnittmechanismusEinführung eines parameterfreien Top-k-Gating-Mechanismus, der für jedes Abfrage-Token den relevantesten Block auswählt.

- Volle spärliche AufmerksamkeitsschaltungWechseln Sie nahtlos zwischen voller und spärlicher Aufmerksamkeit.

- Effizientes RechnenErhebliche Verbesserung der Berechnungseffizienz bei Aufgaben mit langem Kontext.

- offene QuelleVollständiger Open-Source-Code wird zur einfachen Nutzung und Weiterentwicklung bereitgestellt.

Hilfe verwenden

Einbauverfahren

- Erstellen Sie eine virtuelle Umgebung:

conda create -n moba python=3.10

conda activate moba

- Installieren Sie die Abhängigkeit:

pip install .

Schnellstart

Wir bieten eine MoBA-Implementierung, die mit Transformatoren kompatibel ist. Benutzer können die--attnDer Parameter wählt das Aufmerksamkeits-Backend zwischen moba und moba_naive.

python3 examples/llama.py --model meta-llama/Llama-3.1-8B --attn moba

Detaillierte Funktionsabläufe

- Block Sparse AttentionBeim Umgang mit langen Kontexten unterteilt MoBA den gesamten Kontext in mehrere Teile, und jedes Abfrage-Token lernt, sich auf die relevantesten KV-Teile zu konzentrieren, was eine effiziente Verarbeitung langer Sequenzen ermöglicht.

- Parameterfreier AnschnittmechanismusMoBA führt einen parameterfreien Top-k-Gating-Mechanismus ein, der für jedes Abfrage-Token den relevantesten Block auswählt und damit sicherstellt, dass sich das Modell nur auf die informativsten Blöcke konzentriert.

- Volle spärliche AufmerksamkeitsschaltungMoBA ist als flexible Alternative zur vollen Aufmerksamkeit konzipiert und ermöglicht einen nahtlosen Wechsel zwischen voller und geringer Aufmerksamkeit, wodurch sowohl Leistung als auch Effizienz gewährleistet werden.

- Effizientes RechnenDurch den oben beschriebenen Mechanismus verbessert MoBA die rechnerische Effizienz von langen Kontextaufgaben für eine Vielzahl komplexer Argumentationsaufgaben erheblich.

Beispielcode (Rechnen)

Nachfolgend finden Sie einen Beispielcode, der MoBA verwendet:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("meta-llama/Llama-3.1-8B")

model = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-3.1-8B", attn="moba")

inputs = tokenizer("长上下文示例文本", return_tensors="pt")

outputs = model(**inputs)

print(outputs)