Allgemeine Einführung

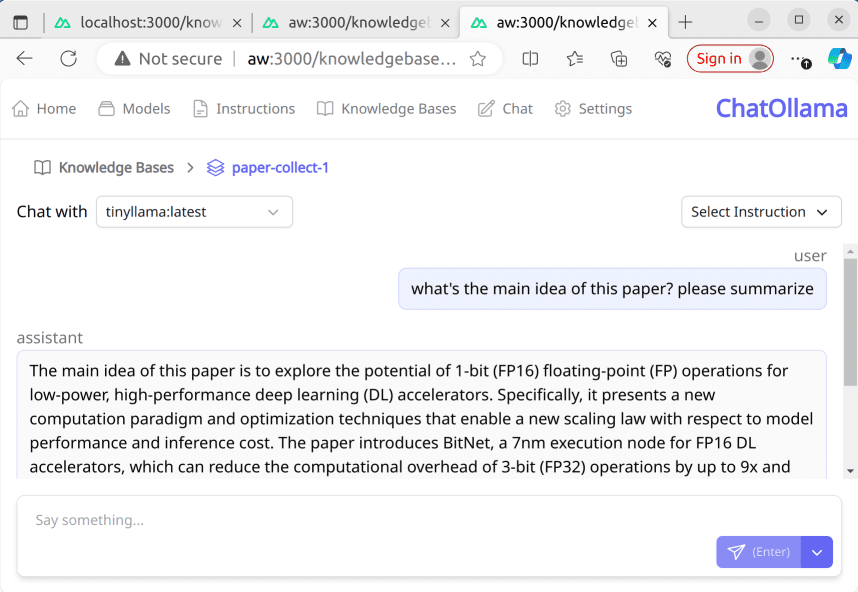

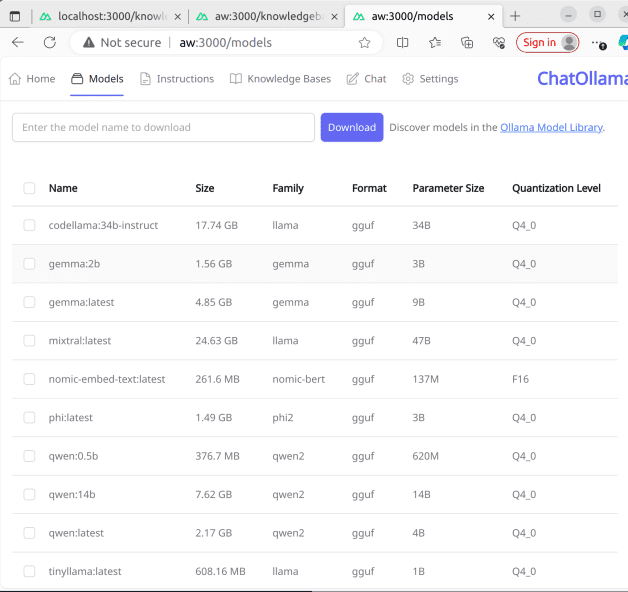

ChatOllama ist ein Open-Source-Online-Chat-Anwendungsprojekt, das auf groß angelegten Sprachmodellen (LLM) basiert und zahlreiche Sprachmodelle und Wissensdatenbankmanagement unterstützt. Benutzer können die Plattform für die Modellverwaltung (Listenanzeige, Download, Löschen), den Chat mit Modellen und andere Funktionen nutzen. Das Projekt verwendet das Nuxt 3-Framework und bietet einen detaillierten Leitfaden für die Einrichtung und Richtlinien für den Entwicklungsserver für Entwickler, die an der Entwicklung von Chatbots interessiert sind, um diese zu durchsuchen und zu unterstützen.

Funktionsliste

Modellverwaltung: einschließlich Anzeige, Herunterladen und Löschen von Modelllisten

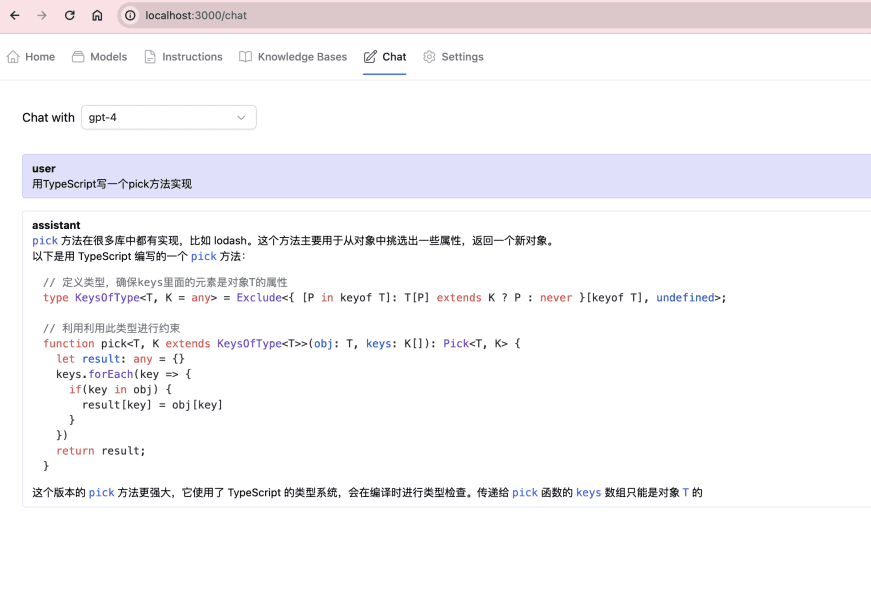

Fähigkeit zur Interaktion mit Chatmodellen

Unterstützung für mehrsprachige Modellierung und Wissensdatenbankmanagement (Wissensdatenbank auf Basis von LangChain)

Entwickelt auf Nuxt 3 und geschrieben in Vue und TypeScript.

Hilfe verwenden

Installieren Sie zuerst die Abhängigkeiten: npm install, pnpm install, yarn install oder bun install

Stellen Sie sicher, dass Sie einen laufenden Ollama-Server haben, die lokale Umgebung läuft standardmäßig unter http://localhost:11434

Gefunden auf http://localhost:3000上启动开发服务器: npm run dev