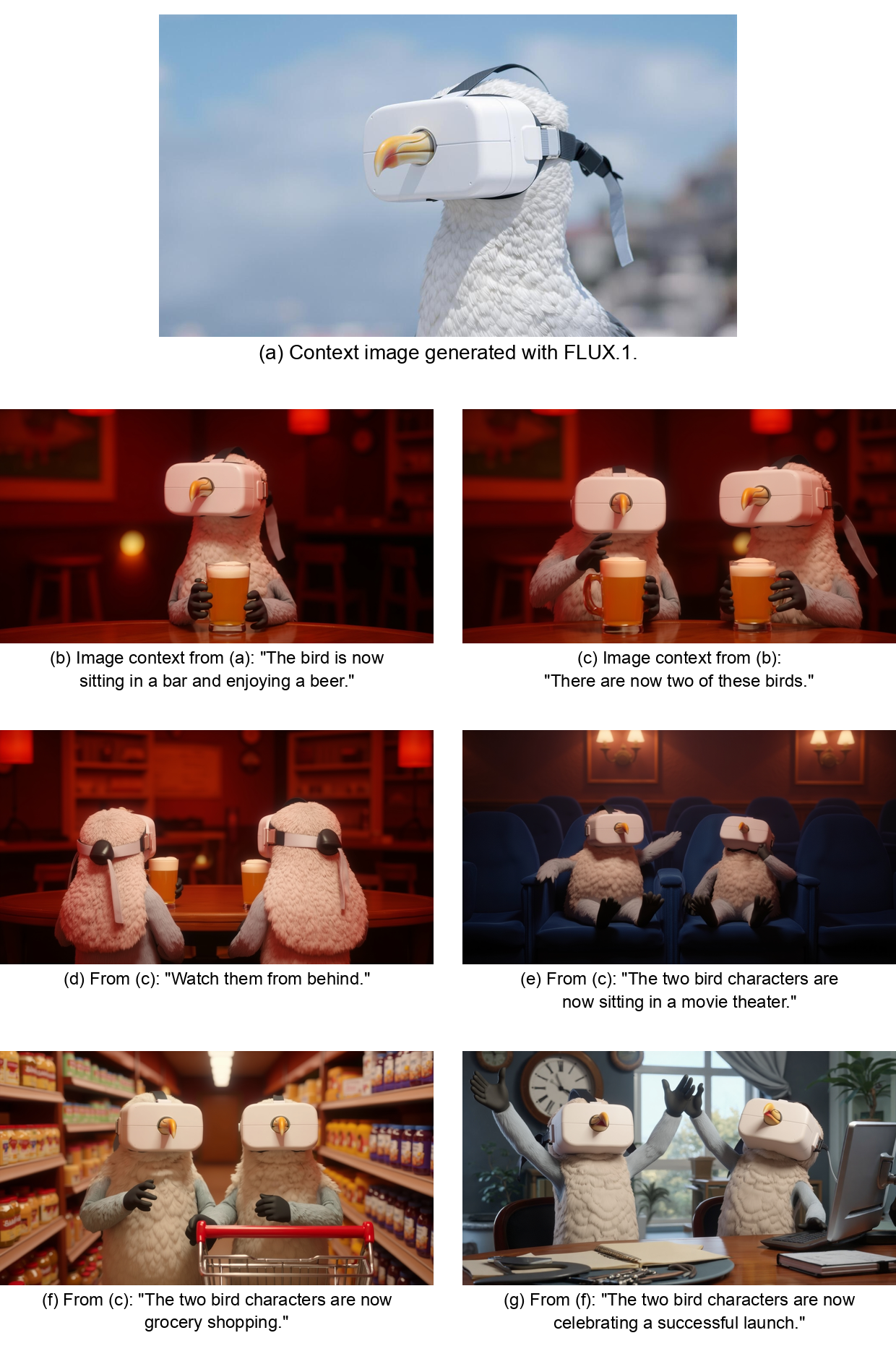

PartCrafter ist ein innovatives Open-Source-Projekt, das sich auf die Erzeugung editierbarer 3D-Teilemodelle aus einem einzigen RGB-Bild konzentriert. Es nutzt fortschrittliche strukturierte 3D-Generierungstechniken, um gleichzeitig mehrere semantisch sinnvolle 3D-Teile aus einem einzigen Bild zu generieren, was sich für die Spieleentwicklung, das Produktdesign und andere Bereiche eignet. Das Projekt basiert auf einem vortrainierten 3D-Mesh-Diffusionstransformator (DiT), der einen kombinatorischen latenten Raum und hierarchische Aufmerksamkeitsmechanismen einführt, um sicherzustellen, dass das generierte 3D-Modell die Gesamtkonsistenz beibehält und gleichzeitig die Details der Teile bewahrt. partCrafter stellt Trainingsdaten für 130.000 3D-Objekte bereit, indem große 3D-Objektdatensätze integriert werden, von denen 100.000 mehrteilige Annotationen enthalten. Das Projekt plant, bis zum 15. Juli 2025 Inferenzskripte und trainierte Modelle mit einer HuggingFace-Demo freizugeben, um die Benutzererfahrung und Entwicklung zu erleichtern.

Funktionsliste

- Generieren Sie mehrere bearbeitbare 3D-Teilemodelle aus einem einzigen RGB-Bild.

- Unterstützung für die Erzeugung von 3D-Netzen für komplexe Szenen mit mehreren Objekten.

- Bietet einen kombinatorischen latenten Raum zur unabhängigen Darstellung jedes 3D-Teils.

- Hierarchische Aufmerksamkeitsmechanismen werden eingesetzt, um die globale Konsistenz und die Beibehaltung von Details zwischen den Teilen zu gewährleisten.

- Kompatibel mit großen 3D-Datensätzen und unterstützt überwachtes Training auf Teilebene.

- Es ist geplant, Inferenzskripte, vortrainierte Modelle und HuggingFace-Demos zu veröffentlichen.

Hilfe verwenden

Einbauverfahren

Im Juni 2025 waren der vollständige Code und die vortrainierten Modelle für PartCrafter noch nicht vollständig veröffentlicht worden. Laut der offiziellen GitHub-Seite werden die Inferenzskripte und Pre-Training-Checkpoints voraussichtlich bis zum 15. Juli 2025 veröffentlicht werden. Im Folgenden finden Sie einen spekulativen Installations- und Nutzungsprozess auf der Grundlage aktueller Informationen, der in Zukunft auf der Grundlage offizieller Aktualisierungen angepasst werden kann.

- Vorbereitung der Umwelt

PartCrafter basiert auf Python, Python 3.8 oder höher wird empfohlen. Die Benutzer müssen die folgenden Abhängigkeiten installieren (warten Sie auf die offizielle Veröffentlichung der Abhängigkeitsliste):pip install torch numpy opencv-pythonStellen Sie sicher, dass das System die GPU-Beschleunigung (z. B. CUDA) unterstützt, um die Modellinferenz zu verbessern. Ein Linux- oder Windows-System mit mindestens 16 GB RAM und einem NVIDIA-Grafikprozessor wird empfohlen.

- Klon-Lager

Besuchen Sie das offizielle GitHub-Repositoryhttps://github.com/wgsxm/PartCrafterklonen Sie das Projekt lokal:git clone https://github.com/wgsxm/PartCrafter.git cd PartCrafter - Installation von vortrainierten Modellen

Offiziell ist geplant, vor dem Training Checkpoints zu veröffentlichen. Die Benutzer können die Checkpoint-Dateien herunterladen und in einem bestimmten Verzeichnis im Repository ablegen (z. B.checkpoints/). Der genaue Pfad und Download-Link müssen auf das offizielle Update warten. - Ausführen von Inferenzskripten

Sobald das Inferenzskript veröffentlicht ist, kann der Benutzer das Modell über die Befehlszeile ausführen. Angenommen, das Skript heißt zum Beispielinfer.pyDer Vorgang kann folgendermaßen aussehen:python infer.py --image_path <input_image.jpg> --output_dir <output_folder>Darunter.

--image_pathGeben Sie den Pfad des RGB-Eingabebildes an.--output_dirGibt den Pfad zum Speichern des generierten 3D-Modells an.

Hauptfunktionen

Die Kernfunktion von PartCrafter besteht darin, bearbeitbare 3D-Teilemodelle aus einem einzigen RGB-Bild zu erzeugen. Nachfolgend finden Sie die detaillierten Schritte:

- Vorbereiten der Eingabe eines Bildes

Die Benutzer müssen ein klares RGB-Bild bereitstellen, das das Zielobjekt oder die Szene enthält. Eine Bildauflösung von 512 x 512 oder höher wird empfohlen, um sicherzustellen, dass das Modell genügend Details erfasst. Nehmen Sie zum Beispiel ein Bild eines Stuhls auf, das Teile wie den Sitz, die Rückenlehne und die Beine enthält. - logische Schlussfolgerung

Die Bilder werden mit Inferenzskripten verarbeitet. Das Modell analysiert den Inhalt des Bildes, um mehrere 3D-Teilemodelle zu erzeugen. Beispielsweise kann PartCrafter nach der Eingabe eines Bildes eines Stuhls separate 3D-Netze für den Sitz, die Rückenlehne und die vier Beine ausgeben. Das Ausgabeformat ist normalerweise eine OBJ- oder PLY-Datei, die mit Blender, Unity und anderer Software kompatibel ist. - Bearbeiten von 3D-Modellen

Das generierte 3D-Modell unterstützt die Bearbeitung auf Teilebene. Benutzer können das Modell in Blender öffnen und die Geometrie, Textur oder Position einzelner Teile anpassen. Ändern Sie zum Beispiel den Winkel der Rückenlehne eines Stuhls oder die Länge seiner Beine, ohne dass sich dies auf andere Teile auswirkt. - Erzeugung von Szenen mit mehreren Objekten

Für komplexe Szenen (z. B. Bilder mit Tischen und Stühlen) kann PartCrafter Teilemodelle für mehrere Objekte gleichzeitig erzeugen. Das Modell gewährleistet die semantische Konsistenz zwischen den Teilen durch einen hierarchischen Aufmerksamkeitsmechanismus, z. B. die stilistische Einheitlichkeit zwischen Tisch- und Stuhlbeinen. - HuggingFace Demo Verwendung

Es ist geplant, eine HuggingFace-Demo zu starten, die es den Nutzern ermöglicht, Bilder hochzuladen und über eine Online-Schnittstelle auf 3D-Modelle zuzugreifen. Spezifische Operationen umfassen:- Besuchen Sie die PartCrafter-Seite auf der HuggingFace-Plattform.

- Laden Sie das RGB-Bild hoch und stellen Sie die Generierungsparameter ein (z. B. Anzahl der Teile oder Auflösung).

- Laden Sie die generierte 3D-Modelldatei herunter.

Featured Function Bedienung

- Kombinierter latenter RaumJedes 3D-Teil besteht aus einer Reihe von unabhängigen latenten Token wies darauf hin, dass die Benutzer bestimmte Teile durch die Anpassung von Token verändern können. Zum Beispiel kann durch die Änderung der Token einer Stuhllehne eine anders geformte Rückenlehne erzeugt werden.

- Hierarchische AufmerksamkeitsmechanismenDas Modell sorgt während der Generierung automatisch für ein Gleichgewicht zwischen globaler Konsistenz und lokalen Details zwischen den Teilen. Der Benutzer muss die Beziehungen zwischen den Teilen nicht manuell anpassen; das Modell stellt sicher, dass die generierten Stuhlbeine stilistisch mit dem Sitz koordiniert sind.

- Überwachung auf TeilebenePartCrafter: Dank eines Datensatzes von 130.000 3D-Objekten kann PartCrafter Teile generieren, die auf dem Bild nicht direkt sichtbar sind. Geben Sie zum Beispiel ein Bild der Vorderseite eines Stuhls ein, und das Modell kann daraus den hinteren Teil ableiten und generieren.

caveat

- Stellen Sie sicher, dass die Eingabebilder gut beleuchtet sind und einen einfachen Hintergrund haben, um die Qualität der Generierung zu verbessern.

- Die erzeugten 3D-Netze eignen sich für das Rendering und die Entwicklung von Spielen, aber die Umwandlung in industrietaugliche Volumenmodelle kann eine zusätzliche Bearbeitung erfordern (z. B. die Umwandlung mit spezieller Software).

- Die offizielle Dokumentation und der Community-Support (z. B. GitHub Issues) können weitere Hilfe bieten.

Anwendungsszenario

- Spieleentwicklung

Entwickler können Cognitive PartCrafter verwenden, um schnell 3D-Modelle von Spielelementen zu erstellen. Die Erzeugung editierbarer 3D-Modelle aus einem einzigen Requisitenbild beschleunigt zum Beispiel den Level-Design-Prozess. - Produktdesign

Konstrukteure können mit PartCrafter Produktkonzeptzeichnungen in bearbeitbare 3D-Teilemodelle für das Rapid Prototyping und Modifikationen umwandeln. - Bildung und Forschung

Forscher können mit PartCrafter komplexe 3D-Modelle für den Unterricht, die 3D-Visualisierung oder die experimentelle Validierung erzeugen.

QA

- Welche Formate werden für die von PartCrafter erzeugten 3D-Modelle unterstützt?

Unterstützt derzeit die Formate OBJ und PLY, kompatibel mit Blender, Unity und anderer gängiger 3D-Software. - Benötige ich spezielle Kenntnisse, um PartCrafter zu benutzen?

Nicht erforderlich, aber Benutzer, die mit Python und 3D-Modellierungssoftware vertraut sind, können die Werkzeuge effizienter nutzen. - Wie komplex kann PartCrafter ein Modell erzeugen?

Es erzeugt 3D-Modelle von mehrteiligen Objekten und komplexen Szenen, wobei die genaue Komplexität von der Qualität des Eingangsbildes und den Trainingsdaten des Modells abhängt. - Ist das Projekt vollständig quelloffen?

Das Projekt ist quelloffen, Inferenzskripte und Trainingsdaten werden nach und nach veröffentlicht, vorbehaltlich offizieller Aktualisierungen.