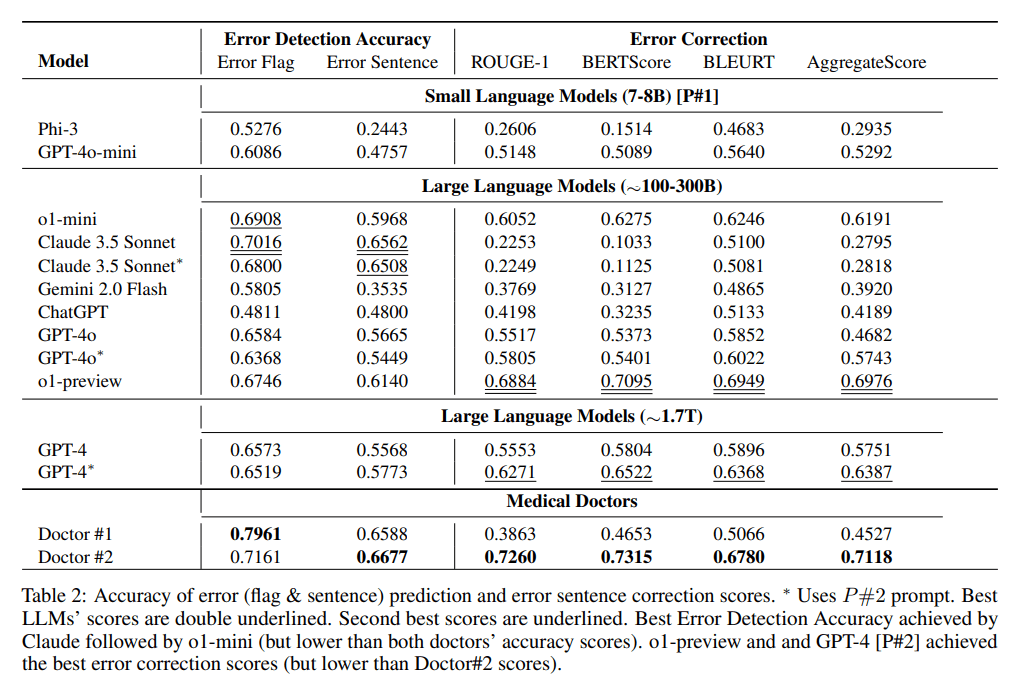

Es gab eine anhaltende Diskussion über die Parametergrößen von Mainstream-LLMs mit geschlossenem Quellcode, und in den letzten 2 Tagen von 2024 wurde ein Artikel von Microsoft über dieAufdeckung und Korrektur von medizinischen Fehlern in klinischen AufzeichnungenVermutungenExperimentBezugsgrößeDie MEDEC-Studie hat versehentlich und direkt die Größenordnung ihrer Parameter verfehlt:o1-Vorschau, GPT-4.GPT-4o undClaude 3.5 Sonett.

Adresse des Papiers: https://arxiv.org/pdf/2412.19260v1

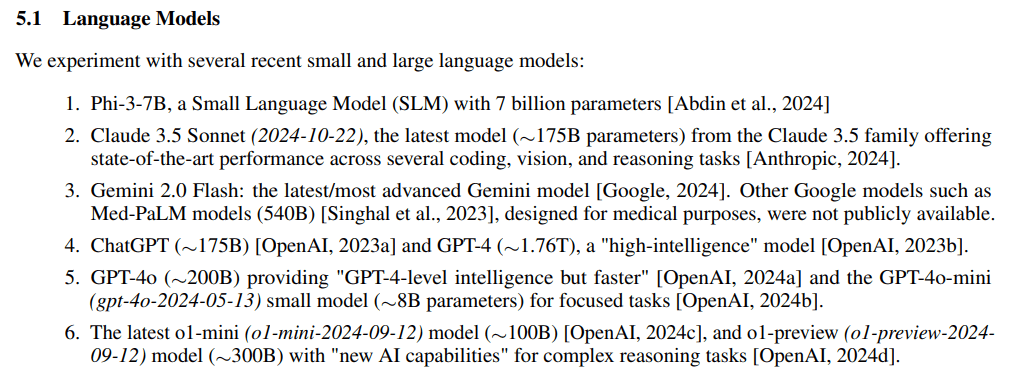

Im experimentellen Teil des Versuchs werden die großen Modellparameterskalen ebenfalls in 3 Blöcke unterteilt:7-8B, ~100-300B, ~1,7Taber (nicht)GPT-4o-miniMit nur 8B auf dem ersten Platz zu stehen, ist ein bisschen unglaublich.

Zusammenfassungen

- Claude 3.5 Sonnet (2024-10-22), ~175B

- ChatGPT, ~175B

- GPT-4, etwa 1,76 T

- GPT-4o, ~200B

- GPT-4o-mini (gpt-4o-2024-05-13) nur 8B

- Letzter o1-mini (o1-mini-2024-09-12) nur 100B

- o1-vorschau (o1-vorschau-2024-09-12) ~ 300B