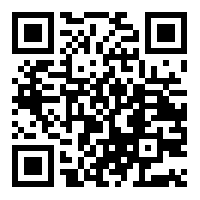

综合介绍 llm.pdf 是一个开源项目,允许用户在 PDF 文件中直接运行大型语言模型(LLM)。这个项目由 EvanZhouDev 开发,托管在 GitHub 上,展示了一种创新的方法:通过 Emscripten 将 llama.cpp...

综合介绍 Aana SDK 是一个开源框架,由 Mobius Labs 开发,名字源于马拉雅拉姆语“ആന”(大象)。它帮助开发者快速部署和管理多模态 AI 模型,支持处理文本、图像、音频和视频等多种数据。Aana SDK 基于 Ray 分布...

综合介绍 BrowserAI 是一个开源工具,让用户直接在浏览器中运行本地 AI 模型。它由 Cloud-Code-AI 团队开发,支持像 Llama、DeepSeek、Kokoro 这样的语言模型。用户无需服务器或复杂设置,就能通过浏览器...

综合介绍 LitServe 是 Lightning AI 推出的一款开源 AI 模型服务引擎,基于 FastAPI 构建,专注于快速部署通用 AI 模型的推理服务。它支持从大型语言模型(LLM)、视觉模型、音频模型到经典机器学习模型的广泛场...

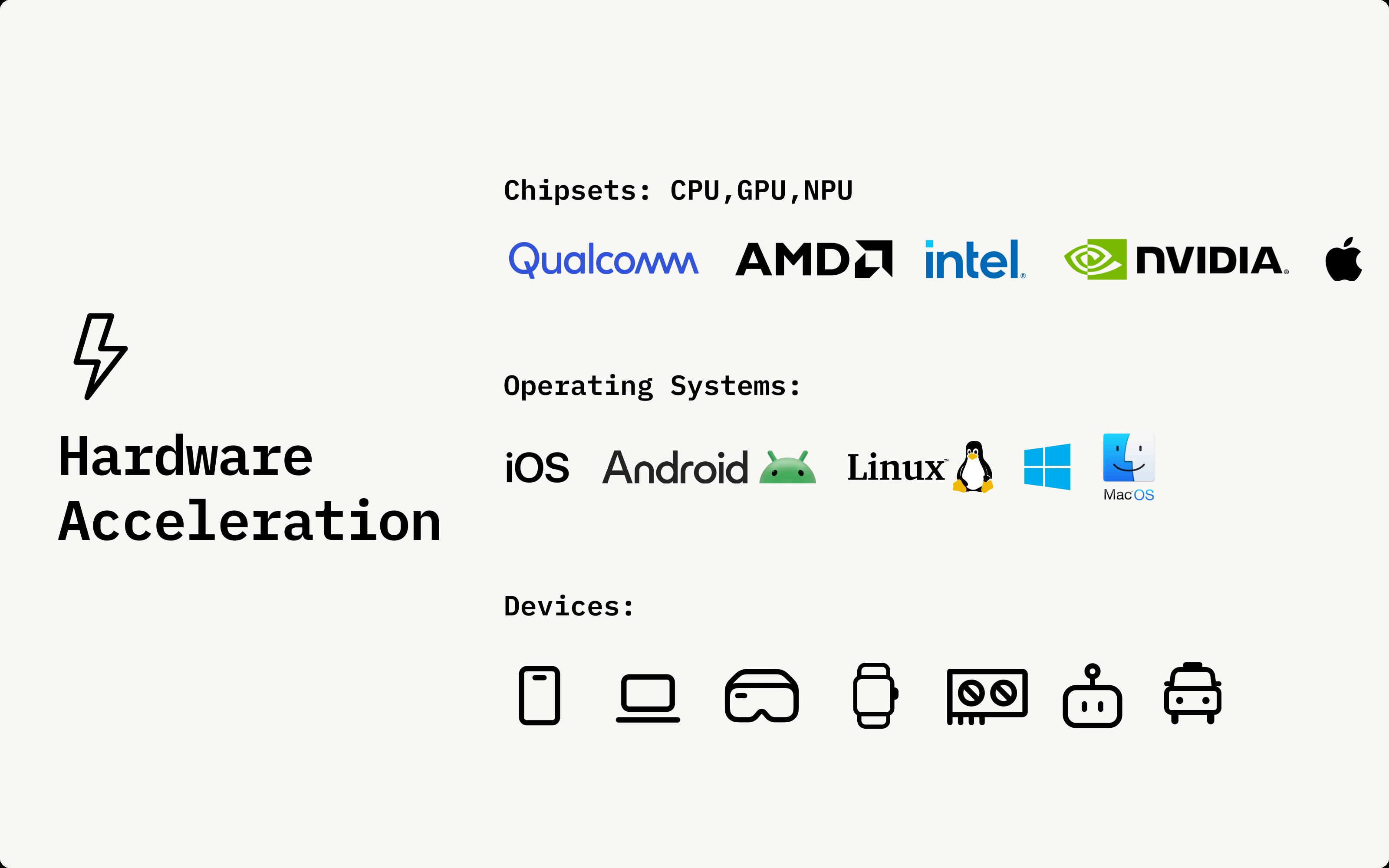

综合介绍 Nexa AI 是一个专注于本地运行的多模态AI解决方案的平台。它提供了多种AI模型,包括自然语言处理(NLP)、计算机视觉、语音识别和生成(ASR和TTS)等,所有这些模型都可以在本地设备上运行,无需依赖云...

综合介绍 vLLM是一个高吞吐量和内存高效的推理和服务引擎,专为大语言模型(LLM)设计。该项目最初由加州大学伯克利分校的Sky Computing Lab开发,现已成为一个由学术界和工业界共同驱动的社区项目。vLLM旨在提供...

综合介绍 Transformers.js 是 Hugging Face 提供的一个 JavaScript 库,旨在将最先进的机器学习模型直接在浏览器中运行,无需服务器支持。该库与 Hugging Face 的 Python 版 transf...

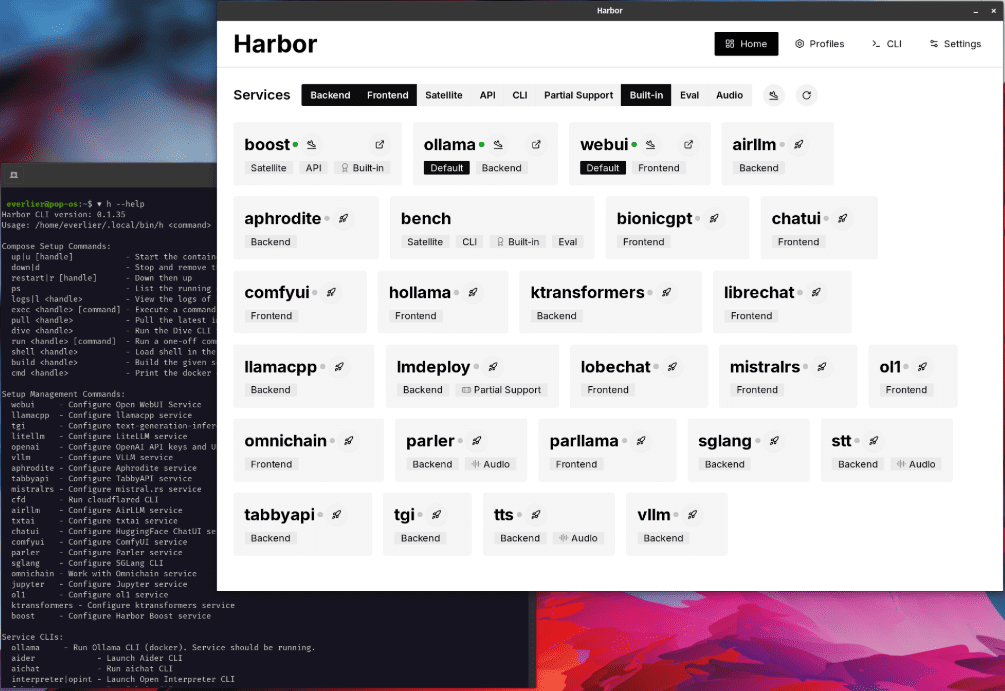

综合介绍 Harbor是一个革新性的容器化LLM工具集,专注于简化本地AI开发环境的部署和管理。它通过简洁的命令行界面(CLI)和配套应用程序,让开发者能够一键启动和管理包括LLM后端、API接口、前端界面在内的所有AI服...

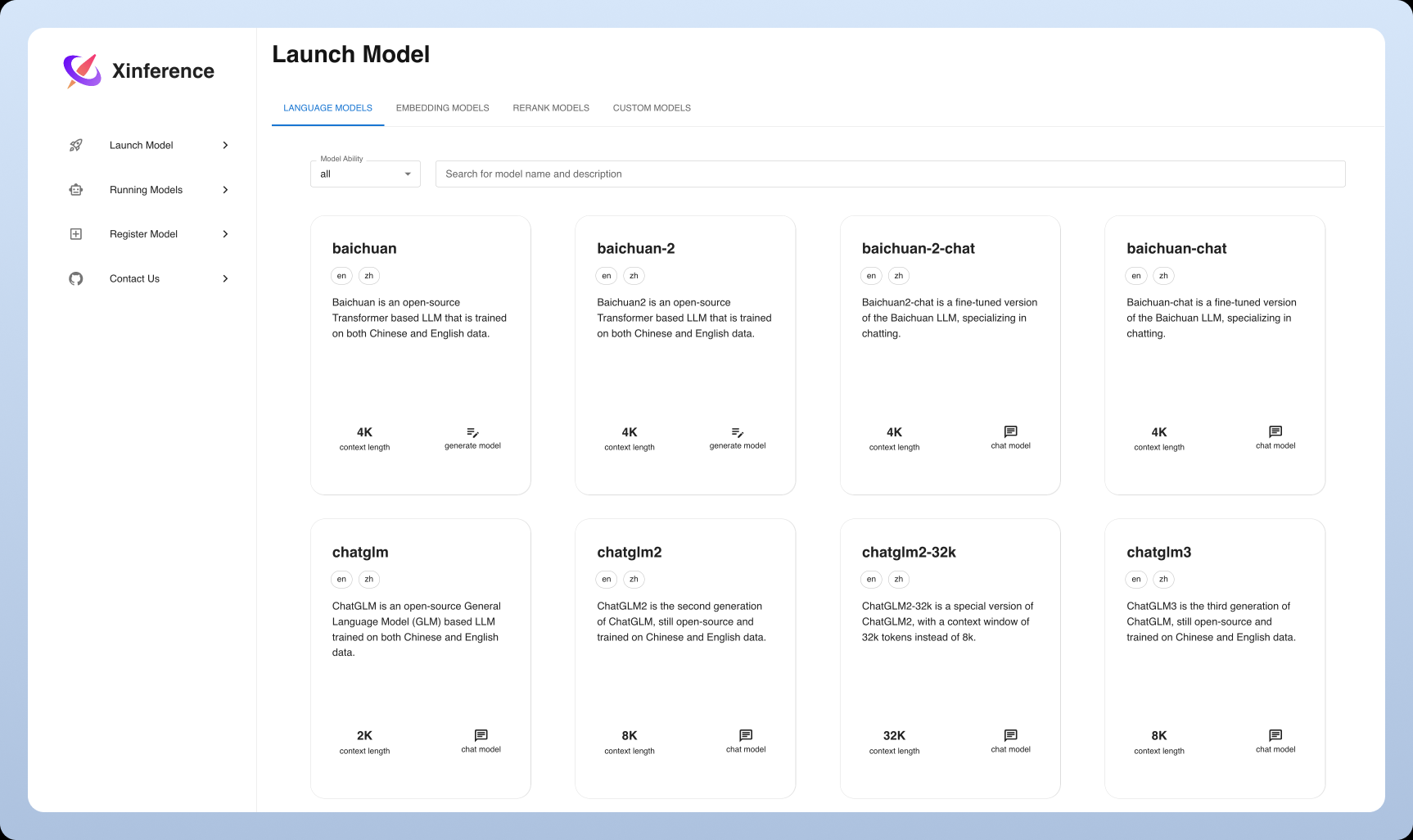

综合介绍 Xorbits Inference(简称Xinference)是一个强大且多功能的库,专注于为语言模型、语音识别模型和多模态模型提供分布式部署和服务。通过Xorbits Inference,用户可以轻松部署和服务自己的模型或内置的...

综合介绍 AI Dev Gallery是微软推出的一款专为Windows开发者设计的AI开发工具应用程序(目前处于公开预览版)。它提供了一个综合性平台,帮助开发者轻松地将AI功能集成到自己的Windows应用程序中。该工具最显著的特...

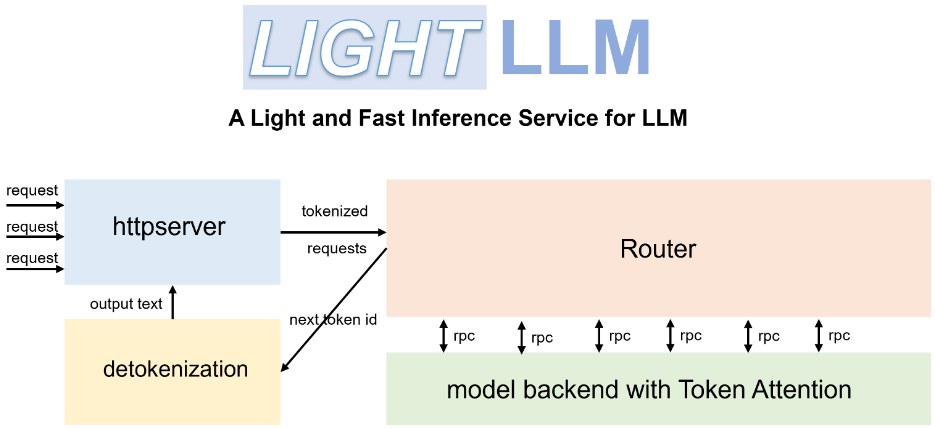

综合介绍 LightLLM 是一个基于 Python 的大语言模型(LLM)推理和服务框架,以其轻量级设计、易于扩展和高效性能而著称。该框架利用了多种知名的开源实现,包括 FasterTransformer、TGI、vLLM 和 Flash...

综合介绍 Transformers.js 是由 Hugging Face 开发的一个 JavaScript 库,旨在让用户能够直接在浏览器中运行最先进的机器学习模型,而无需服务器支持。该库与 Hugging Face 的 Python 版 ...

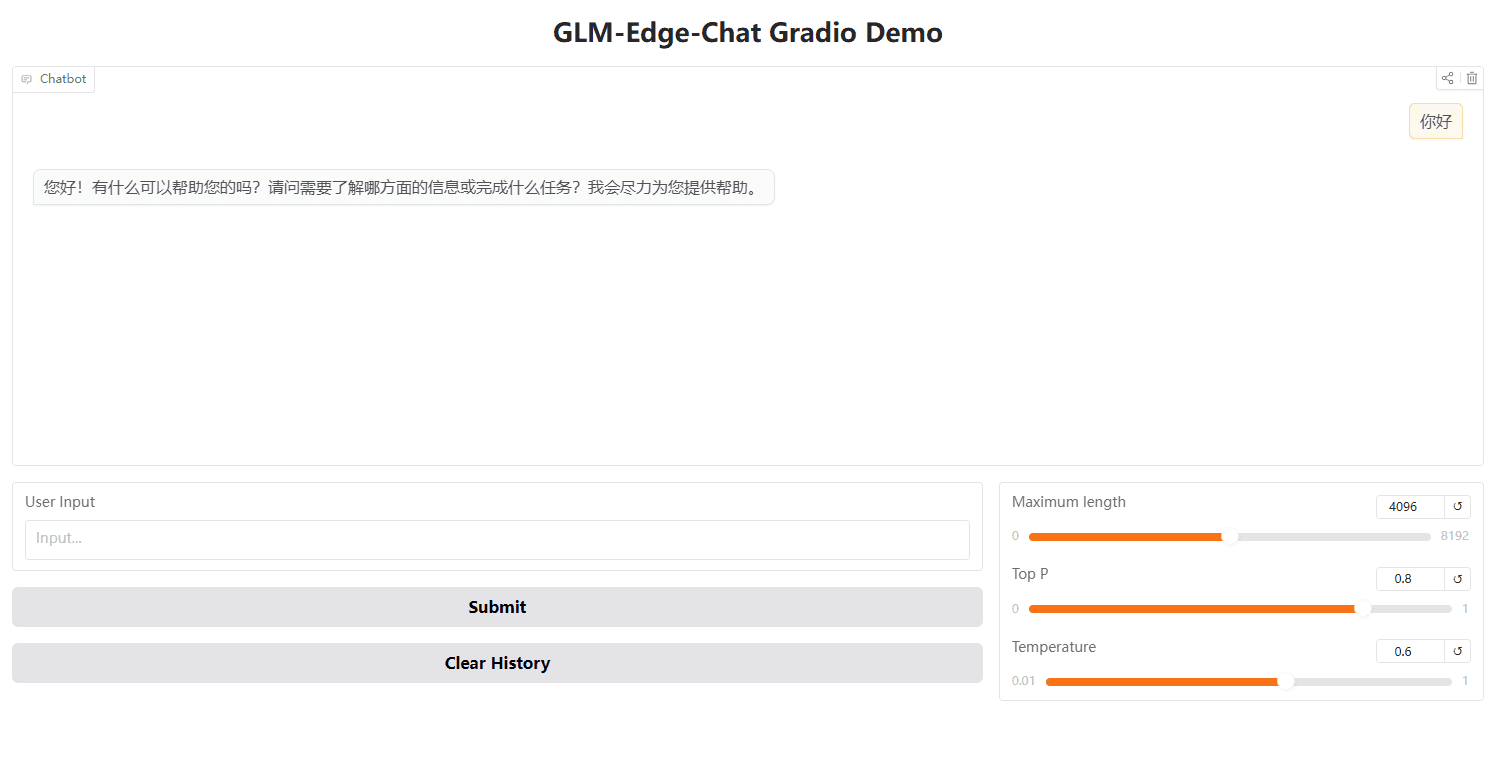

综合介绍 GLM-Edge 是清华大学(智谱轻言)推出的一系列专为端侧设备设计的大语言模型和多模态理解模型。这些模型包括 GLM-Edge-1.5B-Chat、GLM-Edge-4B-Chat、GLM-Edge-V-2B 和 GLM-Edg...

综合介绍 Exo是一个开源项目,旨在利用日常设备(如iPhone、iPad、Android、Mac、Linux等)运行自己的AI集群。通过动态模型分区和自动设备发现,Exo能够将多个设备统一成一个强大的GPU,支持多种模型如LLaMA、Mi...

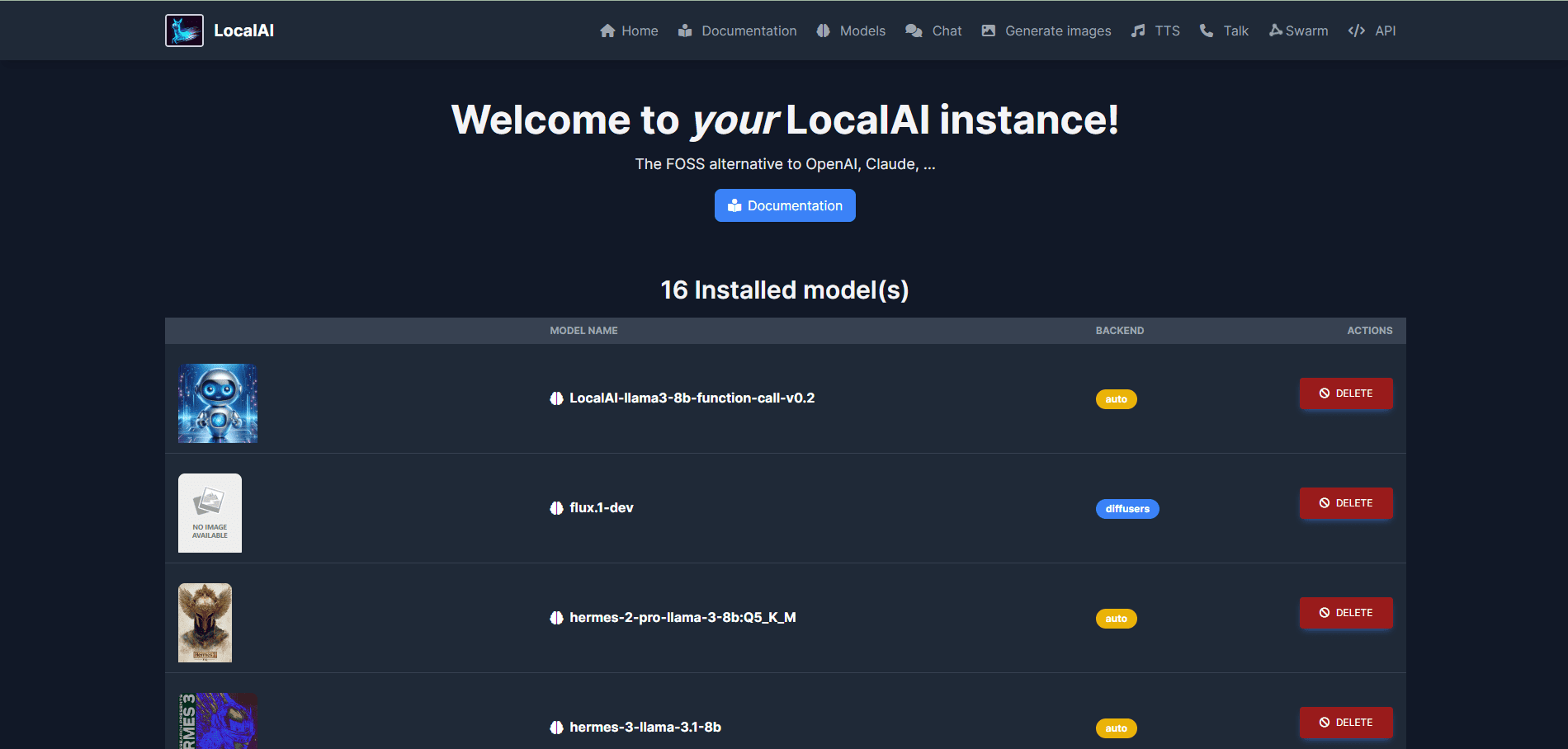

综合介绍 LocalAI 是一个开源的本地AI替代方案,旨在提供与OpenAI、Claude等兼容的API接口。它支持在消费级硬件上运行,不需要GPU,能够进行文本、音频、视频、图像生成和语音克隆等多种任务。LocalAI 由 Ettore...

综合介绍 llamafile 是一个由 Mozilla Builders 项目推出的工具,旨在简化大语言模型(LLM)的部署和运行。通过将 llama.cpp 与 Cosmopolitan Libc 结合,llamafile 将复杂的 LL...

综合介绍 Petals 是一个由 BigScience Workshop 开发的开源项目,旨在通过分布式计算的方式运行大型语言模型(LLMs)。用户可以在家中使用消费级 GPU 或 Google Colab 运行和微调 LLMs,如 Lla...

综合介绍 Aphrodite Engine是PygmalionAI的官方后端引擎,旨在为PygmalionAI网站提供推理端点,并支持Hugging Face兼容模型的快速部署。该引擎利用vLLM的Paged Attention技术,实现了...

综合介绍 llama.cpp是一个用纯C/C++实现的库,旨在简化大语言模型(LLM)的推理过程。它支持多种硬件平台,包括Apple Silicon、NVIDIA GPU和AMD GPU,并提供多种量化选项以提高推理速度和减少内存使用。该项...