百度于 6 月 30 日宣布,正式开源其最新的 ERNIE 4.5 大规模多模态模型家族。该系列包含 10 个不同规模的变体,全面拥抱混合专家(MoE)架构,并提供从模型、开发套件到部署工具的全栈式解决方案,所有模型均在 Apache 2.0 许可下开放。

技术核心:专为多模态设计的异构 MoE 架构

与业界常见的 MoE 模型不同,ERNIE 4.5 的一个显著特点是其创新的“多模态异构 MoE”预训练方法。该架构旨在让模型在处理文本和图像等多模态信息时,既能共享通用参数,也保留了专门处理特定模态信息的独立参数。

为了实现这一目标,研发团队设计了多种技术,包括模态隔离路由(modality-isolated routing)、路由器正交损失(router orthogonal loss)和多模态令牌平衡损失(multimodal token-balanced loss)。这些设计的核心思想是,在联合训练期间,确保文本和视觉两种模态的学习能够相互促进,而不是相互干扰,从而在不牺牲文本任务性能的前提下,显著增强模型的多模态理解能力。

除了模型架构,百度还强调了其在训练和推理基础设施上的效率优化。通过节点内专家并行、内存高效的流水线调度、FP8 混合精度训练以及细粒度重计算等技术,其最大规模的语言模型预训练实现了 47% 的模型 FLOPs 利用率(MFU)。在推理端,ERNIE 4.5 采用了多专家并行协作和卷积编码量化等算法,实现了 4-bit/2-bit 的低比特量化。

性能表现:与业界顶尖模型的多维度对比

根据百度公布的基准测试结果,ERNIE 4.5 在多个维度上表现出强大的竞争力。

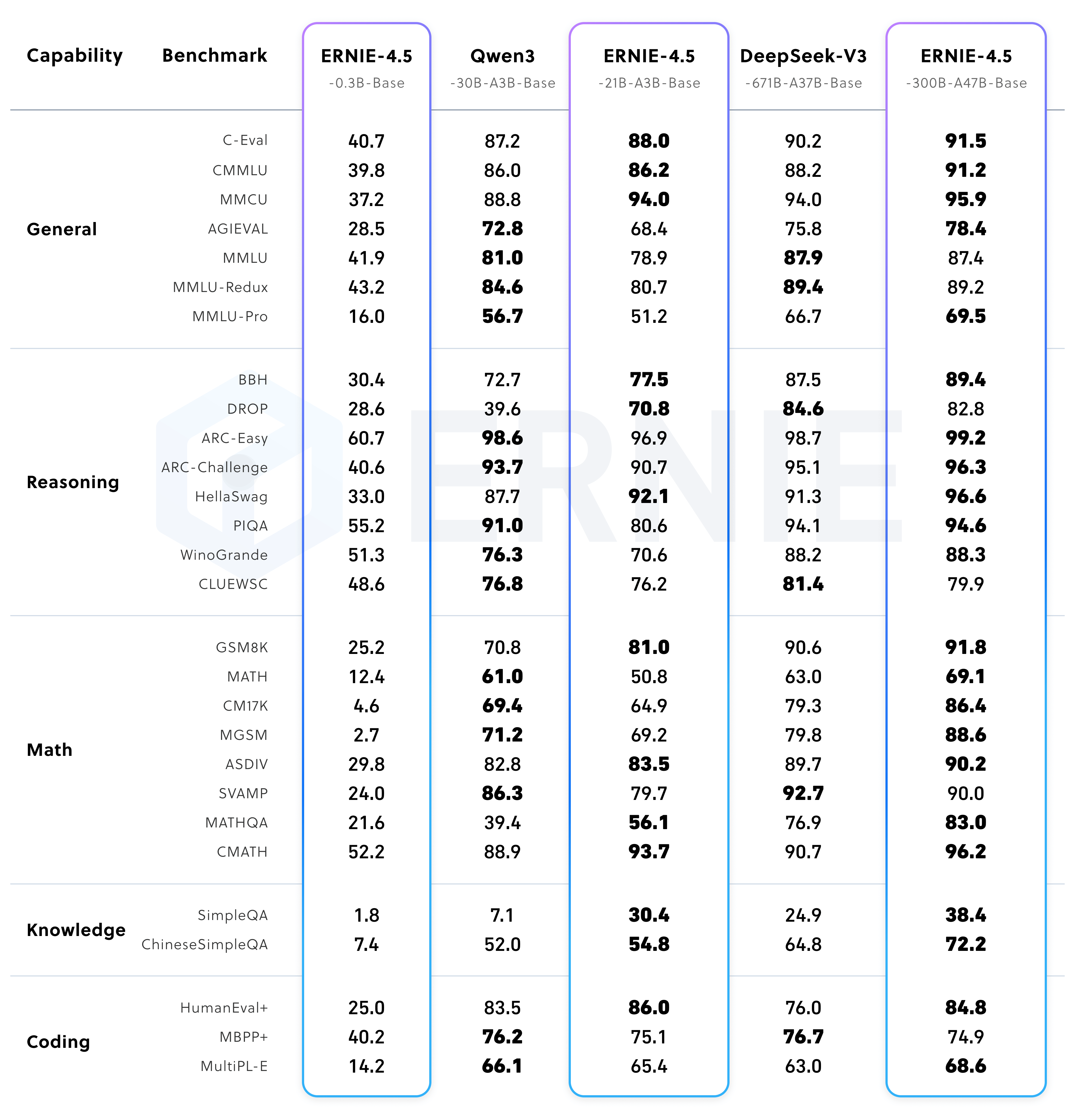

预训练基础模型性能

ERNIE-4.5-300B-A47B-Base 模型在 28 个基准测试中的 22 个上,其性能超越了 DeepSeek-V3-671B-A37B-Base。这表明该模型在通用性、推理和知识密集型任务上具备领先水平。

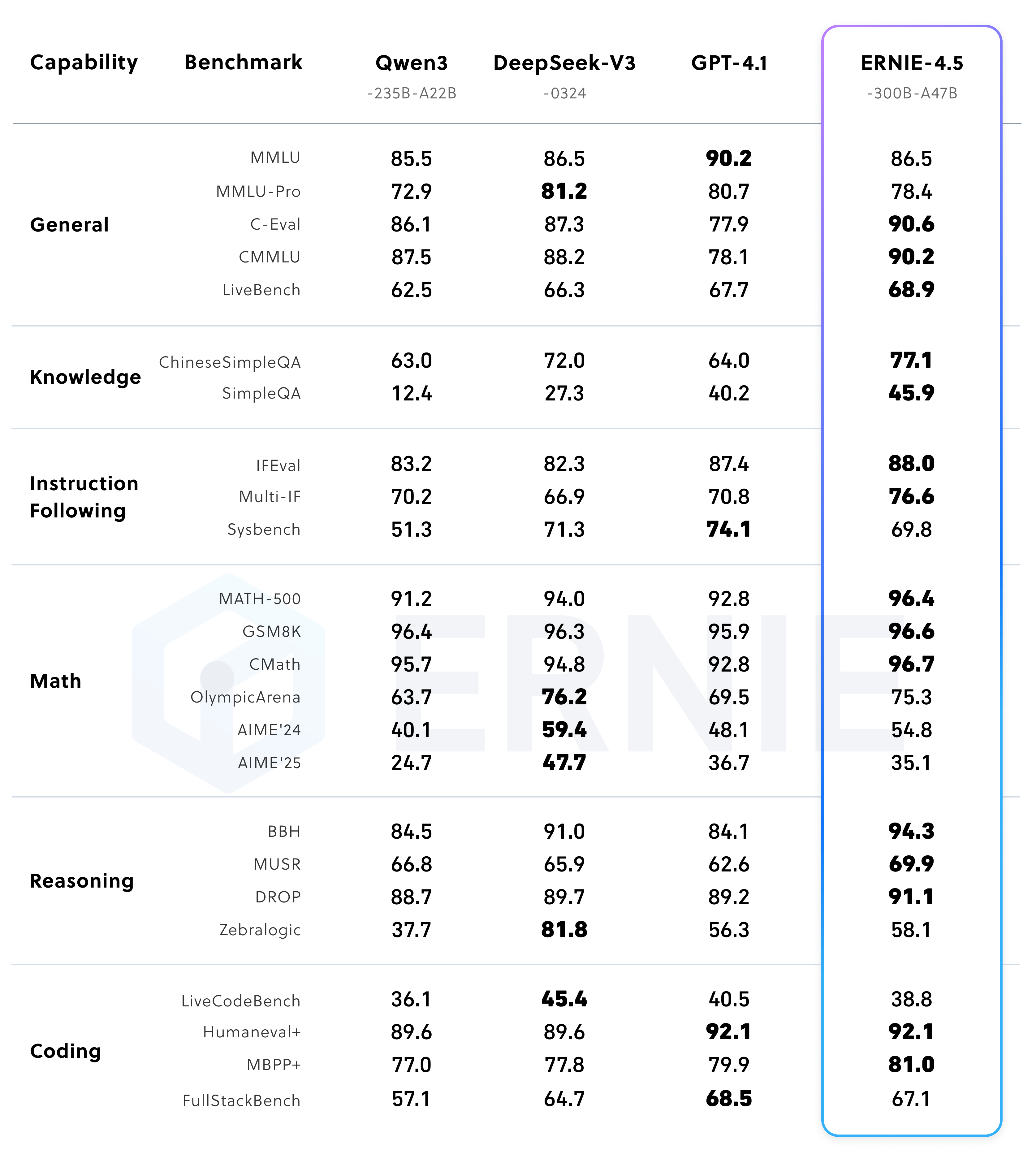

指令微调后模型性能

经过指令微调后的 ERNIE-4.5-300B-A47B 模型在指令遵循(IFEval)和知识问答(SimpleQA)等任务上取得了顶尖分数。

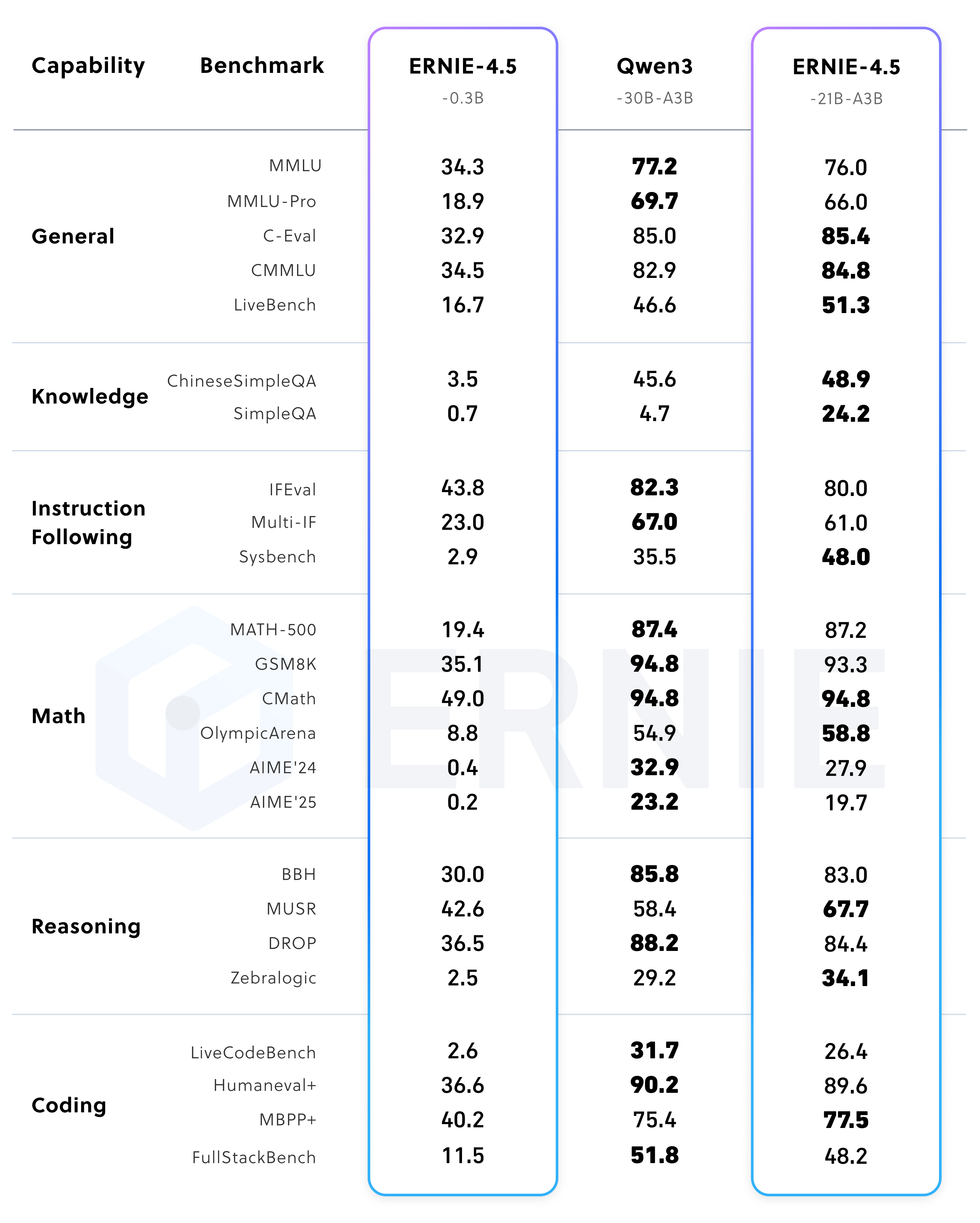

与此同时,参数规模更小的 ERNIE-4.5-21B-A3B 模型,其总参数量约是 Qwen3-30B 的 70%,但在 BBH 和 CMATH 等数学与推理基准上,表现优于后者,展示了较高的参数效率。

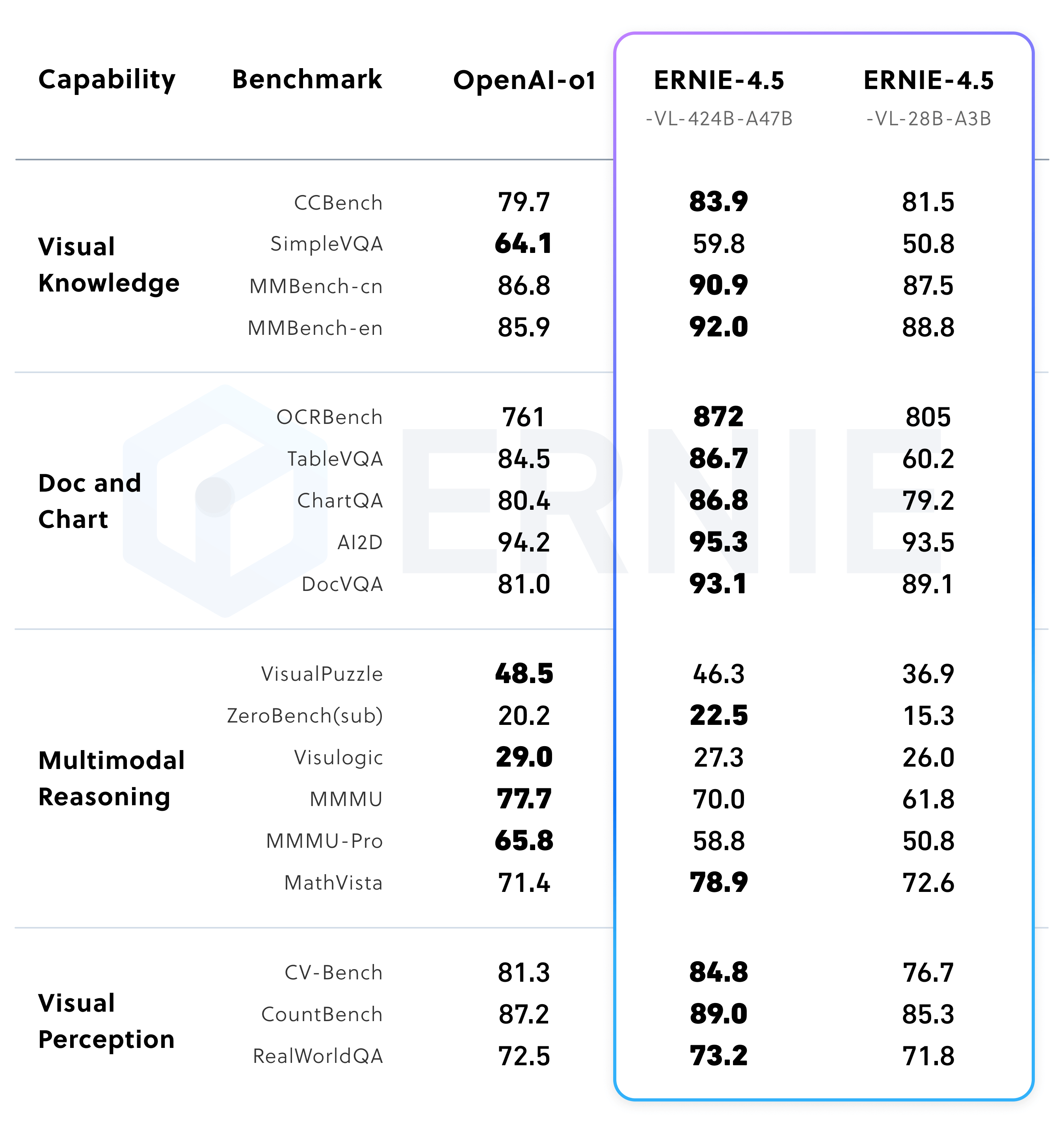

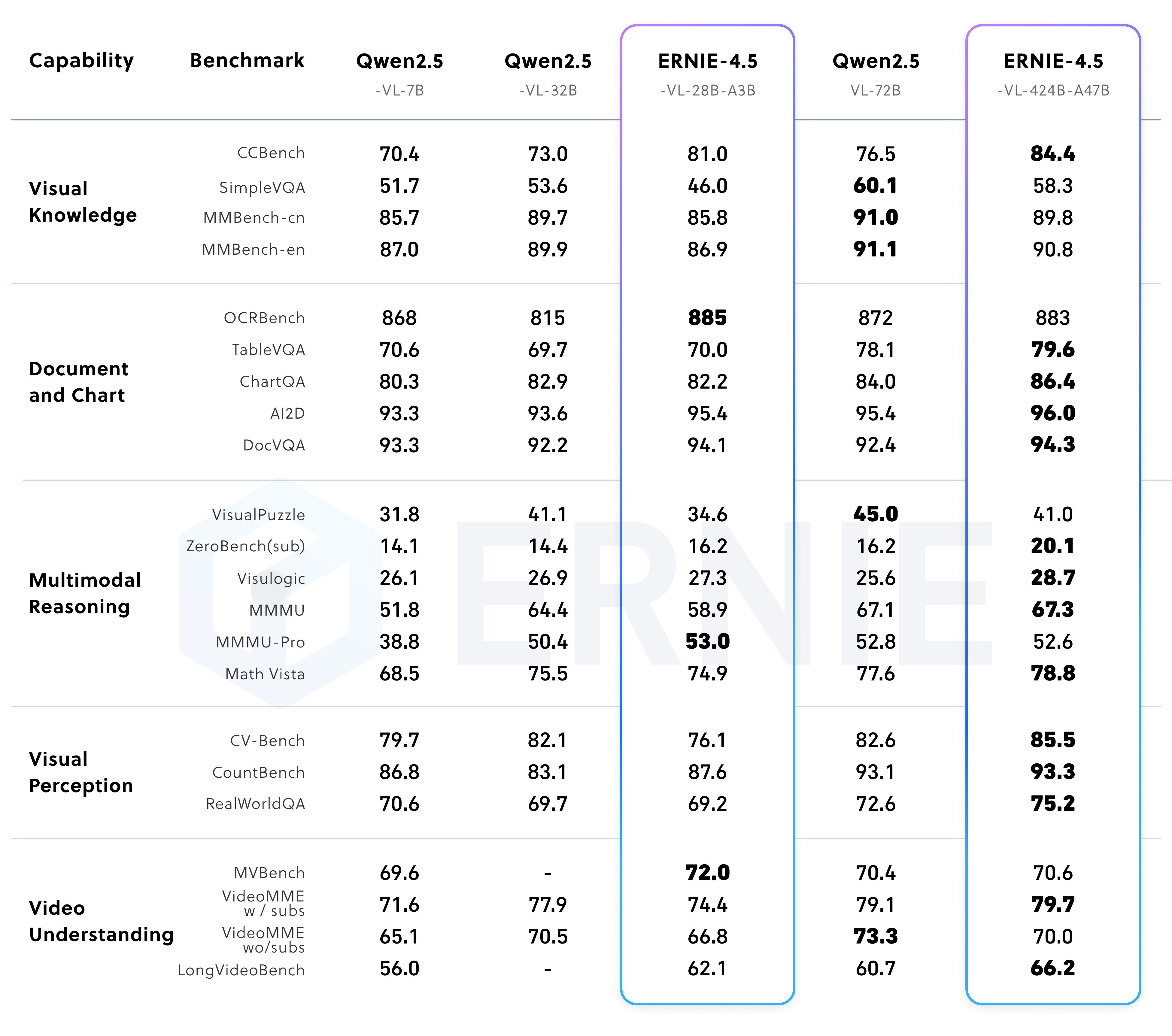

多模态模型性能

ERNIE 4.5 的视觉语言模型(VLM)支持“思维模式 (thinking mode)”和“非思维模式 (non-thinking mode)”。

在非思维模式下,模型专注于高效的视觉感知、文档和图表理解。而在思维模式下,模型在保持强大感知能力的同时,显著增强了在 MathVista、MMMU 等复杂基准上的推理能力。ERNIE-4.5-VL 的轻量级版本在多个基准上,其表现也足以媲美甚至超过了参数量更大的 Qwen2.5-VL-32B。

生态与工具链:ERNIEKit 和 FastDeploy

ERNIE 4.5 模型家族基于 PaddlePaddle 深度学习框架训练,同时也提供了 PyTorch 兼容的版本。百度此次发布了两个核心工具,旨在降低开发者的使用门槛。

- ERNIEKit:模型微调与对齐

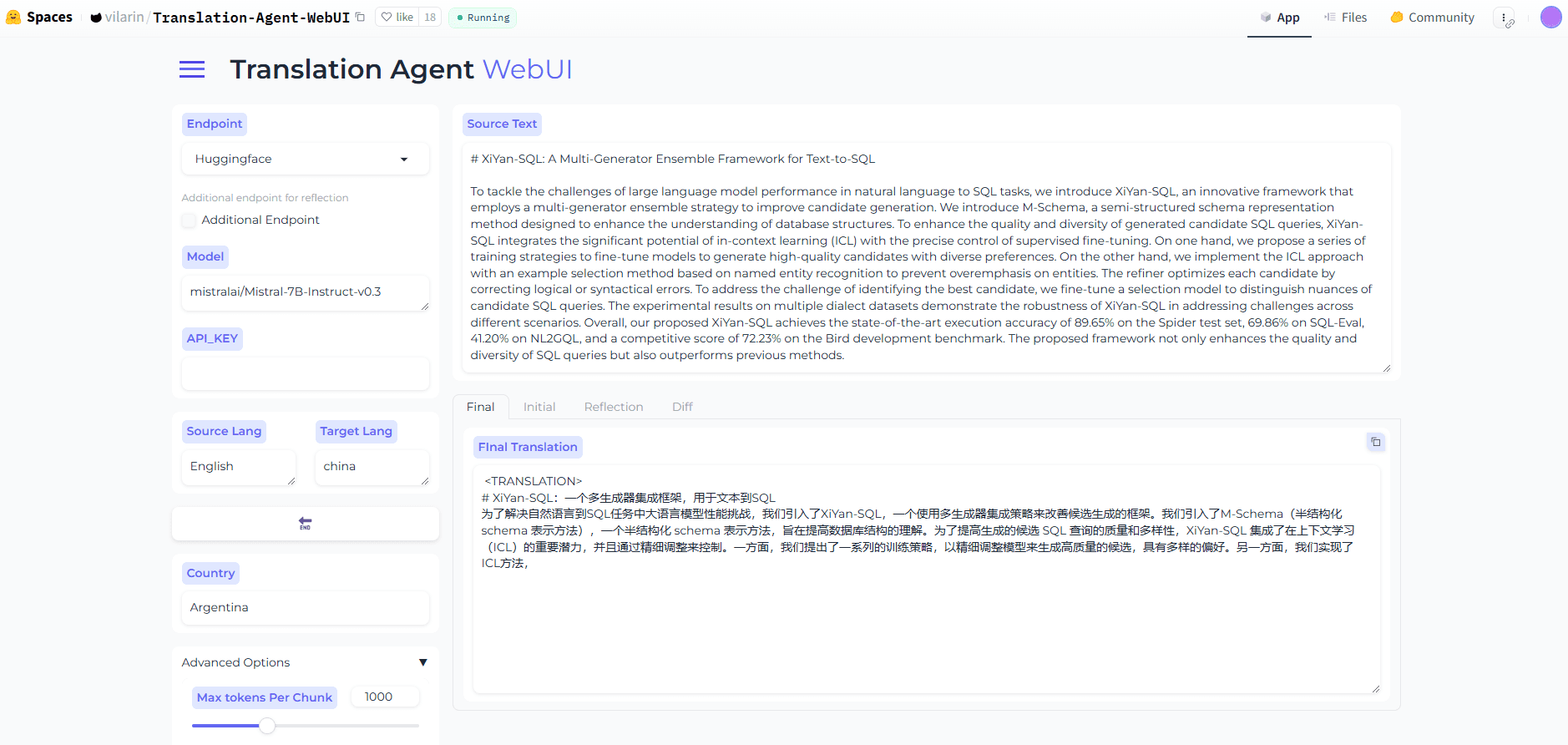

ERNIEKit是一个工业级开发工具包,支持监督微调(SFT)、直接偏好优化(DPO)以及LoRA、量化感知训练(QAT)和训练后量化(PTQ)等一系列主流的训练和压缩技术。开发者可以通过命令行工具下载模型并执行 SFT 或 DPO 任务。

# 下载模型 huggingface-cli download baidu/ERNIE-4.5-300B-A47B-Base-Paddle \ --local-dir baidu/ERNIE-4.5-300B-A47B-Base-Paddle # 监督微调 (SFT) erniekit train examples/configs/ERNIE-4.5-300B-A47B/sft/run_sft_wint8mix_lora_8k.yaml \ model_name_or_path=baidu/ERNIE-4.5-300B-A47B-Base-Paddle - FastDeploy:高效模型部署

FastDeploy是一个为大模型设计的高效部署工具包,其 API 兼容vLLM和OpenAI协议,支持一键式服务化部署。它为ERNIE 4.5的 MoE 模型提供了工业级的多机部署方案,并集成了低比特量化、上下文缓存和推测解码等加速技术。本地推理示例代码如下:

from fastdeploy import LLM, SamplingParams prompt = "Write me a poem about large language model." sampling_params = SamplingParams(temperature=0.8, top_p=0.95) llm = LLM(model="baidu/ERNIE-4.5-0.3B-Paddle", max_model_len=32768) outputs = llm.generate(prompt, sampling_params)服务化部署则可以通过一行命令启动:

python -m fastdeploy.entrypoints.openai.api_server \ --model "baidu/ERNIE-4.5-0.3B-Paddle" \ --max-model-len 32768 \ --port 9904

开源许可与引用

ERNIE 4.5 模型遵循 Apache License 2.0 协议,该许可允许商业使用。

如需在研究中引用,可使用以下 BibTeX 格式:

@misc{ernie2025technicalreport,

title={ERNIE 4.5 Technical Report},

author={Baidu ERNIE Team},

year={2025},

eprint={},

archivePrefix={arXiv},

primaryClass={cs.CL},

url={}

}